Kosteneffizientes Denken ist der Schlüssel zu Agentic Workflows

Wir bei Ninja AI glauben, dass modernste KI sowohl leistungsstark als auch zugänglich sein sollte, um Benutzern zu helfen, die Produktivität zu steigern, ohne das Budget zu sprengen. In den letzten zwei Jahren haben wir uns auf den Aufbau eines agilen Produktivitätssystems konzentriert und Ninja AI kontinuierlich um die neuesten KI-Fortschritte erweitert, um es intelligenter, schneller und leistungsfähiger zu machen.

Im Laufe der Zeit haben wir Funktionen eingeführt, die ausgefeilte agentische Workflows erfordern, wie z. B. Tiefgründige Recherche und Multi-Turn-Dateianalyse. Wir haben auch eine Beta-Version von veröffentlicht Arbeitsablauf planen, sodass Ninja Besprechungszeiten mit mehreren Teilnehmern per E-Mail aushandeln kann.

Während wir diese Fähigkeiten kontinuierlich verfeinern, erkennen wir, dass es dringend notwendig ist, Ninjas Intelligenz und Entscheidungsfähigkeit zu verbessern. Um Fehler bei Aufgaben mit hohem Risiko (z. B. das Ändern von Kalenderereignissen) zu reduzieren und autonomere Arbeitsabläufe zu ermöglichen (z. B. die Ausführung zusammengesetzter Aufgaben, die mit APIs und Personen interagieren), müssen unsere Agenten in vielen verschiedenen Situationen genauere Entscheidungen und Vorhersagen treffen.

Wir haben festgestellt, dass die Einbeziehung von „schrittweisem Denken“ in unsere Arbeitsabläufe deren Genauigkeit und Verallgemeinerungsfähigkeit erheblich verbessert. Schrittweises Denken ist ein Prozess, der Folgendes beinhaltet: Planung, Aufschlüsselung von Aufgaben, Rückverfolgung, Überprüfung und Reflexion vor der Ausführung von Aufgaben durch intelligente Funktionsaufrufe. Neuere Denkmodelle haben das „schrittweise Denken“ erfolgreich angewendet, um komplexe mathematische, naturwissenschaftliche und Programmierprobleme zu lösen. Aufgrund der folgenden Einschränkungen sind diese Modelle jedoch nicht für unsere Ninja Agentic-Workflows geeignet:

Erstens sind die meisten aktuellen Argumentationsmodelle sehr teuer. Zum Beispiel eine einzelne komplexe Agentenaufgabe mit Die O1-API von OpenAI könnte irgendwo zwischen 0,75$ und 2,25$ kosten1 - das sind „Kosten pro Aufgabe“, ein Preis, der für uns als Unternehmen wirtschaftlich nicht tragbar ist und auch für Kunden nicht rentabel ist, wenn wir die Kosten pro Aufgabe an sie weitergeben würden.

1Angenommen, für jede Agentenaufgabe sind geschätzte 5.000 bis 10.000 Eingabe-Token und 10.000 bis 30.000 Output-Token erforderlich

Zweitens verfügen die günstigeren Argumentationsmodelle nicht über die notwendigen Funktionen, um agentische Workflows zu unterstützen. Zum Beispiel ist DeepSeek R1 ein kostenloses Denkmodell — aber es ist begrenzt. R1 benötigt aufgrund seiner Größe Nvidia H200s-GPUs (oder besser) für eine hohe Latenz und einen niedrigen Durchsatz für das Modell. Daher ist es schwierig, es in einem aufgabenorientierten Chatsystem in Echtzeit zu verwenden. Die Verwendung von H200s macht den Betrieb auch teuer. Darüber hinaus steht R1 vor Schwierigkeiten bei der Bewältigung allgemeiner Funktionen und der Softwareentwicklung. Diese Einschränkungen werden im letzten Abschnitt des R1-Papier.

Darüber hinaus fehlen den bestehenden Argumentationsmodellen die Anpassungen. Bei Ninja streben wir danach, das fortschrittlichste Agentensystem für Produktivität zu entwickeln. Daher benötigen wir die Möglichkeit, die Modelle so anzupassen, dass sie unseren Bedürfnissen besser entsprechen. Dies ist nicht möglich, wenn Sie über die API auf aktuelle Argumentationsmodelle zugreifen oder bestehende große Open-Source-Denkmodelle (wie den 671B-Parameter R1) verwenden.

Angesichts dieser Nachteile haben wir beschlossen, unser eigenes Argumentationssystem — SuperAgent-R 2.0 — zu entwickeln, um ein nachhaltiges Agentensystem zu ermöglichen, das schnell, erschwinglich und für Kunden fein abstimmbar ist. \

Ninjas Denkmodell - SuperAgent-R 2.0

SuperAgent-R 2.0 ist ein zusammengesetztes KI-System: Es nutzt Ninjas eigenes, fein abgestimmtes Modell mit Argumentationsfähigkeit, das auf DeepSeek R1 basiert, das auf Llama 70B destilliert wurde. Der SuperAgent-R 2.0 verwendet auch andere Modelle, um das Denken durch fortschrittliche Optimierungen auf Inferenzebene zu unterstützen. Das gesamte System läuft von Anfang bis Ende der AWS-Infrastruktur und ist daher erschwinglich und skalierbar. Das Endergebnis bietet nahezu modernste Leistung zu einem Bruchteil der Kosten proprietärer Modelle wie OpenAis O, O3-Mini (hoch) oder Sonnet 3.7 von Anthropic (Denkmodus).

SuperAgent-R 2.0 vereint mehrere branchenweit erste Innovationen zu einem System, das komplexe Denkaufgaben zu niedrigen Kosten erledigen kann. Eine Schlüsselkomponente des Systems ist ein neuer Ansatz, bei dem mehrere Gear Reasoning-Methoden angewendet werden. Im Gegensatz zu anderen Modellen, die Benutzer auf ein festes Rechenniveau zwingen, passt unser System den Denkaufwand dynamisch an die Komplexität der Aufgabe an. Die Rechenleistung des SuperAgents ist wie folgt:

- Kein Nachdenken — Für unkomplizierte Suchen und schnelle Antworten.

- Leichtes Denken — Für Aufgaben mittlerer Komplexität wie strukturiertes Denken.

- Durchdachtes Denken — Für tiefgründige, mehrstufige Denkaufgaben, die eine fortgeschrittene Logik erfordern.

SuperAgent-R 2.0 kann den Argumentationsaufwand selbst bestimmen und sich automatisch an eine Benutzeranfrage anpassen. Zugegeben, das ist ständig schwer zu erreichen, da das System immer noch zu viel nachdenken kann. Wir überprüfen ständig das Feedback unserer Kunden und werden weiterhin Verbesserungen vornehmen.

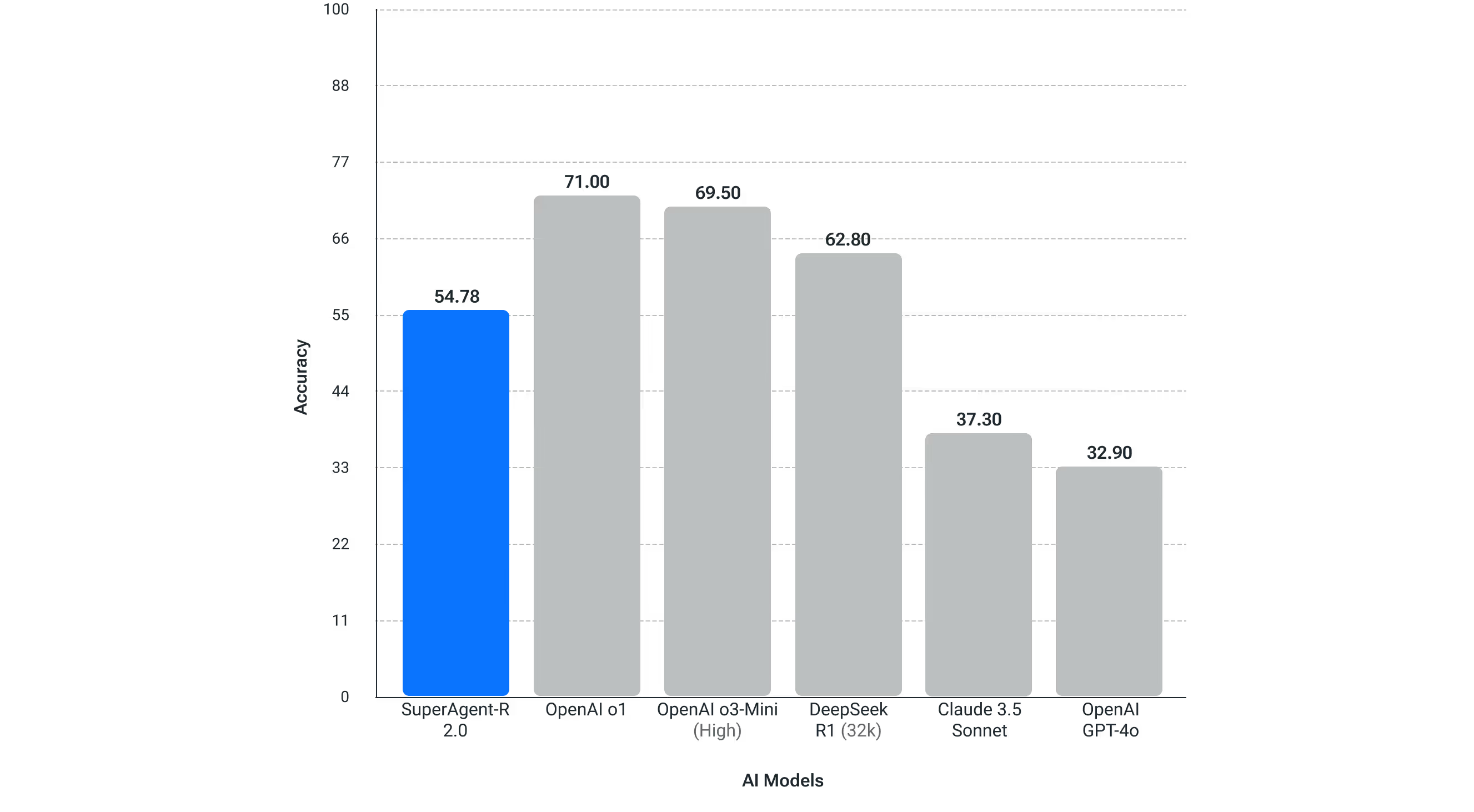

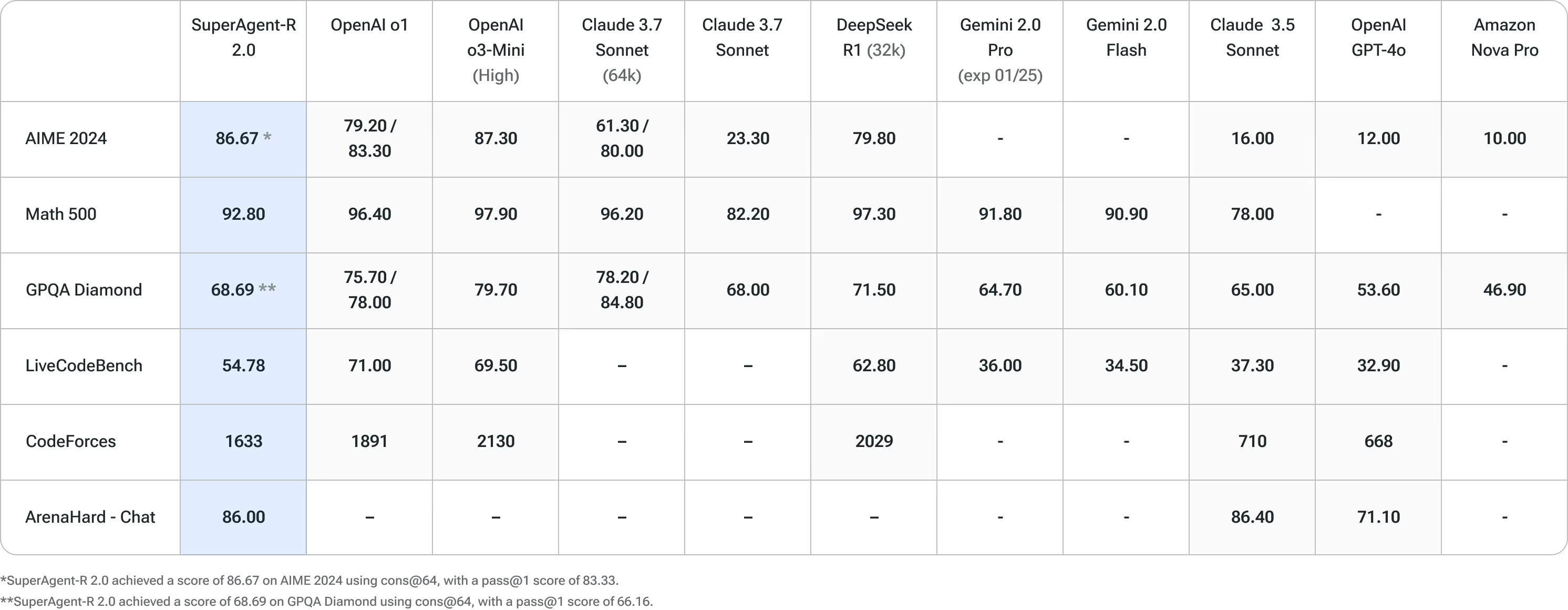

SuperAgent-R 2.0 wurde strengen Tests mit führenden KI-Benchmarks unterzogen und hat in mehreren Bereichen die beste Leistung seiner Klasse bewiesen. In diesen Tests konkurriert SuperAgent-R 2.0 durchweg mit führenden KI-Modellen und beweist seine überlegenen Denk- und Problemlösungsfähigkeiten.

Vorteile von SuperAgent-R 2.0 im Vergleich zu DeepSeek R1

DeepSeek-R1 hat in letzter Zeit zu Recht als hochwertiges, kostenloses Argumentationsmodell viel Aufmerksamkeit erregt. Es weist jedoch einige bemerkenswerte Nachteile auf. Eine wichtige Einschränkung sind die Hardwareanforderungen (die wir oben erwähnt haben) — es muss auf Nvidia H200-GPUs (oder besser) laufen, was die Betriebskosten erhöhen kann. Und selbst dann ist es kein schnelles Modell für schnelle Echtzeit-Inferenzen.

Darüber hinaus haben wir bei der Evaluierung von DeepSeek-R1 und der Überprüfung der Dokumentation weitere Nachteile festgestellt, die sich auf unsere Kunden auswirken könnten:

- Allgemeine Fähigkeiten: DeepSeek-R1 ist in Schlüsselbereichen wie Funktionsaufrufen, Multiturn-Interaktionen und komplexen Rollenspielen hinter DeepSeek-v3 zurück.

- Sprachfunktionen: DeepSeek-R1 ist für Chinesisch und Englisch optimiert, was zu Problemen bei der Bearbeitung von Abfragen in anderen Sprachen führen kann. Da wir Benutzer in mehreren Sprachen unterstützen, ist eine umfassendere Sprachunterstützung unerlässlich.

- Aufforderungsempfindlichkeit: DeepSeek-R1 reagiert sehr empfindlich auf Prompt-Variationen. Die bei Kunden übliche Aufforderung mit wenigen Schüssen beeinträchtigt die Gesamtleistung und macht sie für unsere Anforderungen weniger zuverlässig.

- Aufgaben der Softwareentwicklung: Benchmark-Ergebnisse deuten darauf hin, dass DeepSeek-R1 nur über begrenzte Software-Engineering-Fähigkeiten verfügt. Angesichts der Tatsache, dass sich viele unserer Kunden bei softwarebezogenen Aufgaben auf Ninja verlassen, würde sich diese Einschränkung erheblich auf ihre Erfahrung auswirken.

DeepSeek R1 ist ein fantastisches Modell, aber diese Faktoren machen DeepSeek R1 für unsere Bedürfnisse weniger geeignet und haben unsere Entscheidung zur Entwicklung von SeuperAgent-R 2.0 beeinflusst.

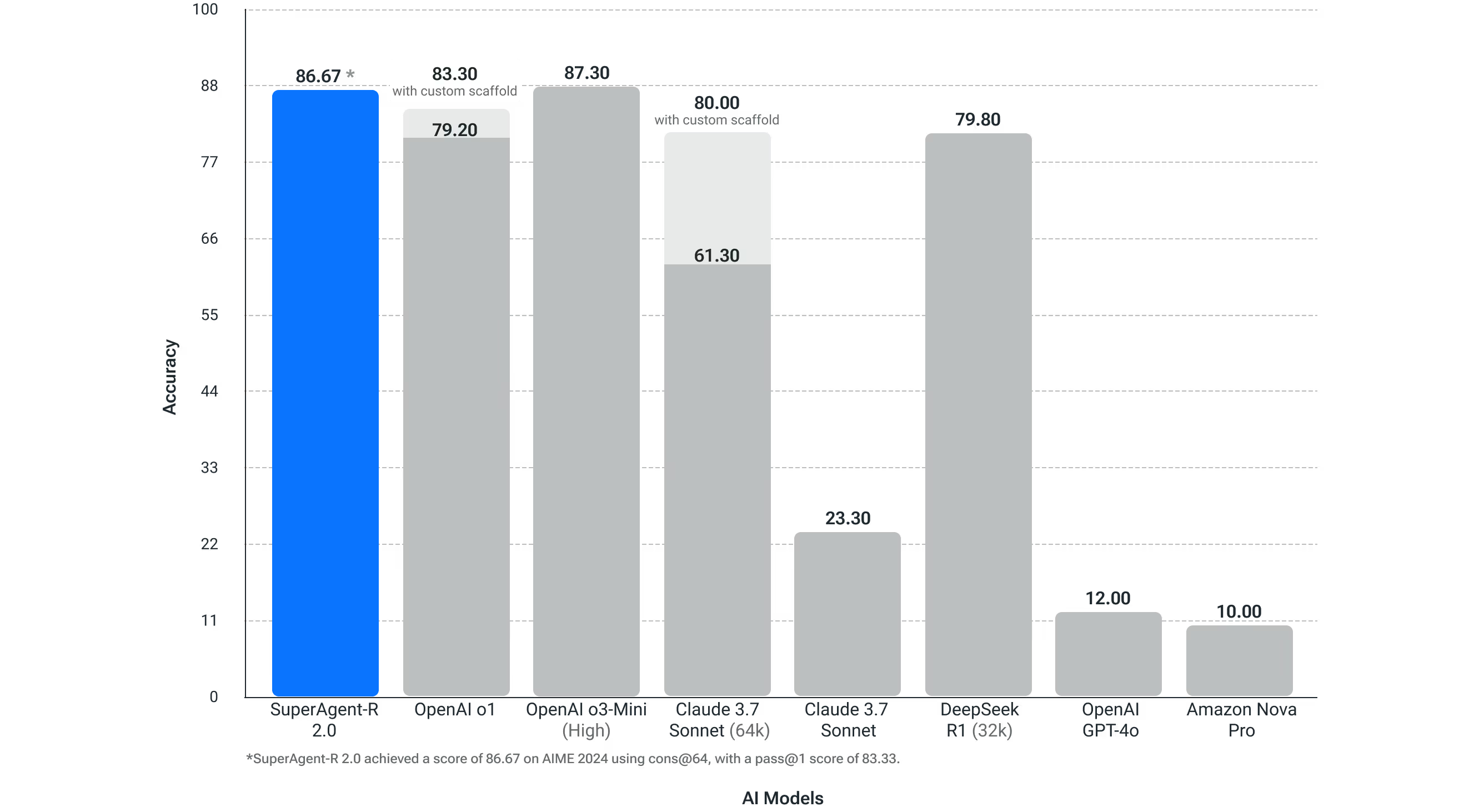

Wettkampf Mathe (AIME 2024)

Für Competitive Math, eine Determinante der Denkfähigkeit, haben unsere Tests gezeigt, dass SuperAgent-R 2.0 die Leistung von OpenAI O1, Sonnet 3.7 (64k erweitertes Denken) und DeepSeek R1-Modellen übertrifft und SuperAgent-R 2.0 dem OpenAI O3-High-Reasoning-Modell ebenbürtig ist. OpenAI hat veröffentlichte Daten dass ein Modell, das gut in Competitive Math ist, wie AIME 2024, gut für autonome agentische Workflows sein wird.

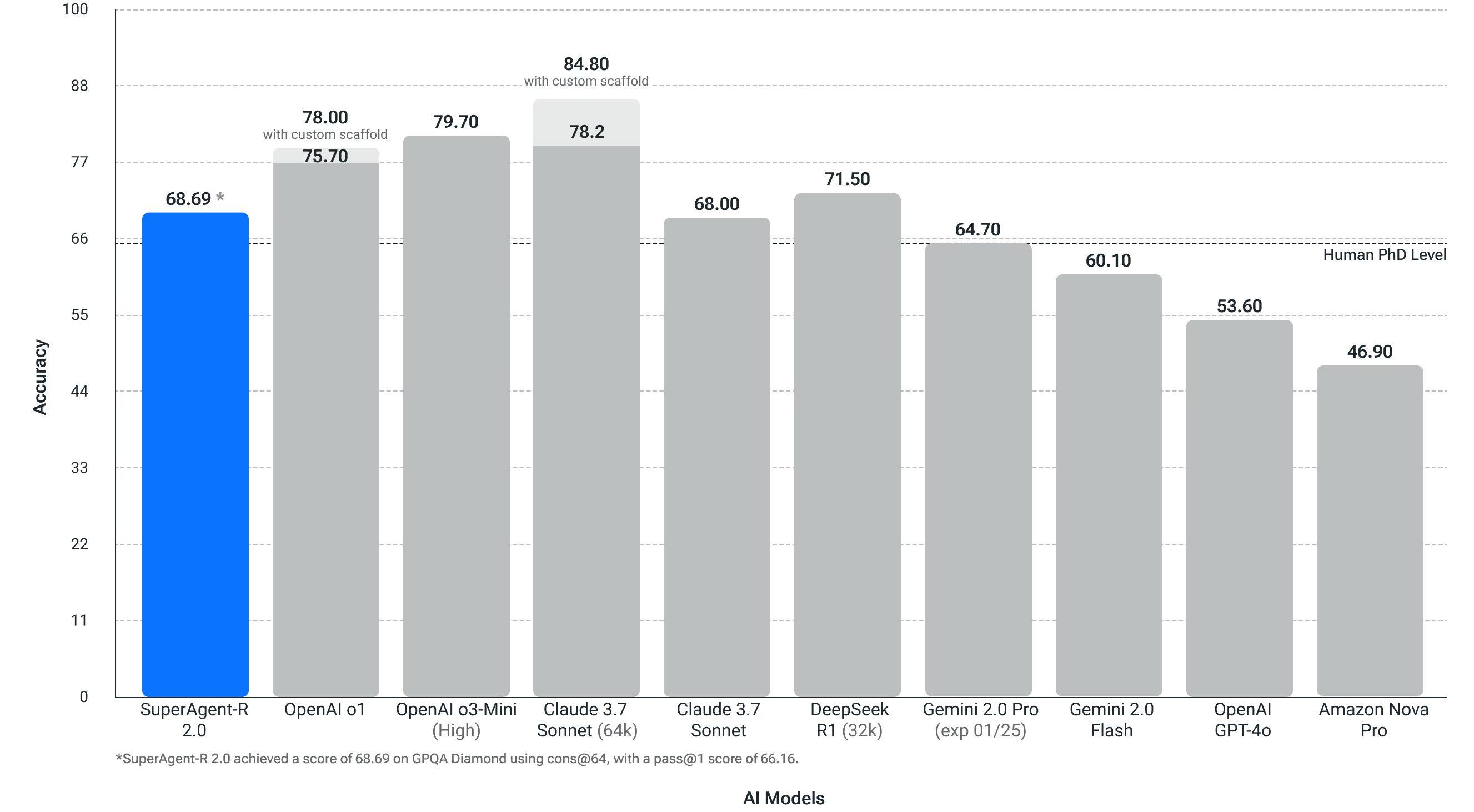

Wissenschaftliche Fragen auf Doktorandenebene (GPQA Diamond)

Dieser Test misst, wie gut ein System wissenschaftliche Fragen auf Doktorandenebene lösen kann. Dieser Test ist wichtig für unsere Benutzer, die in vielen verschiedenen Branchen arbeiten und verschiedene Berufsfunktionen haben. SuperAgent-R 2.0 übertraf die Genauigkeit der menschlichen Doktorarbeit bei diesem Benchmark für physikalische, biologische und chemische Probleme.

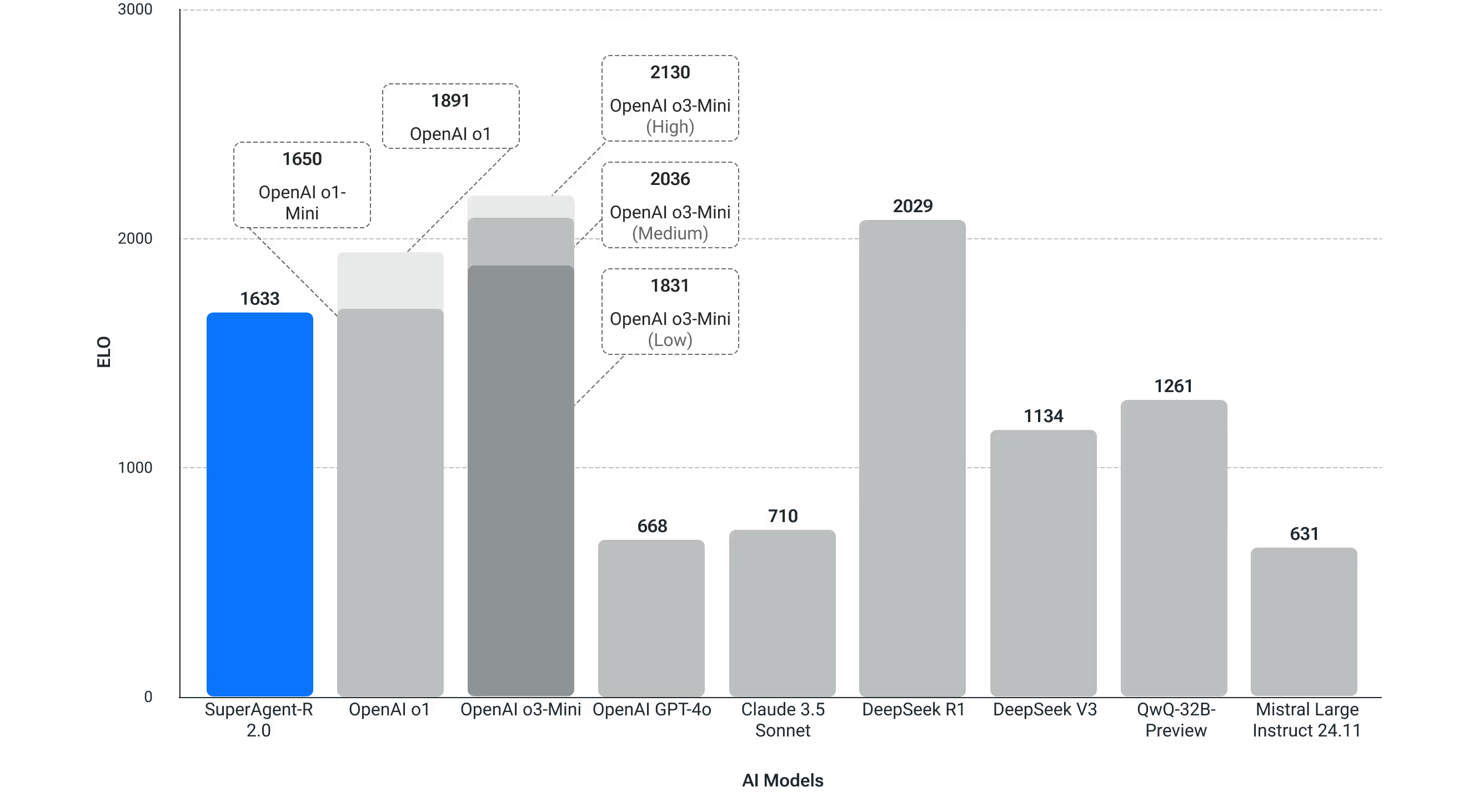

Wettbewerbsordnung (Codeforces)

Bei der wettbewerbsfähigen Programmierung von Codeforces erzielt SuperAgent-R 2.0 zunehmend höhere ELO-Werte als DeepSeek V3 und bei vielen OpenAI-Modellen wettbewerbsfähige Ergebnisse.

LiveBench - Codierung

Wird verwendet, um die Codierungsleistung in der realen Welt zu testen.

SuperAgent-R 2.0 ist unter myninja.ai verfügbar

Im Gegensatz zu anderen Produkten auf dem Markt erheben wir keine zusätzlichen Abonnementgebühren für den unbegrenzten Zugriff auf das SuperAgent-R 2.0-Modell. Dieses Modell steht allen Ultra-Nutzern (15 USD/Monat) und Nutzern des Business-Tarifs (20 USD/Monat/Sitzplatz) zur Verfügung. Einzelheiten zur Preisgestaltung. Bitte beachten Sie, dass wir uns das Recht vorbehalten, die Nutzung aufgrund übermäßiger Nutzung einzuschränken.

Probiere es aus unter myninja.ai

Was kommt als Nächstes: Neue Fähigkeiten und API-Zugriff

Mit Blick auf die Zukunft werden wir weiterhin agentische Workflows bereitstellen, die auf dem SuperAgent-R 2.0 basieren, um unseren Benutzern zu mehr Produktivität zu verhelfen. Eine der ersten Möglichkeiten, SuperAgent-R 2.0 zu verwenden, ist die Verbesserung unserer DeepResearch-Funktion.

Wir planen auch, bald API-Zugriff auf SuperAgent-R 2.0 bereitzustellen, um Entwicklern und Unternehmen dabei zu helfen, ihre eigenen maßgeschneiderten Systeme zu erstellen.