Un ragionamento efficiente in termini di costi è fondamentale per i flussi di lavoro di Agentic

Noi di Ninja AI crediamo che l'intelligenza artificiale all'avanguardia debba essere potente e accessibile, aiutando gli utenti a incrementare la produttività senza spendere una fortuna. Negli ultimi due anni ci siamo concentrati sulla creazione di un sistema di produttività agentico, aggiungendo continuamente i più recenti progressi dell'IA a Ninja AI per renderla più intelligente, veloce e capace.

Lungo il percorso abbiamo introdotto funzionalità che richiedono sofisticati flussi di lavoro agentici, come Ricerca approfondita e Analisi dei file multiturno. Abbiamo anche lanciato una versione beta di pianificazione del flusso di lavoro, permettendo a Ninja di negoziare gli orari delle riunioni con più partecipanti via e-mail.

Perfezionando continuamente queste competenze, riconosciamo un'esigenza fondamentale: migliorare l'intelligenza e il processo decisionale di Ninja. La riduzione degli errori nelle attività ad alto rischio (ad esempio, la modifica degli eventi del calendario) e l'abilitazione di flussi di lavoro più autonomi (ad esempio, l'esecuzione di attività composite che interagiscono con le API e le persone) richiedono ai nostri agenti di prendere decisioni e previsioni più accurate in molti tipi diversi di situazioni.

Abbiamo scoperto che l'integrazione del «pensiero passo dopo passo» nei nostri flussi di lavoro aumenta significativamente la loro precisione e capacità di generalizzazione. Il pensiero passo-passo è un processo che prevede: la pianificazione, la suddivisione delle attività, il backtracking, la verifica e la riflessione prima di eseguire le attività mediante chiamate intelligenti di funzioni. I recenti modelli di ragionamento hanno applicato con successo il «pensiero passo dopo passo» per risolvere complessi problemi matematici, scientifici e di programmazione. Tuttavia, a causa delle seguenti limitazioni, questi modelli non sono adatti ai nostri flussi di lavoro Ninja Agentic:

Innanzitutto, la maggior parte dei modelli di ragionamento attuali sono molto costosi. Ad esempio, un singolo compito agentico complesso che utilizza API O1 di OpenAI potrebbe costare tra $0,75 e $2,251 - vale a dire il costo «per attività», un prezzo economicamente insostenibile per noi come azienda e anche non sostenibile per i clienti se trasferissimo loro i costi per attività.

1Supponendo che ogni attività agentica richieda da 5.000 a 10.000 token di input e da 10.000 a 30.000 token di output

In secondo luogo, i modelli di ragionamento più convenienti non hanno le caratteristiche necessarie per alimentare i flussi di lavoro agentici. Ad esempio, DeepSeek R1 è un modello di ragionamento gratuito, ma è limitato. R1, a causa delle sue dimensioni, richiede GPU Nvidia H200s (o superiori) per garantire un'elevata latenza e un basso throughput per il modello, il che rende difficile l'utilizzo in un sistema di chat in tempo reale orientato alle attività. L'uso dell'H200s ne rende inoltre costoso l'utilizzo. Inoltre, R1 presenta difficoltà nella gestione delle capacità generali e delle attività di ingegneria del software: queste limitazioni sono confermate dall'ultima sezione del Carta R1.

Inoltre, i modelli di ragionamento esistenti mancano delle personalizzazioni. In Ninja, aspiriamo a creare il sistema agentico più avanzato per la produttività. Pertanto, abbiamo bisogno della capacità di mettere a punto i modelli per adattarli meglio alle nostre esigenze. Ciò non è possibile quando si accede ai modelli di ragionamento attuali tramite API o si utilizzano modelli di ragionamento open source di grandi dimensioni esistenti (come il parametro 671B R1).

Alla luce di questi inconvenienti, abbiamo deciso di progettare il nostro sistema di ragionamento, SuperAgent-R 2.0, per aiutarci a creare un sistema agentico sostenibile che sia veloce, conveniente e ottimizzabile per i clienti. \

Il modello di ragionamento di Ninja - SuperAgent-R 2.0

SuperAgent-R 2.0 è un sistema AI composto: sfrutta il modello perfezionato di Ninja con capacità di ragionamento, basato su DeepSeek R1 distillato su Llama 70B. Il SuperAgent-R 2.0 utilizza anche altri modelli per supportare il ragionamento tramite ottimizzazioni avanzate a livello di inferenza. L'intero sistema viene eseguito end-to-end sull'infrastruttura AWS, il che lo rende conveniente e scalabile. Il risultato finale offre prestazioni quasi all'avanguardia a una frazione del costo di modelli proprietari come O, O3-mini (alto) di OpenAI o Sonnet 3.7 (modalità di pensiero) di Anthropic.

SuperAgent-R 2.0 riunisce diverse innovazioni innovative del settore per creare un sistema in grado di completare attività di ragionamento complesse a costi contenuti. Un componente chiave del sistema è un nuovo approccio Multi-Gear Reasoning. A differenza di altri modelli che obbligano gli utenti a un livello di calcolo fisso, il nostro sistema regola dinamicamente lo sforzo di ragionamento in base alla complessità del compito. I livelli di calcolo del SuperAgent sono:

- No Thinking: per ricerche semplici e risposte rapide.

- Light Thinking: per attività di media complessità come il ragionamento strutturato.

- High Thinking: per attività di ragionamento approfondite in più fasi che richiedono una logica avanzata.

SuperAgent-R 2.0 può autodeterminare lo sforzo di ragionamento e adattarsi automaticamente alla richiesta dell'utente. Certo, questo è sempre difficile da ottenere perché il sistema riesce ancora a pensare troppo. Esaminiamo costantemente il feedback dei clienti e continueremo ad apportare miglioramenti.

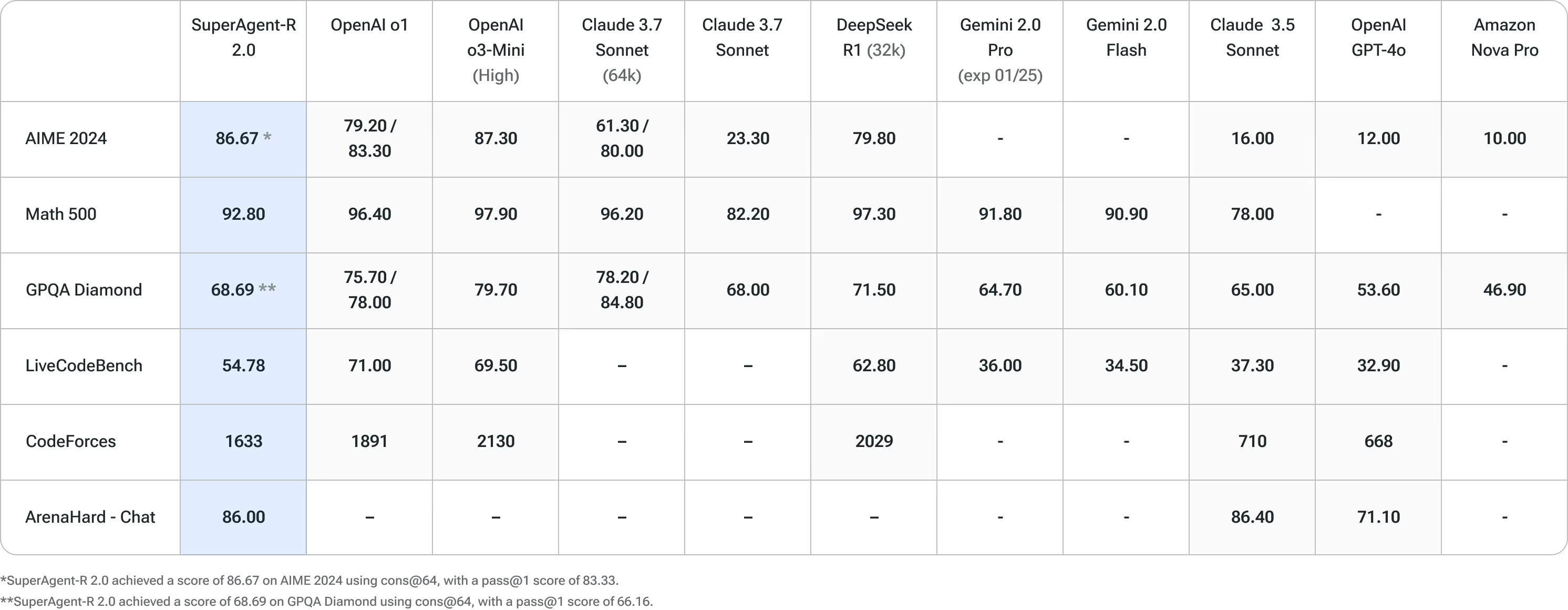

SuperAgent-R 2.0 è stato sottoposto a test rigorosi rispetto ai principali benchmark di intelligenza artificiale, dimostrando le migliori prestazioni della categoria in più domini. In questi test, SuperAgent-R 2.0 è costantemente competitivo con i principali modelli di intelligenza artificiale, dimostrando le sue superiori capacità di ragionamento e risoluzione dei problemi.

Vantaggi di SuperAgent-R 2.0 rispetto a DeepSeek R1

DeepSeek-R1, giustamente, ha ricevuto molta attenzione di recente come modello di ragionamento libero di alta qualità. Tuttavia, presenta alcuni notevoli inconvenienti. Una delle principali limitazioni è il requisito hardware (che abbiamo menzionato sopra): deve funzionare con GPU Nvidia H200 (o migliori), il che può aumentare i costi operativi; e anche in questo caso, non è un modello veloce per un'inferenza rapida in tempo reale.

Inoltre, dopo aver valutato DeepSeek-R1 e esaminato la relativa documentazione, abbiamo identificato altri inconvenienti che potrebbero avere un impatto sui nostri clienti:

- Capacità generale: DeepSeek-R1 non è all'altezza di DeepSeek-v3 in aree chiave come la chiamata di funzioni, le interazioni a più turni e i giochi di ruolo complessi.

- Funzionalità linguistiche: DeepSeek-R1 è ottimizzato per il cinese e l'inglese, il che può causare problemi nella gestione delle domande in altre lingue. Poiché supportiamo gli utenti in più lingue, è essenziale un supporto linguistico più ampio.

- Sensibilità dei prompt: DeepSeek-R1 è altamente sensibile alle variazioni dei prompt. I prompt con pochi clic, una pratica comune tra i clienti, degradano le prestazioni complessive, rendendole meno affidabili per le nostre esigenze.

- Attività di ingegneria del software: i risultati del benchmark indicano che DeepSeek-R1 ha capacità di ingegneria del software limitate. Dato che molti dei nostri clienti si affidano a Ninja per attività relative al software, questa limitazione avrebbe un impatto significativo sulla loro esperienza.

DeepSeek R1 è un modello fantastico, ma questi fattori rendono DeepSeek R1 meno adatto alle nostre esigenze e ci hanno portato alla decisione di sviluppare SeuperAgent-R 2.0.

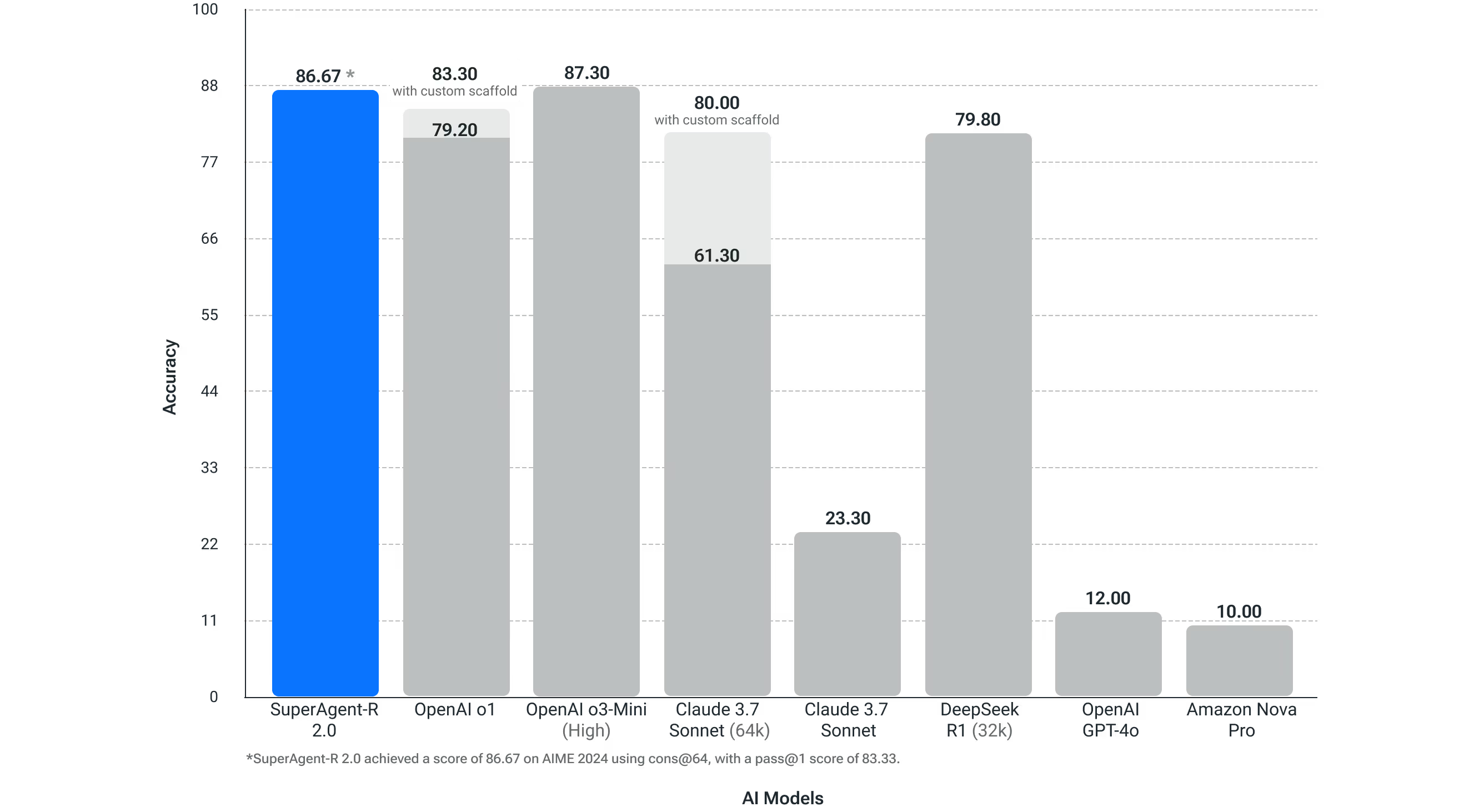

Matematica da competizione (AIME 2024)

Per Competitive Math, un fattore determinante della capacità di ragionamento, i nostri test hanno dimostrato che SuperAgent-R 2.0 sta superando le prestazioni dei modelli OpenAI O1, Sonnet 3.7 (64-bit extended thinking), DeepSeek R1 e SuperAgent-R 2.0 è alla pari con il modello di ragionamento OpenAI O3-High. OpenAI ha dati pubblicati che un modello che è bravo in matematica competitiva come AIME 2024, sarà valido nei flussi di lavoro agentici autonomi.

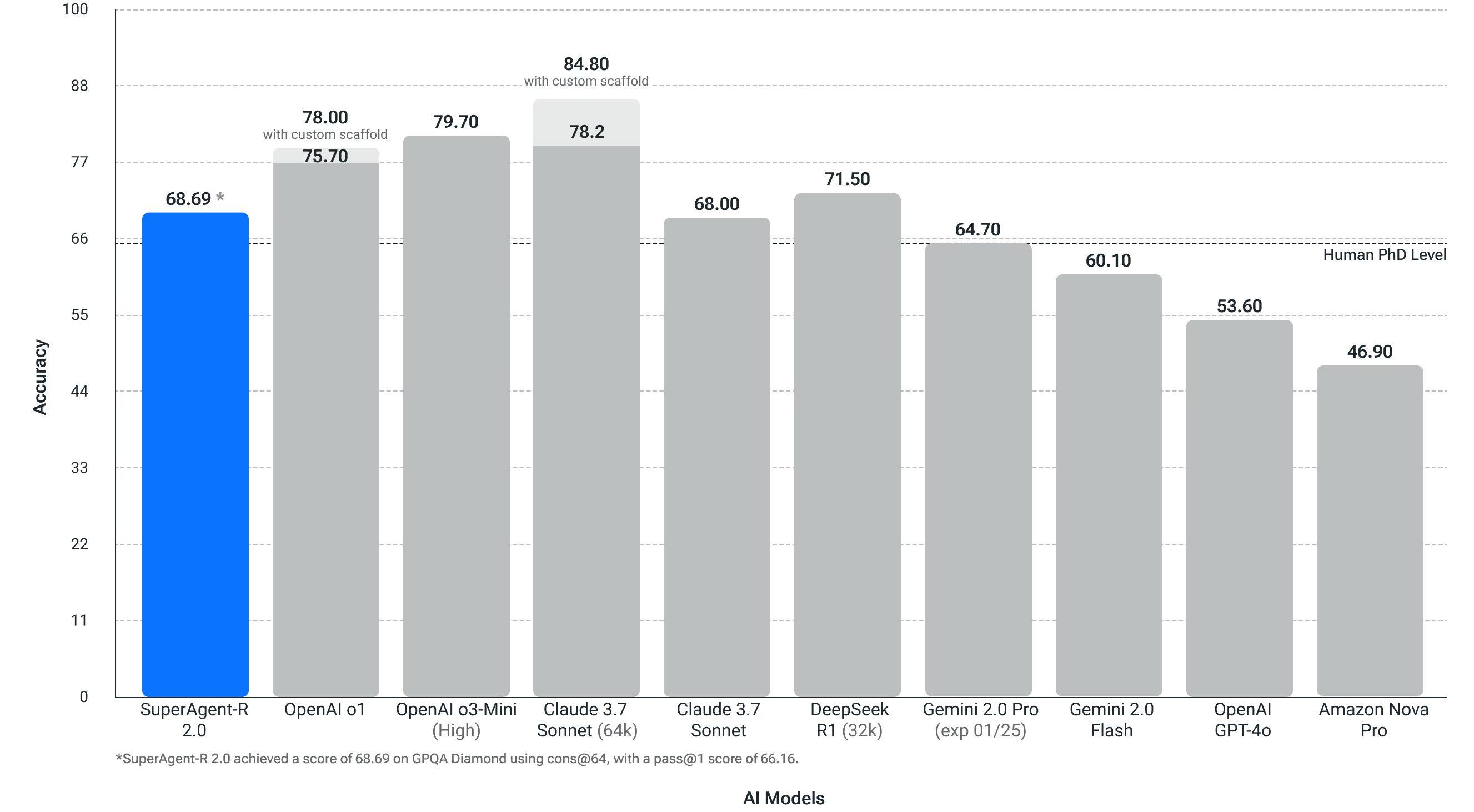

Domande scientifiche a livello di dottorato (GPQA Diamond)

Questo test misura la capacità di un sistema di risolvere domande scientifiche a livello di dottorato. Questo test è importante per i nostri utenti che lavorano in molti settori diversi e hanno diverse funzioni lavorative. SuperAgent-R 2.0 ha superato il livello di precisione dei dottorati umani in questo benchmark di problemi di fisica, biologia e chimica.

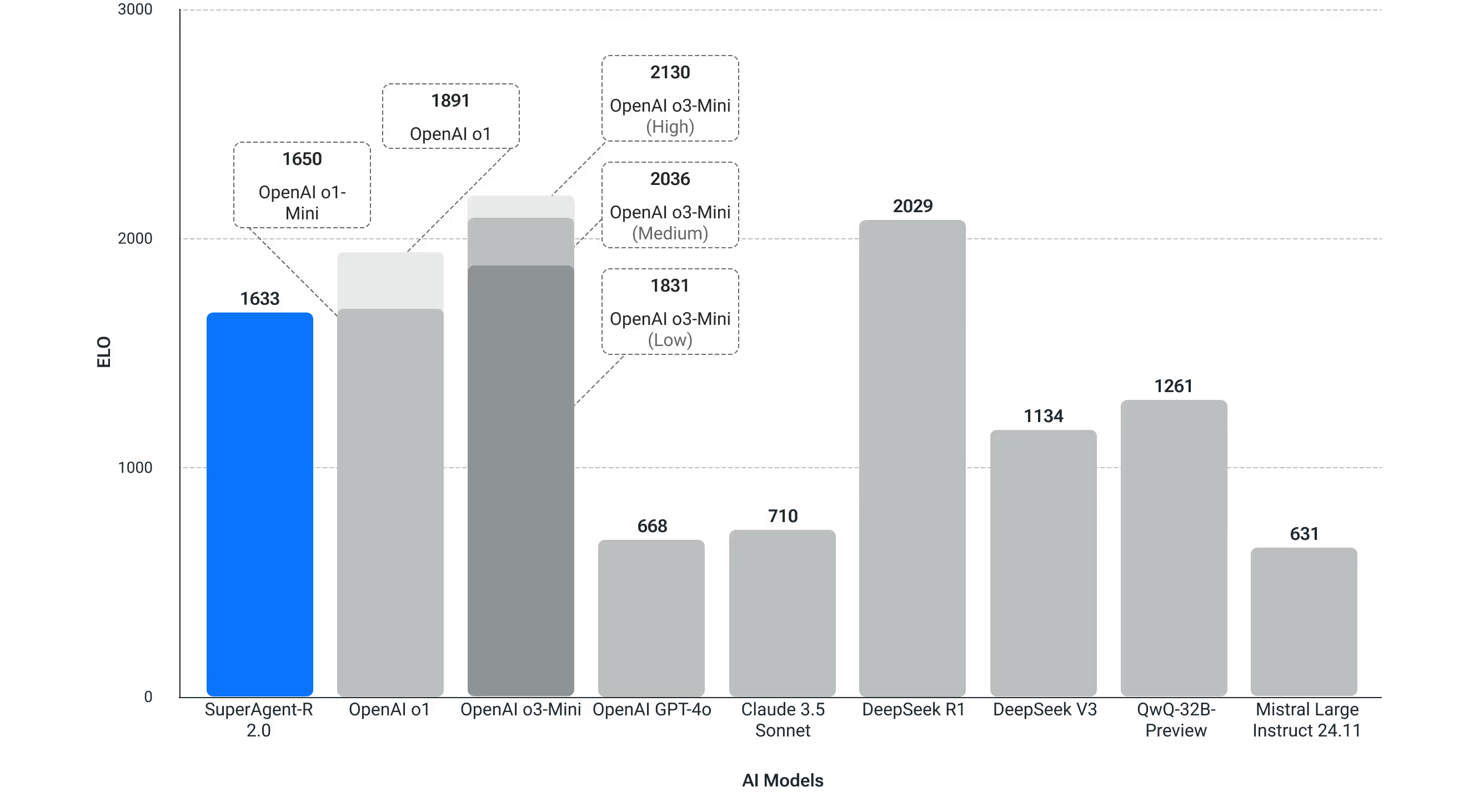

Codice della concorrenza (Codeforces)

Nella programmazione competitiva di Codeforce, SuperAgent-R 2.0 ottiene punteggi ELO progressivamente più alti rispetto a DeepSeek V3 e punteggi competitivi con molti modelli OpenAI.

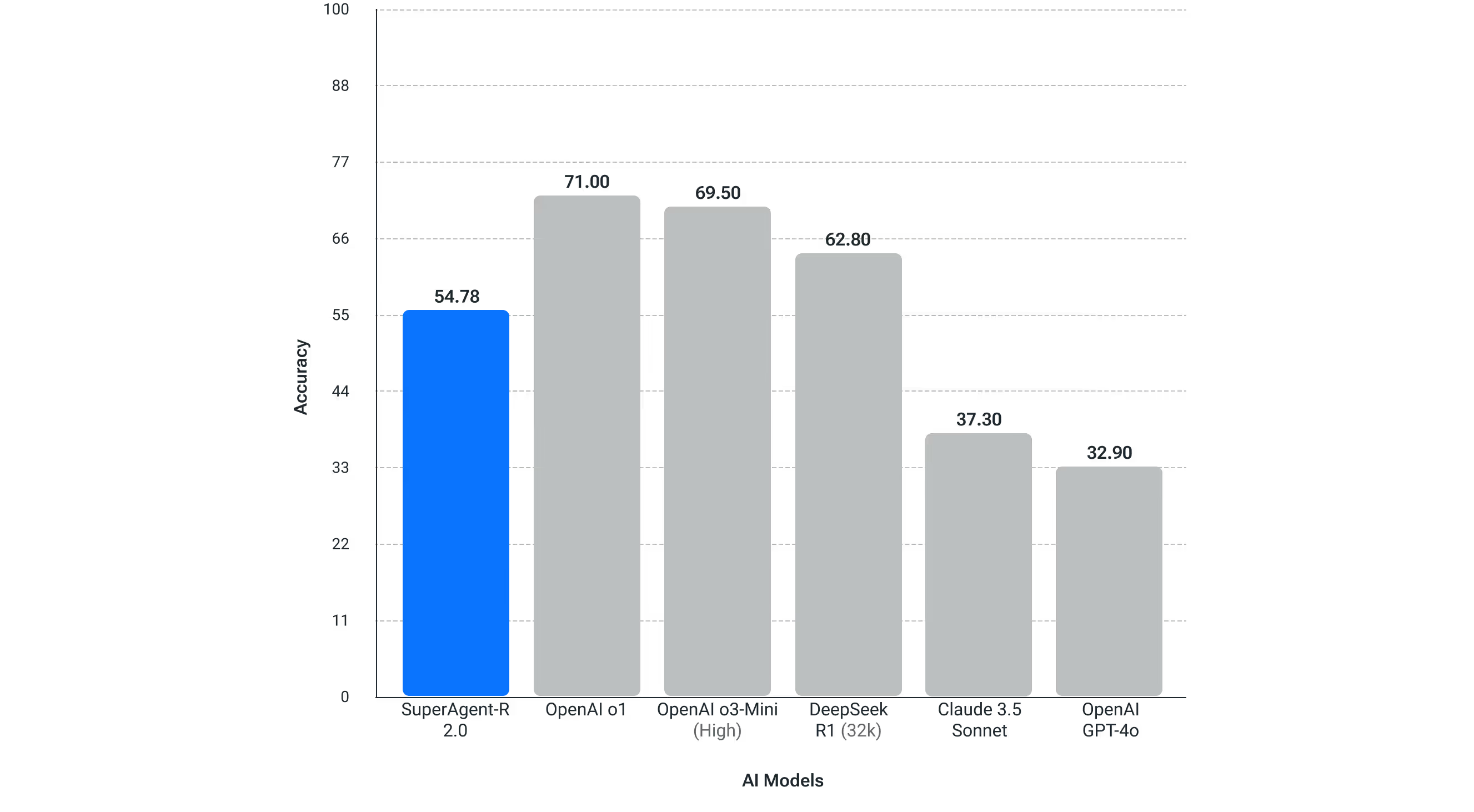

LiveBench - Codifica

Utilizzato per testare le prestazioni di codifica nel mondo reale.

SuperAgent-R 2.0 è disponibile all'indirizzo myninja.ai

A differenza di vari prodotti sul mercato, non addebiteremo costi di abbonamento aggiuntivi per l'accesso illimitato al modello SuperAgent-R 2.0. Questo modello è disponibile per tutti i nostri utenti Ultra (15 USD al mese) e per gli utenti del piano Business (20 USD al mese per postazione). Dettagli sui prezzi. Tieni presente che ci riserviamo il diritto di limitare l'uso in base a un uso eccessivo.

Provalo su myninja.ai

Cosa c'è dopo: nuove competenze e accesso alle API

Guardando al futuro, continueremo a fornire flussi di lavoro agentici, basati su SuperAgent-R 2.0, per aiutare i nostri utenti a essere più produttivi. Uno dei primi modi in cui intendiamo utilizzare SuperAgent-R 2.0 è quello di migliorare la nostra funzione DeepResearch.

Prevediamo inoltre di fornire presto l'accesso API a SuperAgent-R 2.0, aiutando sviluppatori e aziende a creare i propri sistemi personalizzati.