NinjaBenchmark Ninja AIAI Benchmarks

Scopri come i modelli di Ninja si comportano testa a testa contro GPT, Claude, Gemini e altri importanti modelli di intelligenza artificiale in attività di ragionamento, codifica e agentiche, con risultati trasparenti e riproducibili.

Super Ninja

Gaia Benchmark

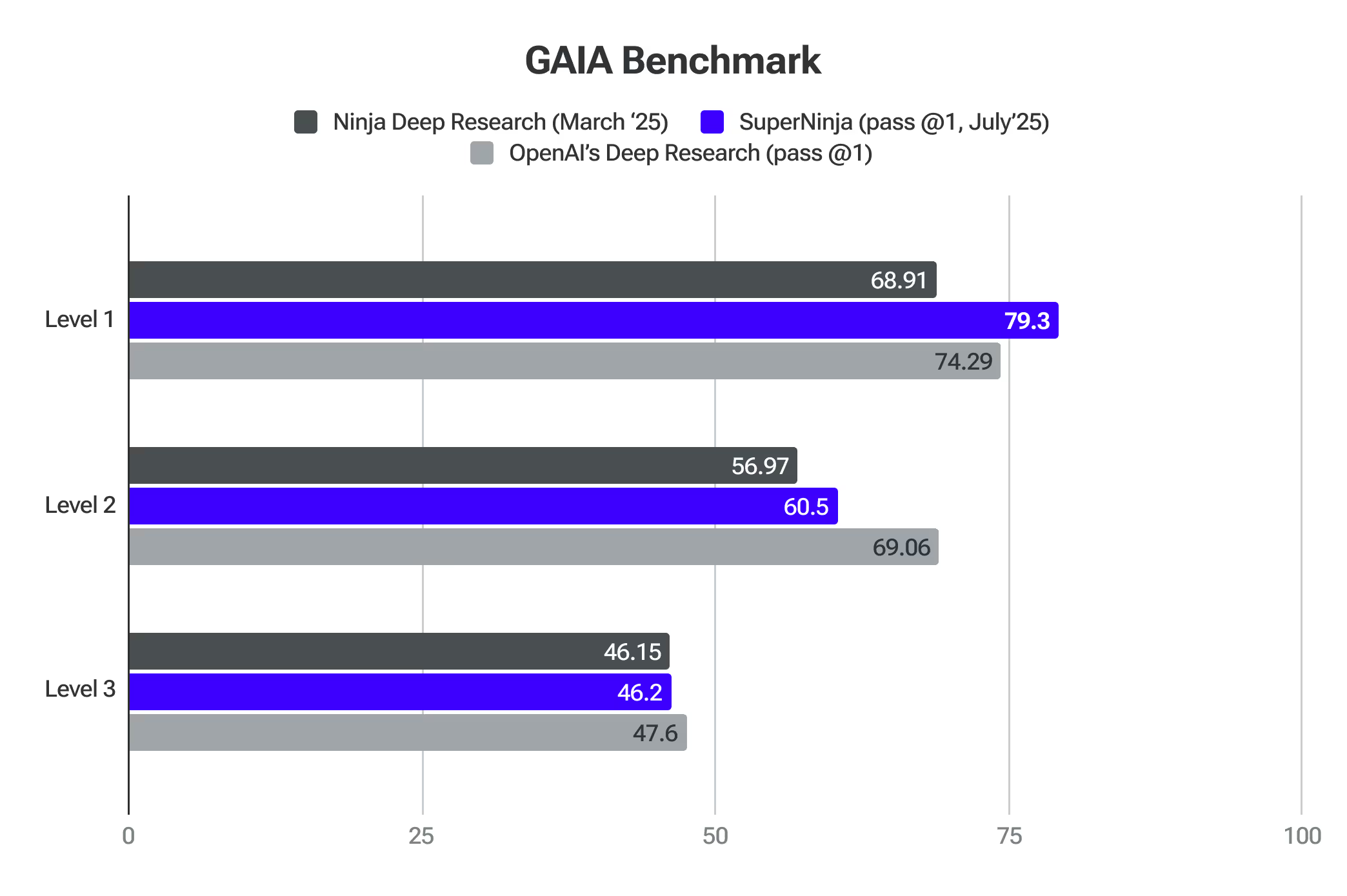

GAIA è un punto di riferimento per la valutazione degli assistenti generali di intelligenza artificiale nella risoluzione di problemi del mondo reale. SuperNinja ha superato i modelli di frontiera al livello 1.

Ricerca approfondita 2.0

Ninja's Deep Research è rigorosamente testato rispetto ai migliori benchmark AI. Queste valutazioni confermano la sua capacità di analizzare argomenti complessi, adattare il suo approccio e fornire ricerche di alta qualità in modo efficiente.

SimpleQA è uno dei migliori proxy per rilevare i livelli di allucinazione del modello. Ninja punteggi 91,2% precisione sul QA semplice benchmark — Ninja's Deep Research ha dimostrato prestazioni eccezionali nell'identificazione accurata delle informazioni fattuali, superando i modelli leader nel settore. Questa performance si basa su test rigorosi che utilizzano una vasta raccolta di diverse migliaia di domande specificamente progettate per valutare la fattualità. Uno dei motivi per cui il nostro sistema sta superando gli altri è dovuto all'enorme quantità di feedback degli utenti che abbiamo ricevuto quando abbiamo lanciato la prima iterazione di Deep Research, che ci ha permesso di mettere a punto e migliorare la qualità che ora viene mostrata dal benchmark SimpleQA.

GAIA (General AI Assistants) è un benchmark innovativo sviluppato dai ricercatori di Meta, HuggingFace, AutoGPT e GenAI che migliora significativamente il modo in cui valutiamo le capacità di ricerca dei sistemi di intelligenza artificiale. A differenza dei benchmark tradizionali che si concentrano su conoscenze specialistiche o su compiti umani sempre più difficili, GAIA verifica le abilità fondamentali essenziali per una ricerca approfondita attraverso una serie di domande accuratamente elaborate che richiedono ragionamento, multimodalità, navigazione web e competenza nell'uso degli strumenti.

Il benchmark è particolarmente importante per misurare l'accuratezza dei sistemi di ricerca approfondita perché valuta in che misura l'intelligenza artificiale può navigare in ambienti informativi del mondo reale, sintetizzare dati da più fonti e produrre risposte concrete e concise, competenze fondamentali per strumenti di ricerca autonomi.

Concentrandosi su domande che richiedono una pianificazione e un'esecuzione autonome di flussi di lavoro di ricerca complessi, piuttosto che competenze specialistiche di dominio, GAIA fornisce un quadro di valutazione completo che si allinea perfettamente con la valutazione dell'accuratezza e dell'affidabilità dei sistemi di ricerca approfondita in applicazioni pratiche e reali. Ninja Deep Research mostra una precisione paragonabile a quella di OpenAI Deep Research, offrendo al contempo attività illimitate per soli 15 dollari al mese.

Fornitore (Pass @1)

Livello 1

Livello 2

Livello 3

Media

La ricerca approfondita di OpenAI

74,29

69,06

47,6

67,36

La ricerca approfondita di Ninjas

69,81

56,97

46,15

57,64

L'ultimo esame dell'umanità rappresenta un progresso significativo nella valutazione dell'IA, fornendo un benchmark completo che misura efficacemente l'accuratezza della ricerca approfondita su più domini. Il benchmark utilizza oltre 3.000 domande che coprono una vasta gamma di oltre 100 argomenti, tra cui matematica, scienze, storia, letteratura e numerose altre aree. Le sue domande rivolte a esperti, progettate per testare conoscenze di frontiera al di là delle semplici capacità di recupero, lo rendono in una posizione unica per valutare quanto bene i sistemi di intelligenza artificiale siano in grado di eseguire ricerche accurate e specializzate ai confini della conoscenza umana.

Deep Research, sviluppato da NinjaTech, ha raggiunto una svolta significativa nell'intelligenza artificiale ottenendo un punteggio di precisione del 17,47% nell'ultimo esame dell'umanità. Queste prestazioni sono notevolmente superiori rispetto a molti altri principali modelli di intelligenza artificiale, tra cui OpenAI o3-mini, o1, DeepSeek-R1 e altri.

Ragionamento 2.0

Reasoning 2.0 ha superato OpenAI O1 e Sonnet 3.7 nella matematica competitiva nel test AIME. Valuta la capacità dell'IA di gestire problemi che richiedono logica e ragionamento avanzato.

Il ragionamento 2.0 ha anche superato l'accuratezza del livello di dottorato umano nel test GPQA. Valuta il ragionamento generale attraverso domande complesse e in più fasi che richiedono il richiamo dei fatti, l'inferenza e la risoluzione dei problemi.

Turbo 1.0 e Apex 1.0

Apex 1.0 ha ottenuto il punteggio più alto nel test standard del settore Arena-Hard-Auto (Chat). Misura la capacità dell'IA di gestire conversazioni complesse nel mondo reale, concentrandosi sulla sua capacità di navigare in scenari che richiedono una comprensione dettagliata e una consapevolezza contestuale.

I modelli eccellono anche in altri benchmark: Math-500, AIME2024 - Reasoning, GPQA - Reasoning, LiveCodeBench - Coding e LiveCodeBench - Coding - Hard.

Descrivi l'attività. Ninja lo trasforma in un'app che funziona passo dopo passo per te. Carta di credito non richiesta.