Referências

Benchmarks abrangentes comparando o desempenho do Ninja aos principais modelos em tarefas de raciocínio, codificação e agentes.

Super Ninja

Referência Gaia

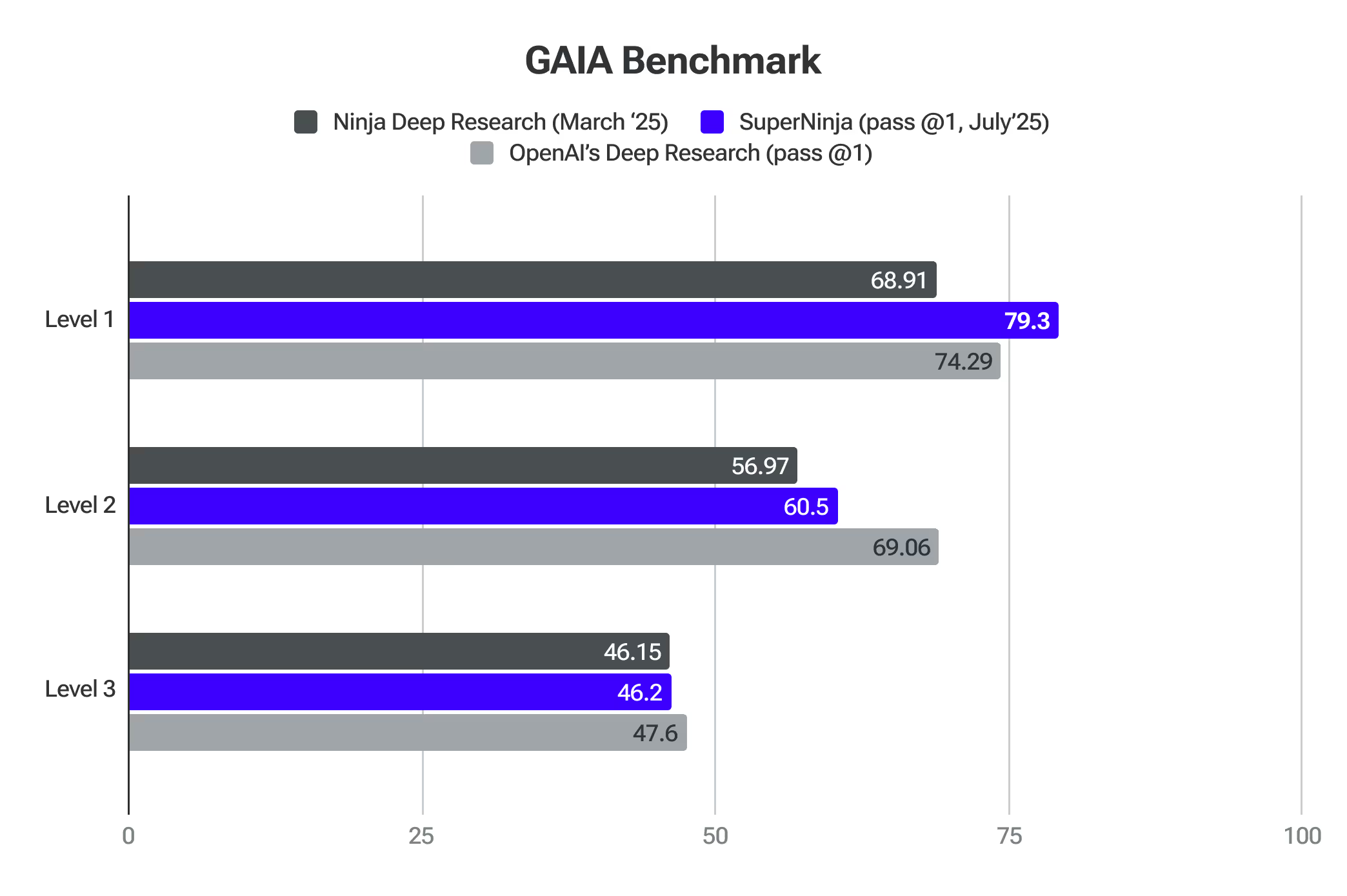

O GAIA é uma referência para avaliar assistentes gerais de IA na solução de problemas do mundo real. O SuperNinja superou os modelos de fronteira no nível 1.

Pesquisa profunda 2.0

O Ninja's Deep Research é rigorosamente testado em relação aos principais benchmarks de IA. Essas avaliações confirmam sua capacidade de analisar tópicos complexos, adaptar sua abordagem e fornecer pesquisas de alta qualidade com eficiência.

O SimpleQA é um dos melhores proxies para detectar os níveis de alucinação do modelo. Ninja pontuações 91.2% precisão no Controle de qualidade simples referência — A Ninja's Deep Research demonstrou um desempenho excepcional na identificação precisa de informações factuais, superando os modelos líderes na área. Esse desempenho é baseado em testes rigorosos usando uma vasta coleção de vários milhares de perguntas projetadas especificamente para avaliar a factualidade. Um dos motivos pelos quais nosso sistema está superando os outros é devido à grande quantidade de feedback dos usuários que recebemos quando lançamos a primeira iteração do Deep Research, que nos permitiu ajustar e melhorar a qualidade que agora é apresentada pelo benchmark SimpleQA.

GAIA (General AI Assistants) é uma referência inovadora desenvolvida por pesquisadores da Meta, HuggingFace, AutoGPT e GenAI que aprimora significativamente a forma como avaliamos as capacidades de pesquisa dos sistemas de IA. Ao contrário dos benchmarks tradicionais que se concentram em conhecimento especializado ou em tarefas humanas cada vez mais difíceis, o GAIA testa habilidades fundamentais essenciais para pesquisas profundas por meio de um conjunto de perguntas cuidadosamente elaboradas que exigem raciocínio, multimodalidade, navegação na web e proficiência no uso de ferramentas.

O benchmark é particularmente relevante para medir a precisão de sistemas de pesquisa profunda porque avalia o quão bem a IA pode navegar em ambientes de informações do mundo real, sintetizar dados de várias fontes e produzir respostas factuais e concisas — habilidades essenciais para ferramentas de pesquisa autônomas.

Ao se concentrar em questões que exigem planejamento e execução autônomos de fluxos de trabalho de pesquisa complexos, em vez de experiência de domínio especializado, o GAIA fornece uma estrutura de avaliação abrangente que se alinha perfeitamente à avaliação da precisão e confiabilidade de sistemas de pesquisa profunda em aplicações práticas do mundo real. A Ninja Deep Research mostra uma precisão comparável à OpenAI Deep Research, ao mesmo tempo em que oferece tarefas ilimitadas por apenas $15/mês.

Provedor (Pass @1)

Nível 1

Nível 2

Nível 3

Média

Pesquisa profunda da OpenAI

74,29

69,06

47,6

67,36

Pesquisa profunda de Ninjas

69,81

56,97

46,15

57,64

O último exame da humanidade representa um avanço significativo na avaliação de IA, fornecendo uma referência abrangente que mede com eficácia a precisão de pesquisas profundas em vários domínios. O benchmark usa mais de 3.000 perguntas abrangendo uma ampla variedade de mais de 100 assuntos, incluindo matemática, ciências, história, literatura e várias outras áreas. Suas perguntas de nível especializado, projetadas para testar o conhecimento de ponta além dos simples recursos de recuperação, o colocam em uma posição única para avaliar o quão bem os sistemas de IA podem realizar pesquisas precisas e especializadas nos limites do conhecimento humano.

A Deep Research, desenvolvida pela NinjaTech, alcançou um avanço significativo em inteligência artificial ao atingir uma pontuação de precisão de 17,47% no Último Exame da Humanidade. Esse desempenho é notavelmente maior do que vários outros modelos líderes de IA, incluindo OpenAI o3-mini, o1, DeepSeek-R1 e outros.

Raciocínio 2.0

O Reasoning 2.0 superou o OpenAI O1 e o Sonnet 3.7 em matemática competitiva no teste AIME. Ele avalia a capacidade da IA de lidar com problemas que exigem lógica e raciocínio avançado.

O Reasoning 2.0 também superou a precisão do nível de doutorado humano no teste GPQA. Ele avalia o raciocínio geral por meio de questões complexas de várias etapas que exigem recordação factual, inferência e resolução de problemas.

Turbo 1.0 e Apex 1.0

O Apex 1.0 obteve a melhor pontuação no teste Arena-Hard-Auto (Chat) padrão do setor. Ele mede o quão bem a IA pode lidar com conversas complexas do mundo real, concentrando-se em sua capacidade de navegar em cenários que exigem compreensão diferenciada e consciência contextual.

Os modelos também se destacam em outros benchmarks: Math-500, AIME2024 - Reasoning, GPQA - Reasoning, LiveCodeBench - Coding e LiveCodeBench - Coding - Hard.

Comece com SuperNinja

Onde a IA geral encontra a produtividade do mundo real.