Puntos de referencia

Comparativas exhaustivas que comparan el rendimiento de Ninja con los modelos líderes en tareas de razonamiento, codificación y agentes.

Súper Ninja

Punto de referencia de Gaia

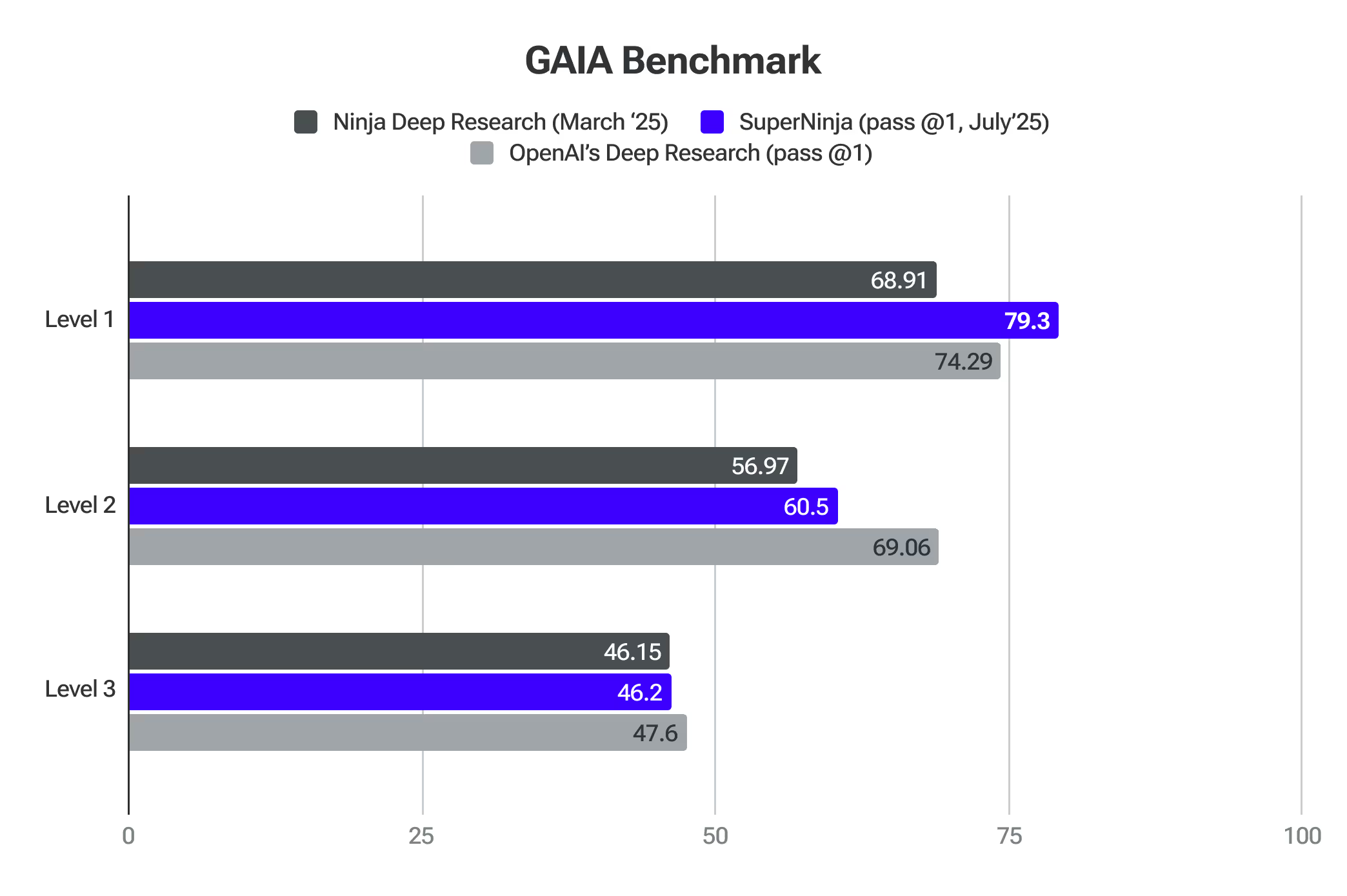

GAIA es un punto de referencia para evaluar a los asistentes generales de IA en la resolución de problemas del mundo real. SuperNinja ha superado a los modelos más avanzados en el nivel 1.

Investigación profunda 2.0

Ninja's Deep Research se prueba rigurosamente con los mejores puntos de referencia de IA. Estas evaluaciones confirman su capacidad para analizar temas complejos, adaptar su enfoque y ofrecer investigaciones de alta calidad de manera eficiente.

SimpleQA es uno de los mejores proxies para detectar los niveles de alucinación del modelo. Ninja puntuaciones 91.2% precisión en el Control de calidad simple punto de referencia: Ninja's Deep Research ha demostrado un rendimiento excepcional a la hora de identificar con precisión la información fáctica, superando a los modelos líderes en el campo. Este rendimiento se basa en rigurosas pruebas que utilizan una amplia colección de varios miles de preguntas diseñadas específicamente para evaluar la veracidad de los hechos. Una de las razones por las que nuestro sistema está superando a los demás se debe a la enorme cantidad de comentarios de los usuarios que recibimos cuando lanzamos la primera versión de Deep Research, lo que nos permitió ajustar y mejorar la calidad que ahora ofrece SimpleQA Benchmark.

GAIA (General AI Assistants) es un punto de referencia innovador desarrollado por investigadores de Meta, HuggingFace, AutoGPT y GenAI que mejora significativamente la forma en que evaluamos las capacidades de investigación de los sistemas de IA. A diferencia de los puntos de referencia tradicionales, que se centran en conocimientos especializados o en tareas humanas cada vez más difíciles, GAIA pone a prueba las habilidades fundamentales esenciales para una investigación profunda mediante una serie de preguntas cuidadosamente elaboradas que requieren razonamiento, multimodalidad, navegación web y dominio del uso de herramientas.

El punto de referencia es particularmente relevante para medir la precisión de los sistemas de investigación profunda porque evalúa qué tan bien la IA puede navegar en entornos de información del mundo real, sintetizar datos de múltiples fuentes y producir respuestas objetivas y concisas, habilidades fundamentales para las herramientas de investigación autónomas.

Al centrarse en cuestiones que requieren una planificación y ejecución autónomas de flujos de trabajo de investigación complejos, en lugar de experiencia en un dominio especializado, GAIA proporciona un marco de evaluación integral que se alinea perfectamente con la evaluación de la precisión y confiabilidad de los sistemas de investigación profunda en aplicaciones prácticas del mundo real. Ninja Deep Research muestra una precisión comparable a la de OpenAI Deep Research, al tiempo que ofrece tareas ilimitadas por solo 15 dólares al mes.

Proveedor (Pass @1)

Nivel 1

Nivel 2

Nivel 3

Promedio

La investigación profunda de OpenAI

74,29

69,06

47,6

67,36

La profunda investigación de los ninjas

69,81

56,97

46,15

57,64

El último examen de la humanidad representa un avance significativo en la evaluación de la IA, ya que proporciona un punto de referencia integral que mide de manera efectiva la precisión de la investigación profunda en múltiples dominios. El punto de referencia utiliza más de 3000 preguntas que abarcan una amplia gama de más de 100 materias, incluidas las matemáticas, la ciencia, la historia, la literatura y muchas otras áreas. Sus preguntas de nivel experto, diseñadas para poner a prueba los conocimientos avanzados más allá de las simples capacidades de recuperación, lo sitúan en una posición única para evaluar la capacidad de los sistemas de inteligencia artificial para realizar investigaciones precisas y especializadas dentro de los límites del conocimiento humano.

Deep Research, desarrollado por NinjaTech, ha conseguido un avance significativo en la inteligencia artificial al obtener una puntuación de precisión del 17,47% en el último examen de la humanidad. Este rendimiento es notablemente superior al de otros modelos de IA líderes, incluidos OpenAI o3-mini, o1, DeepSeek-R1 y otros.

Razonamiento 2.0

Reasoning 2.0 superó a OpenAI O1 y Sonnet 3.7 en matemáticas competitivas en la prueba AIME. Evalúa la capacidad de la IA para manejar problemas que requieren lógica y razonamiento avanzado.

Reasoning 2.0 también superó la precisión del nivel de doctorado humano en la prueba GPQA. Evalúa el razonamiento general a través de preguntas complejas de varios pasos que requieren recordar los hechos, inferir y resolver problemas.

Turbo 1.0 y Apex 1.0

Apex 1.0 obtuvo la puntuación más alta en la prueba Arena-Hard-Auto (Chat) estándar del sector. Mide la capacidad de la IA para gestionar conversaciones complejas del mundo real y se centra en su capacidad para sortear situaciones que requieren una comprensión matizada y un conocimiento del contexto.

Los modelos también destacan en otros puntos de referencia: Math-500, AIME2024 - Reasoning, GPQA - Reasoning, LiveCodeBench - Coding y LiveCodeBench - Coding - Hard.

Empieza con SuperNinja

Donde la IA general se une a la productividad en el mundo real.