Ninja忍者人工智能基准测试AI Benchmarks

了解 Ninja 的模型如何在推理、编码和代理任务中与 GPT、Claude、Gemini 和其他领先的 AI 模型正面交锋,并获得透明、可重复的结果。

超级忍者

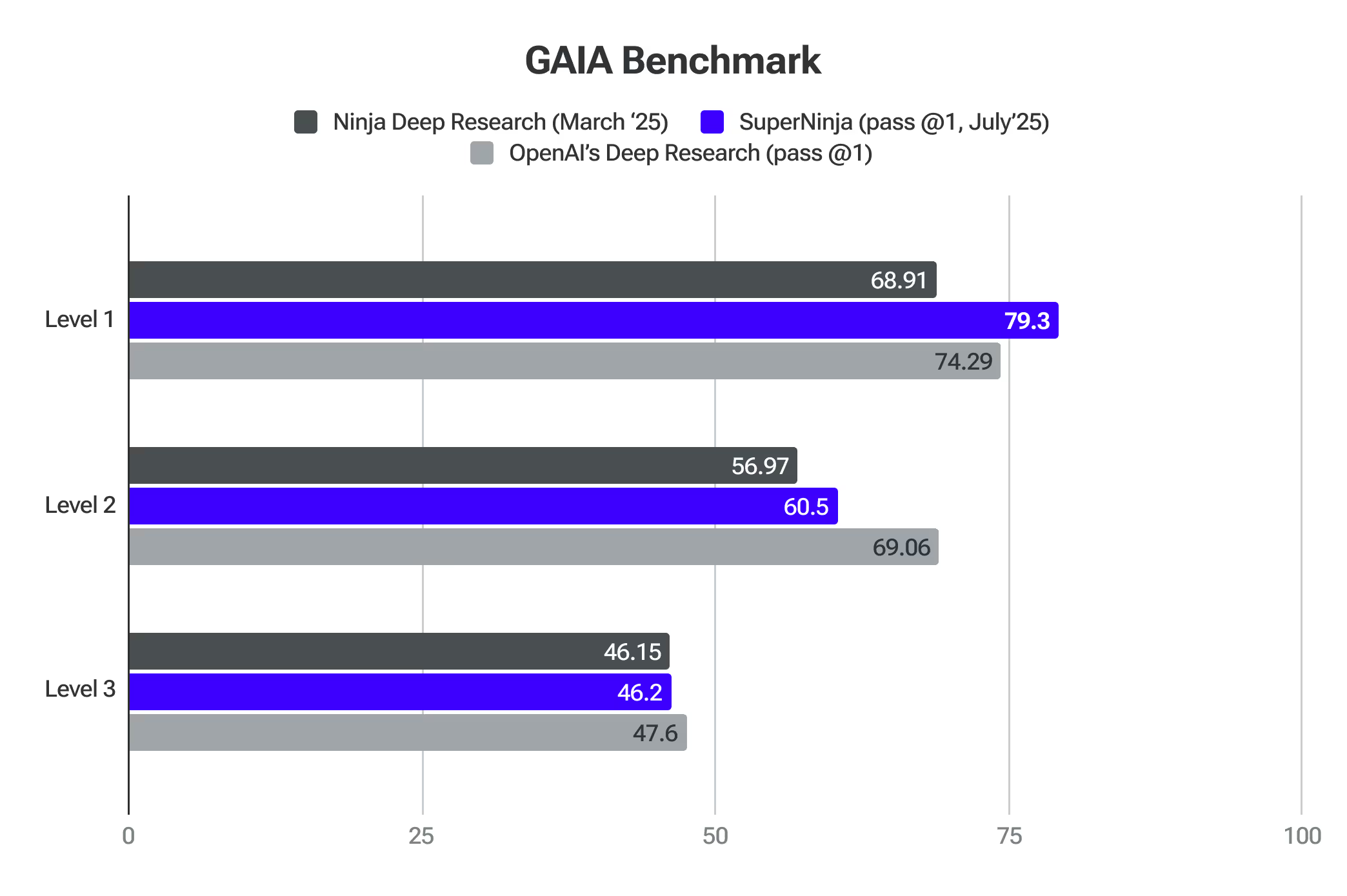

盖亚基准

GAIA是评估通用人工智能助手解决现实问题的基准。超级忍者在第 1 级已经超越了前沿模型。

深度研究 2.0

Ninja's Deep Research 根据顶级 AI 基准测试进行了严格测试。这些评估证实了其分析复杂主题、调整方法和高效提供高质量研究的能力。

SimpleQA 是检测模型幻觉水平的最佳代理之一。忍者 得分 91.2% 精度在 SimpleQA 基准 — Ninja's Deep Research在准确识别事实信息方面表现出卓越的性能,超过了该领域的领先模型。这种表现基于严格的测试,使用了专门为评估事实性而设计的数千个问题。我们的系统表现优于其他系统的原因之一是我们在启动 Deep Research 的第一次迭代时收到了大量的用户反馈,这使我们能够微调和提高 SimpleQA 基准测试所展示的质量。

盖亚 (通用人工智能助手)是由来自Meta、HuggingFace、AutoGPT和GenAI的研究人员开发的开创性基准,它极大地推动了我们评估人工智能系统研究能力的方式。与侧重于专业知识或日益困难的人类任务的传统基准测试不同,GAIA通过一系列精心设计的问题来测试深入研究所必需的基本能力,这些问题需要推理、多模式、网页浏览和工具使用熟练程度。

该基准测试与衡量深度研究系统的准确性特别相关,因为它评估了人工智能在现实世界信息环境中导航、合成来自多个来源的数据以及得出真实、简洁的答案——自主研究工具的核心技能。

通过专注于需要自主规划和执行复杂研究工作流程的问题,而不是专业领域的专业知识,GAIA提供了一个全面的评估框架,该框架与评估深度研究系统在实际现实应用中的准确性和可靠性完美契合。Ninja Deep Research的准确性与OpenAI Deep Research相当,同时每月仅提供15美元的无限任务。

提供商(Pass @1)

第 1 级

第 2 级

第 3 级

平均值

OpenAI 的深度研究

74.29

69.06

47.6

67.36

忍者的深度研究

69.81

56.97

46.15

57.64

人类的最后一次考试 代表了人工智能评估的重大进步,它提供了一个全面的基准,可以有效衡量跨领域深入研究的准确性。该基准测试使用了3,000多个问题,涵盖100多个学科,包括数学、科学、历史、文学和许多其他领域。它是专家级别的问题,旨在测试除简单检索能力之外的前沿知识,使其具有独特的优势,可以评估人工智能系统在人类知识边界上进行准确、专业研究的情况。

由 NinjaTech 开发的 Deep Research 已经取得了成就 在 Humanity's Last Exam 中获得了 17.47% 的准确性分数,这是人工智能领域的重大突破。这种性能明显高于其他几种领先的人工智能模型,包括OpenAI o3-mini、o1、DeepSeek-R1等。

推理 2.0

在AIME测试的竞争数学中,Reasoning 2.0的表现优于OpenAI O1和Sonnet 3.7。它评估了人工智能处理需要逻辑和高级推理的问题的能力。

在GPQA测试中,推理2.0的准确度也超过了人类博士级别的准确性。它通过复杂的多步骤问题来评估一般推理,这些问题需要回忆事实、推断和解决问题。

Turbo 1.0 和 Apex 1.0

Apex 1.0在行业标准的Arena-Hard-Auto(聊天)测试中得分最高。它衡量了人工智能处理复杂现实对话的能力,重点是其驾驭需要细致理解和情境感知的场景的能力。

这些模型在其他基准测试中也表现出色:Math-500、AIME2024-推理、GPQA-推理、LiveCodeBench-编码,以及LiveCodeBench-编程-困难。

描述任务。Ninja 将其变成一款可为您逐步运行的应用程序。无需信用卡。