Benchmarks

Umfassende Benchmarks, in denen die Leistung von Ninja in Bezug auf Argumentation, Codierung und Agentenaufgaben mit führenden Modellen verglichen wird.

Super-Ninja

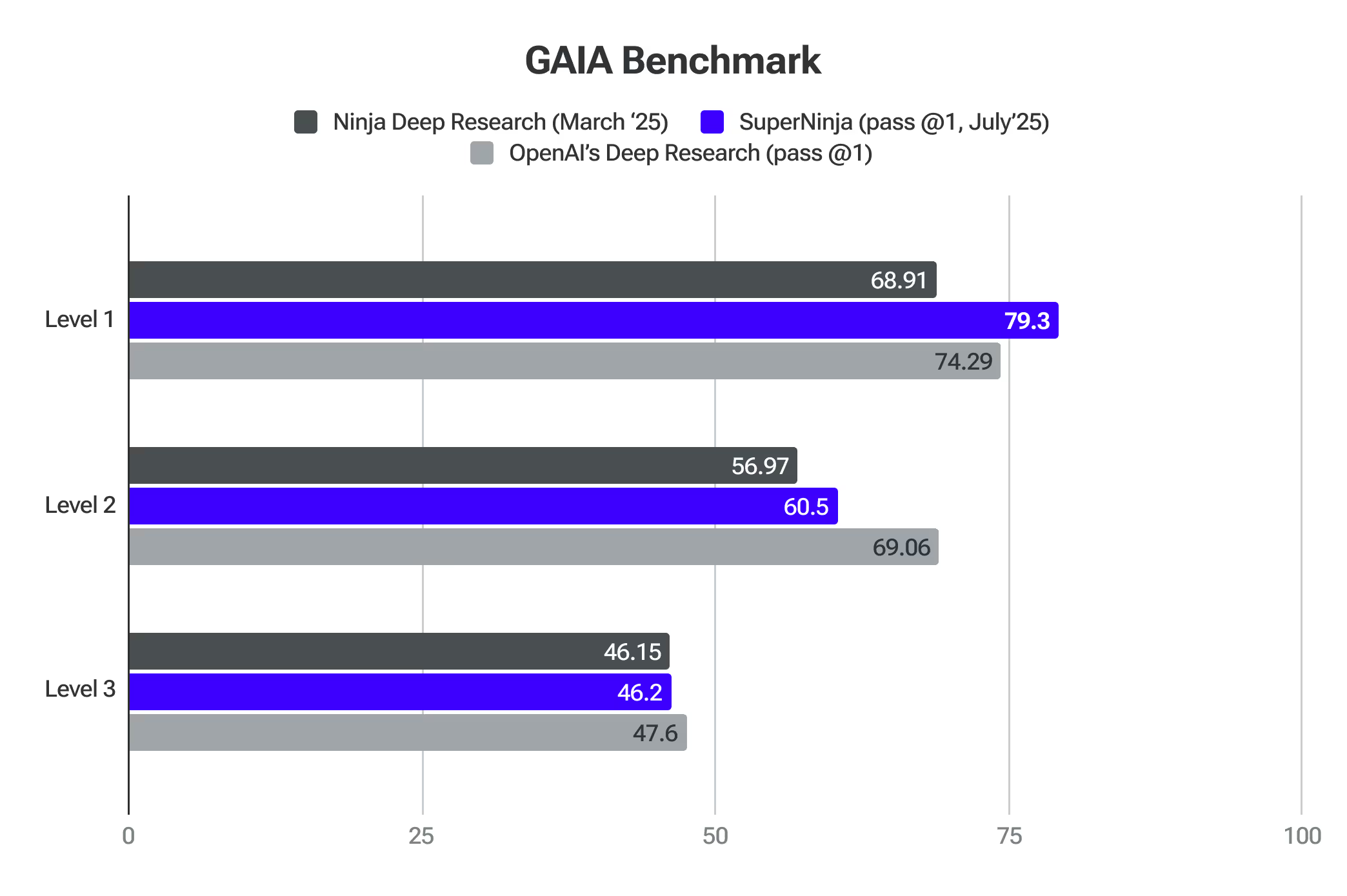

Gaia-Benchmark

GAIA ist ein Benchmark für die Bewertung allgemeiner KI-Assistenten bei der Lösung realer Probleme. SuperNinja hat Grenzmodelle auf Level 1 übertroffen.

Tiefgründige Recherche 2.0

Ninja's Deep Research wird rigoros anhand der besten KI-Benchmarks getestet. Diese Bewertungen bestätigen die Fähigkeit des Unternehmens, komplexe Themen zu analysieren, seinen Ansatz anzupassen und qualitativ hochwertige Forschungsarbeiten effizient durchzuführen.

SimpleQA ist einer der besten Proxys zur Erkennung der Halluzinationswerte des Modells. Ninja Punkte 91.2% Genauigkeit auf der Einfache Qualitätssicherung Benchmark — Ninja's Deep Research hat eine außergewöhnliche Leistung bei der genauen Identifizierung von Fakteninformationen bewiesen und damit führende Modelle auf diesem Gebiet übertroffen. Diese Leistung basiert auf strengen Tests, bei denen eine umfangreiche Sammlung von mehreren tausend Fragen verwendet wurde, die speziell zur Bewertung von Fakten entwickelt wurden. Einer der Gründe, warum unser System besser abschneidet als andere, liegt in der riesigen Menge an Benutzerfeedback, das wir bei der Einführung der ersten Iteration von Deep Research erhalten haben. Dadurch konnten wir die Qualität, die jetzt im SimpleQA-Benchmark zum Ausdruck kommt, verfeinern und verbessern.

GAIA (General AI Assistants) ist ein bahnbrechender Benchmark, der von Forschern von Meta, HuggingFace, AutoGPT und GenAI entwickelt wurde und die Art und Weise, wie wir die Forschungskapazitäten von KI-Systemen bewerten, erheblich verbessert. Im Gegensatz zu herkömmlichen Benchmarks, die sich auf Fachwissen oder zunehmend schwierige menschliche Aufgaben konzentrieren, testet GAIA grundlegende Fähigkeiten, die für eine gründliche Recherche unerlässlich sind, anhand einer Reihe sorgfältig ausgearbeiteter Fragen, die logisches Denken, Multimodalität, Surfen im Internet und Beherrschung der Werkzeuge erfordern.

Der Benchmark ist besonders relevant für die Messung der Genauigkeit von Tiefenforschungssystemen, da er bewertet, wie gut KI in realen Informationsumgebungen navigieren, Daten aus mehreren Quellen synthetisieren und sachliche, präzise Antworten liefern kann — Kernkompetenzen für autonome Recherchetools.

GAIA konzentriert sich auf Fragen, die eine autonome Planung und Durchführung komplexer Forschungsabläufe erfordern — und nicht auf spezielle Fachkenntnisse — und bietet einen umfassenden Bewertungsrahmen, der perfekt auf die Bewertung der Genauigkeit und Zuverlässigkeit von Tiefenforschungssystemen in praktischen, realen Anwendungen abgestimmt ist. Ninja Deep Research weist eine vergleichbare Genauigkeit wie OpenAI Deep Research auf und bietet gleichzeitig eine unbegrenzte Anzahl von Aufgaben für nur 15 $/Monat.

Anbieter (Pass @1)

Stufe 1

Stufe 2

Stufe 3

Durchschnittlich

Die gründliche Recherche von OpenAI

74,29

69,06

47,6

67,36

Die tiefgründige Recherche der Ninjas

69,81

56,97

46,15

57,64

Die letzte Prüfung der Menschheit stellt einen bedeutenden Fortschritt in der KI-Bewertung dar und bietet einen umfassenden Benchmark, der die Genauigkeit eingehender Untersuchungen in mehreren Bereichen effektiv misst. Der Benchmark verwendet über 3.000 Fragen aus einem breiten Spektrum von mehr als 100 Fächern, darunter Mathematik, Naturwissenschaften, Geschichte, Literatur und zahlreiche andere Bereiche. Es handelt sich um Fragen auf Expertenebene, die darauf ausgelegt sind, Grundlagenwissen zu testen, das über einfache Abrufmöglichkeiten hinausgeht. Dadurch ist es einzigartig positioniert, um zu beurteilen, wie gut KI-Systeme präzise, spezialisierte Forschungen an den Grenzen des menschlichen Wissens durchführen können.

Deep Research, entwickelt von NinjaTech, hat ein bedeutender Durchbruch in der künstlichen Intelligenz, da bei Humanity's Last Exam eine Genauigkeit von 17,47% erreicht wurde. Diese Leistung ist deutlich höher als bei mehreren anderen führenden KI-Modellen, darunter OpenAI o3-mini, o1, DeepSeek-R1 und andere.

Argumentation 2.0

Reasoning 2.0 übertraf OpenAI O1 und Sonnet 3.7 in kompetitiver Mathematik im AIME-Test. Es bewertet die Fähigkeit der KI, Probleme zu lösen, die Logik und fortgeschrittenes Denken erfordern.

Reasoning 2.0 übertraf auch die Genauigkeit des menschlichen Doktorats beim GPQA-Test. Es bewertet das allgemeine Denken anhand komplexer, mehrstufiger Fragen, die die Erinnerung an Fakten, Schlussfolgerungen und Problemlösung erfordern.

Turbo 1.0 und Apex 1.0

Apex 1.0 erzielte beim branchenüblichen Arena-Hard-Auto (Chat) -Test die höchste Punktzahl. Es misst, wie gut KI komplexe, reale Konversationen bewältigen kann, und konzentriert sich dabei auf ihre Fähigkeit, sich in Szenarien zurechtzufinden, die ein differenziertes Verständnis und eine kontextuelle Wahrnehmung erfordern.

Die Modelle zeichnen sich auch in anderen Benchmarks aus: Math-500, AIME2024 — Reasoning, GPQA — Reasoning, LiveCodeBench — Coding und LiveCodeBench — Coding — Hard.

Erste Schritte mit SuperNinja

Wo allgemeine KI auf reale Produktivität trifft.