ベンチマーク

推論、コーディング、エージェントタスクにわたって、Ninjaのパフォーマンスを主要モデルと比較した包括的なベンチマークです。

スーパーニンジャ

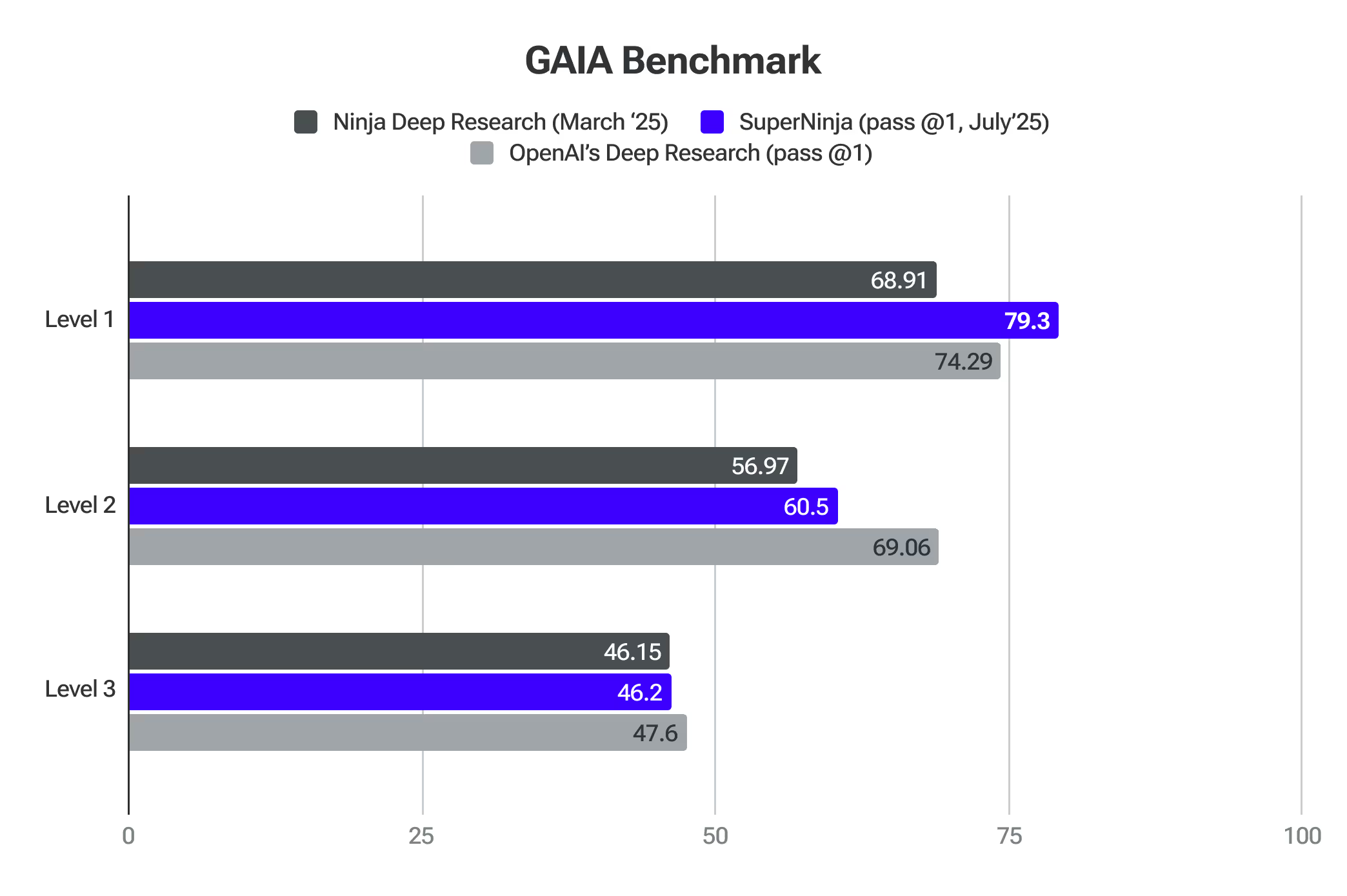

ガイアベンチマーク

GAIAは、現実世界の問題を解決するジェネラルAIアシスタントを評価するためのベンチマークです。SuperNinjaはレベル1でフロンティアモデルを上回りました。

ディープリサーチ 2.0

Ninja's Deep Researchは、トップクラスのAIベンチマークに対して厳密にテストされています。これらの評価により、複雑なトピックを分析し、アプローチを適応させ、質の高い研究を効率的に提供する能力が確認されました。

SimpleQAは、モデルの幻覚レベルを検出するのに最適なプロキシの1つです。忍者 スコア 91.2% の精度 シンプルな QA ベンチマーク — Ninja's Deep Researchは、事実情報を正確に識別する点で優れたパフォーマンスを示しており、この分野の主要モデルを上回っています。このパフォーマンスは、事実性を評価するために特別に設計された数千の質問からなる膨大なコレクションを用いた厳格なテストに基づいています。私たちのシステムが他のシステムよりも優れている理由の1つは、Deep Researchの最初のイテレーションを開始したときに受け取った膨大な量のユーザーフィードバックによるものです。これにより、現在SimpleQAベンチマークで示されている品質の微調整と改善が可能になりました。

ガイア (ジェネラルAIアシスタント)は、Meta、HuggingFace、AutoGPT、GenAIの研究者が開発した画期的なベンチマークであり、AIシステムの研究能力の評価方法を大幅に向上させます。専門知識やますます難しくなる人的タスクに焦点を当てた従来のベンチマークとは異なり、GAIAは、推論、マルチモダリティ、ウェブブラウジング、ツールの使用能力を必要とする入念に作られた一連の質問を通じて、深い研究に不可欠な基本的な能力をテストします。

このベンチマークは、AIが現実世界の情報環境をどれだけうまくナビゲートし、複数のソースからのデータを合成し、事実に基づいた簡潔な回答を生み出すことができるかを評価するため、ディープリサーチシステムの精度を測定するのに特に適しています。これは、自律型リサーチツールのコアスキルです。

Gaiaは、専門分野の専門知識ではなく、複雑な研究ワークフローの自律的な計画と実行を必要とする問題に焦点を当てることにより、実践的で現実的なアプリケーションにおけるディープリサーチシステムの正確性と信頼性の評価と完全に一致する包括的な評価フレームワークを提供します。Ninja Deep ResearchはOpenAI Deep Researchと同等の精度を示している一方で、月々わずか15ドルで無制限のタスクを提供しています。

プロバイダー (パス @1)

レベル 1

レベル 2

レベル 3

アベレージ

オープンAIのディープ・リサーチ

74.29

69.06

47.6

67.36

ニンジャズ・ディープリサーチ

69.81

56.97

46.15

57.64

人類最後の試験 これはAI評価の大幅な進歩を表しており、複数の分野にわたるディープリサーチの精度を効果的に測定する包括的なベンチマークとなっています。このベンチマークでは、数学、科学、歴史、文学、その他多数の分野を含む、100を超えるさまざまな科目にまたがる3,000以上の質問が使用されています。これは専門家レベルの質問であり、単なる検索機能を超えた最先端の知識をテストするように設計されており、AIシステムが人間の知識の境界で正確で専門的な研究をどれだけうまく実行できるかを評価するうえで他に類を見ない立場にあります。

NinjaTechが開発したディープリサーチが達成しました 人類の最終試験で 17.47% の精度スコアを獲得したことによる人工知能の飛躍的進歩。このパフォーマンスは、OpenAI o3-mini、o1、DeepSeek-R1など、他のいくつかの主要なAIモデルよりも著しく高くなっています。

推論2.0

AIMEテストの競争数学では、推論2.0がOpenAI O1とSonnet 3.7を上回りました。論理と高度な推論を必要とする問題を処理する AI の能力を評価します。

推論2.0は、GPQAテストでも人間の博士レベルの正確さを上回りました。事実の想起、推論、問題解決を必要とする複雑な多段階の質問を通して、一般的な推論を評価します。

ターボ 1.0 & アペックス 1.0

Apex 1.0は、業界標準のアリーナハードオート(チャット)テストで最も高いスコアを記録しました。このテストでは、複雑な現実世界の会話をAIがどの程度うまく処理できるかを測定し、微妙な理解と文脈認識を必要とするシナリオをナビゲートする能力に焦点を当てています。

これらのモデルは他のベンチマークでも優れています:Math-500、AIME2024-推論、GPQA-推論、LiveCodeBench-コーディング、LiveCodeBench-コーディング-ハード。

スーパーニンジャを始めよう

一般的な AI と現実世界の生産性が出会う場所