Points de repère

Des benchmarks complets comparant les performances de Ninja à celles des principaux modèles en matière de raisonnement, de codage et de tâches d'agent.

Super Ninja

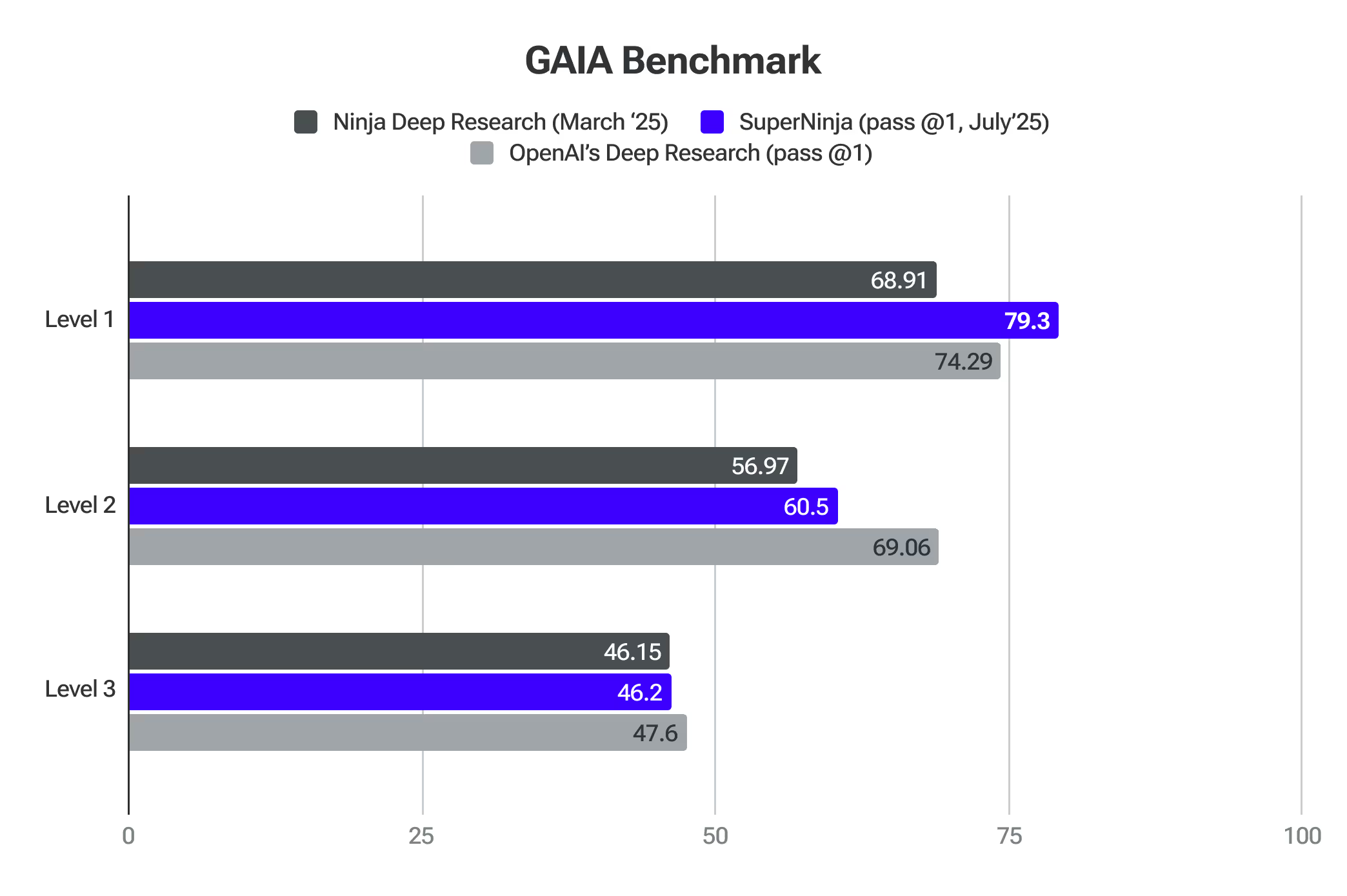

Indice de référence Gaia

GAIA est une référence pour évaluer les assistants généraux d'IA dans la résolution de problèmes du monde réel. SuperNinja a dépassé les modèles frontières au niveau 1.

Deep Research 2.0

Ninja's Deep Research est rigoureusement testé par rapport aux meilleurs critères d'IA. Ces évaluations confirment sa capacité à analyser des sujets complexes, à adapter son approche et à fournir des recherches de haute qualité de manière efficace.

SimpleQA est l'un des meilleurs proxys pour détecter les niveaux d'hallucination du modèle. Ninja résultats : 91,2 % précision sur QA simple référence — Ninja's Deep Research a démontré des performances exceptionnelles en matière d'identification précise des informations factuelles, surpassant ainsi les principaux modèles dans le domaine. Cette performance est basée sur des tests rigoureux utilisant une vaste collection de plusieurs milliers de questions spécialement conçues pour évaluer la factualité. L'une des raisons pour lesquelles notre système surpasse les autres est dû aux nombreux commentaires des utilisateurs que nous avons reçus lors du lancement de la première itération de Deep Research, ce qui nous a permis d'affiner et d'améliorer la qualité qui est désormais démontrée par le benchmark SimpleQA.

GAIA (General AI Assistants) est une référence révolutionnaire développée par des chercheurs de Meta, HuggingFace, AutoGPT et GenAI qui améliore considérablement la façon dont nous évaluons les capacités de recherche des systèmes d'IA. Contrairement aux critères de référence traditionnels qui se concentrent sur des connaissances spécialisées ou des tâches humaines de plus en plus difficiles, GAIA teste les capacités fondamentales essentielles à une recherche approfondie grâce à un ensemble de questions soigneusement conçues nécessitant raisonnement, multimodalité, navigation sur le Web et maîtrise de l'utilisation des outils.

L'indice de référence est particulièrement pertinent pour mesurer la précision des systèmes de recherche approfondis, car il évalue dans quelle mesure l'IA peut naviguer dans des environnements d'information réels, synthétiser des données provenant de sources multiples et produire des réponses factuelles et concises, des compétences essentielles pour les outils de recherche autonomes.

En se concentrant sur les questions qui nécessitent une planification et une exécution autonomes de flux de recherche complexes, plutôt que sur une expertise spécialisée, GAIA fournit un cadre d'évaluation complet qui correspond parfaitement à l'évaluation de la précision et de la fiabilité de systèmes de recherche approfondis dans des applications pratiques et réelles. Ninja Deep Research affiche une précision comparable à celle d'OpenAI Deep Research, tout en proposant un nombre illimité de tâches pour seulement 15$ par mois.

Fournisseur (Pass @1)

Niveau 1

Niveau 2

Niveau 3

Moyenne

Les recherches approfondies d'OpenAI

74,29

69,06

47,6

67,36

Les recherches approfondies des ninjas

69,81

56,97

46,15

57,64

Le dernier examen de l'humanité représente une avancée significative dans l'évaluation de l'IA, fournissant une référence complète qui mesure efficacement la précision de recherches approfondies dans de nombreux domaines. Le benchmark utilise plus de 3 000 questions couvrant un large éventail de plus de 100 sujets, notamment les mathématiques, les sciences, l'histoire, la littérature et de nombreux autres domaines. Ses questions adressées à des experts, conçues pour tester les connaissances de pointe au-delà de simples capacités de récupération, le placent dans une position unique pour évaluer dans quelle mesure les systèmes d'IA peuvent effectuer des recherches précises et spécialisées aux limites du savoir humain.

Deep Research, développé par NinjaTech, a atteint une avancée significative dans le domaine de l'intelligence artificielle en obtenant un score de précision de 17,47 % au dernier examen de l'humanité. Ces performances sont nettement supérieures à celles de plusieurs autres modèles d'IA de premier plan, notamment OpenAI o3-mini, o1, DeepSeek-R1 et d'autres.

Raisonnement 2.0

Reasoning 2.0 a surpassé OpenAI O1 et Sonnet 3.7 en mathématiques compétitives au test AIME. Il évalue la capacité de l'IA à gérer des problèmes nécessitant une logique et un raisonnement avancé.

Reasoning 2.0 a également dépassé le niveau de précision du doctorat humain lors du test GPQA. Il évalue le raisonnement général à l'aide de questions complexes en plusieurs étapes nécessitant un rappel factuel, une inférence et la résolution de problèmes.

Turbo 1.0 et Apex 1.0

Apex 1.0 a obtenu la meilleure note au test Arena-Hard-Auto (Chat), une norme du secteur. Il mesure la capacité de l'IA à gérer des conversations complexes et réelles, en se concentrant sur sa capacité à gérer des scénarios nécessitant une compréhension nuancée et une prise en compte du contexte.

Les modèles excellent également dans d'autres benchmarks : Math-500, AIME2024 - Reasoning, GPQA - Reasoning, LiveCodeBench - Coding et LiveCodeBench - Coding - Hard.

Commencez avec SuperNinja

Où l'IA générale rencontre la productivité dans le monde réel.