벤치마크

추론, 코딩, 에이전트 작업 전반에서 Ninja의 성능을 주요 모델과 비교하는 포괄적인 벤치마크입니다.

슈퍼 닌자

가이아 벤치마크

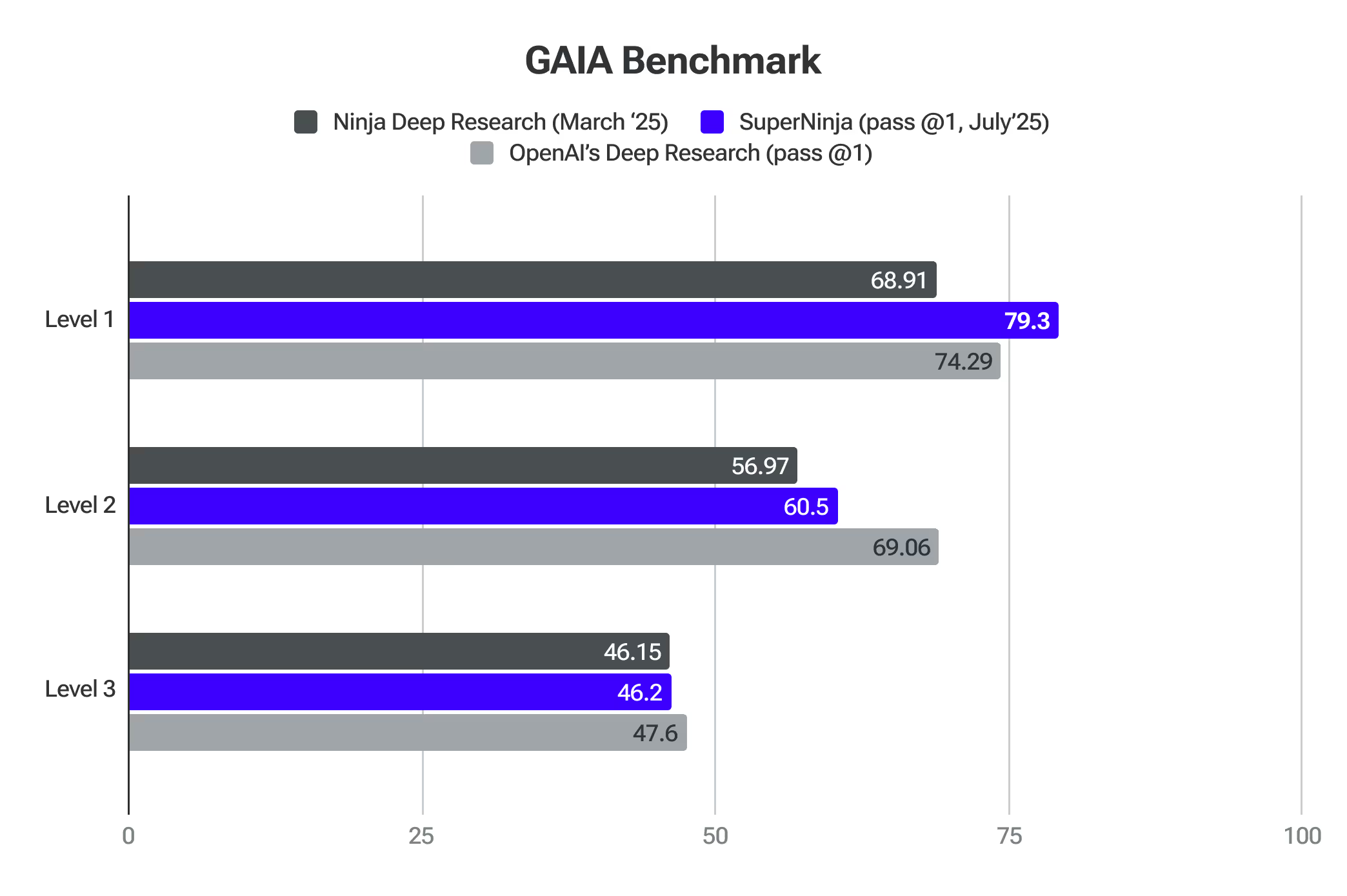

GAIA는 실제 문제 해결에 대한 일반 AI 어시스턴트를 평가하기 위한 벤치마크입니다.슈퍼닌자는 레벨 1에서 프론티어 모델을 능가했습니다.

딥 리서치 2.0

닌자의 딥 리서치는 상위 AI 벤치마크를 기준으로 엄격한 테스트를 거쳤습니다.이러한 평가를 통해 복잡한 주제를 분석하고 접근 방식을 조정하며 고품질 연구를 효율적으로 제공할 수 있는 능력이 입증되었습니다.

SimpleQA는 모델의 환각 수준을 감지하는 데 가장 적합한 프록시 중 하나입니다.닌자 점수 91.2% 에 대한 정확도 간단한 QA 벤치마크 — Ninja의 Deep Research는 사실 정보를 정확하게 식별하는 데 있어 해당 분야의 주요 모델을 능가하는 탁월한 성능을 보여주었습니다.이 성과는 사실성을 평가하기 위해 특별히 고안된 수천 개의 질문 모음을 사용한 엄격한 테스트를 기반으로 합니다.우리 시스템이 다른 시스템보다 성능이 뛰어난 이유 중 하나는 Deep Research의 첫 번째 버전을 출시했을 때 받은 방대한 양의 사용자 피드백 덕분입니다. 이를 통해 현재 SimpleQA 벤치마크에서 보여주는 품질을 미세 조정하고 개선할 수 있었습니다.

가이아 (일반 AI 어시스턴트) 는 메타, 허깅페이스, AutoGPT 및 GenAI의 연구원들이 개발한 획기적인 벤치마크로, AI 시스템의 연구 능력을 평가하는 방법을 크게 발전시켰습니다.전문 지식이나 점점 더 어려워지는 인간의 과제에 초점을 맞추는 기존의 벤치마크와 달리 GAIA는 추론, 다중 양식, 웹 브라우징 및 도구 사용 숙련도를 요구하는 세심하게 만들어진 일련의 질문을 통해 심층 연구에 필수적인 기본 능력을 테스트합니다.

이 벤치마크는 AI가 실제 정보 환경을 얼마나 잘 탐색하고, 여러 소스의 데이터를 합성하고, 자율 연구 도구의 핵심 기술인 사실적이고 간결한 답변을 산출할 수 있는지를 평가하기 때문에 심층 연구 시스템의 정확도를 측정하는 데 특히 적합합니다.

GAIA는 전문 분야 전문 지식이 아닌 복잡한 연구 워크플로의 자율적 계획 및 실행이 필요한 질문에 초점을 맞추어 실제 응용 분야에서 심층 연구 시스템의 정확성과 신뢰성을 평가하는 데 완벽하게 부합하는 포괄적인 평가 프레임워크를 제공합니다.닌자 딥 리서치는 OpenAI 딥 리서치에 필적하는 정확도를 보여주면서도 월 15달러에 무제한 작업을 제공합니다.

프로바이더 (패스 @1)

레벨 1

레벨 2

레벨 3

평균

오픈AI의 딥 리서치

74.29

69.06

47.6

67.36

닌자의 딥 리서치

69.81

56.97

46.15

57.64

인류의 마지막 시험 여러 영역에 걸친 심층 연구의 정확도를 효과적으로 측정하는 포괄적인 벤치마크를 제공하는 AI 평가의 상당한 발전을 나타냅니다.이 벤치마크에서는 수학, 과학, 역사, 문학 및 기타 여러 분야를 포함하여 100개 이상의 다양한 주제에 걸쳐 3,000개 이상의 질문을 사용합니다.단순한 검색 기능을 넘어 최전방 지식을 테스트하도록 설계된 전문가 수준의 질문으로, AI 시스템이 인간 지식의 한계에서 정확하고 전문적인 연구를 얼마나 잘 수행할 수 있는지 평가할 수 있는 독보적인 입지를 제공합니다.

닌자테크가 개발한 딥 리서치는 다음과 같은 성과를 거두었습니다. 휴머니티 라스트 시험에서 17.47% 의 정확도 점수를 획득하여 인공 지능 분야에서 획기적인 발전을 이루었습니다..이 성능은 OpenAI o3-mini, o1, DeepSeek-R1 등을 비롯한 여러 다른 주요 AI 모델보다 눈에 띄게 높습니다.

리저닝 2.0

AIME 테스트의 경쟁 수학에서 추론 2.0은 OpenAI O1 및 Sonnet 3.7을 능가했습니다.논리와 고급 추론이 필요한 문제를 처리하는 AI의 능력을 평가합니다.

추론 2.0은 GPQA 테스트에서도 인간의 PhD 수준의 정확도를 능가했습니다.사실관계 회상, 추론, 문제 해결이 필요한 복잡한 다단계 질문을 통해 일반적인 추론을 평가합니다.

터보 1.0 및 에이펙스 1.0

Apex 1.0은 업계 표준 아레나-하드-오토 (채팅) 테스트에서 가장 높은 점수를 받았습니다.미묘한 이해와 상황 인식이 필요한 시나리오를 탐색하는 능력에 초점을 맞춰 AI가 복잡한 실제 대화를 얼마나 잘 처리할 수 있는지를 측정합니다.

이 모델은 Math-500, AIME2024 - 추론, GPQA - 추론, 라이브코드벤치 - 코딩, 라이브코드벤치 - 코딩 - 하드 등 다른 벤치마크에서도 탁월합니다.

슈퍼닌자와 함께 시작하세요

일반 AI가 실제 생산성과 만나는 곳.