El razonamiento rentable es clave para los flujos de trabajo de Agentic

En Ninja AI, creemos que la IA de vanguardia debe ser potente y accesible, y ayudar a los usuarios a aumentar la productividad sin arruinarse. Durante los últimos dos años, nos hemos centrado en crear un sistema de productividad para las agencias, añadiendo continuamente los últimos avances de la IA a Ninja AI para que sea más inteligente, rápida y capaz.

A lo largo del camino, hemos introducido funciones que requieren flujos de trabajo de agencia sofisticados, como Investigación profunda y Análisis de archivos de varios turnos. También lanzamos una versión beta de un programar flujo de trabajo, lo que permite a Ninja negociar los horarios de las reuniones con varios participantes por correo electrónico.

A medida que perfeccionamos continuamente estas habilidades, reconocemos una necesidad fundamental: mejorar la inteligencia y la toma de decisiones de los Ninja. Reducir los errores en las tareas de alto riesgo (por ejemplo, modificar los eventos del calendario) y habilitar flujos de trabajo más autónomos (por ejemplo, ejecutar tareas compuestas que interactúen con las API y las personas) requieren que nuestros agentes tomen decisiones y predicciones más precisas en muchos tipos de situaciones diferentes.

Hemos descubierto que la incorporación del «pensamiento paso a paso» en nuestros flujos de trabajo aumenta considerablemente su precisión y su capacidad de generalización. El pensamiento paso a paso es un proceso que implica: planificar, desglosar las tareas, dar marcha atrás, verificar y reflexionar antes de ejecutar las tareas mediante llamadas inteligentes a funciones. Los modelos de razonamiento recientes han aplicado con éxito el «pensamiento paso a paso» para resolver problemas matemáticos, científicos y de codificación complejos. Sin embargo, debido a las siguientes limitaciones, estos modelos no son adecuados para nuestros flujos de trabajo de Ninja Agentic:

En primer lugar, la mayoría de los modelos de razonamiento actuales son muy caros. Por ejemplo, una única tarea agencial compleja que utilice API O1 de OpenAI podría costar entre 0,75 y 2,25 dólares1 - es decir, el coste «por tarea», que es un precio que es económicamente insostenible para nosotros como empresa y también inviable para los clientes si les repercutiéramos los costes por tarea.

1Suponiendo que cada tarea de agencia requiere aproximadamente entre 5000 y 10 000 tokens de entrada y entre 10 000 y 30 000 tokens de salida

En segundo lugar, los modelos de razonamiento más asequibles no tienen las funciones necesarias para impulsar los flujos de trabajo de las agencias. Por ejemplo, DeepSeek R1 es un modelo de razonamiento libre, pero es limitado. El R1, debido a su tamaño, requiere las GPU Nvidia H200 (o superiores) para obtener una alta latencia y un bajo rendimiento para el modelo, lo que dificulta su uso en un sistema de chat orientado a tareas en tiempo real. El uso de los H200 también hace que su funcionamiento sea caro. Además, R1 tiene dificultades para gestionar las tareas generales de ingeniería de software y capacidad; estas limitaciones se confirman en la última sección del Papel R1.

Además, los modelos de razonamiento existentes carecen de personalizaciones. En Ninja, aspiramos a construir el sistema de agencia más avanzado para la productividad. Por ello, necesitamos la capacidad de ajustar los modelos para que se adapten mejor a nuestras necesidades. Esto no es posible cuando se accede a los modelos de razonamiento actuales a través de una API o cuando se utilizan grandes modelos de razonamiento de código abierto existentes (como el parámetro R1 del 671B).

Dados estos inconvenientes, decidimos diseñar nuestro propio sistema de razonamiento, SuperAgent-R 2.0, para ayudarnos a crear un sistema de agentes sostenible que sea rápido, asequible y que los clientes puedan ajustar con precisión. \

Modelo de razonamiento de Ninja - SuperAgent-R 2.0

SuperAgent-R 2.0 es un sistema de IA compuesto: aprovecha el propio modelo perfeccionado de Ninja con capacidad de razonamiento, que se basa en DeepSeek R1 destilado en Llama 70B. El SuperAgent-R 2.0 también usa otros modelos para apoyar el razonamiento mediante optimizaciones avanzadas a nivel de inferencia. Todo el sistema se ejecuta de principio a fin en la infraestructura de AWS, lo que lo hace asequible y escalable. El resultado final ofrece un rendimiento casi de última generación a una fracción del coste de los modelos propietarios, como el O, el O3-mini (alto) de OpenAI o el Sonnet 3.7 (modo pensante) de Anthropic.

SuperAgent-R 2.0 reúne varias innovaciones pioneras en la industria para crear un sistema que pueda completar tareas de razonamiento complejas a bajo costo. Un componente clave del sistema es un nuevo enfoque de razonamiento multiengranaje. A diferencia de otros modelos que obligan a los usuarios a utilizar un nivel fijo de cálculo, nuestro sistema ajusta de forma dinámica el esfuerzo de razonamiento en función de la complejidad de las tareas. Los niveles de cálculo del SuperAgent son:

- Sin pensar: para búsquedas sencillas y respuestas rápidas.

- Pensamiento ligero: para tareas de complejidad media, como el razonamiento estructurado.

- Pensamiento elevado: para tareas de razonamiento profundo de varios pasos que requieren lógica avanzada.

SuperAgent-R 2.0 puede determinar por sí mismo el esfuerzo de razonamiento y ajustarse automáticamente a la solicitud del usuario. Es cierto que esto siempre es difícil de lograr porque el sistema todavía puede pensar demasiado. Revisamos constantemente los comentarios de los clientes y seguiremos realizando mejoras.

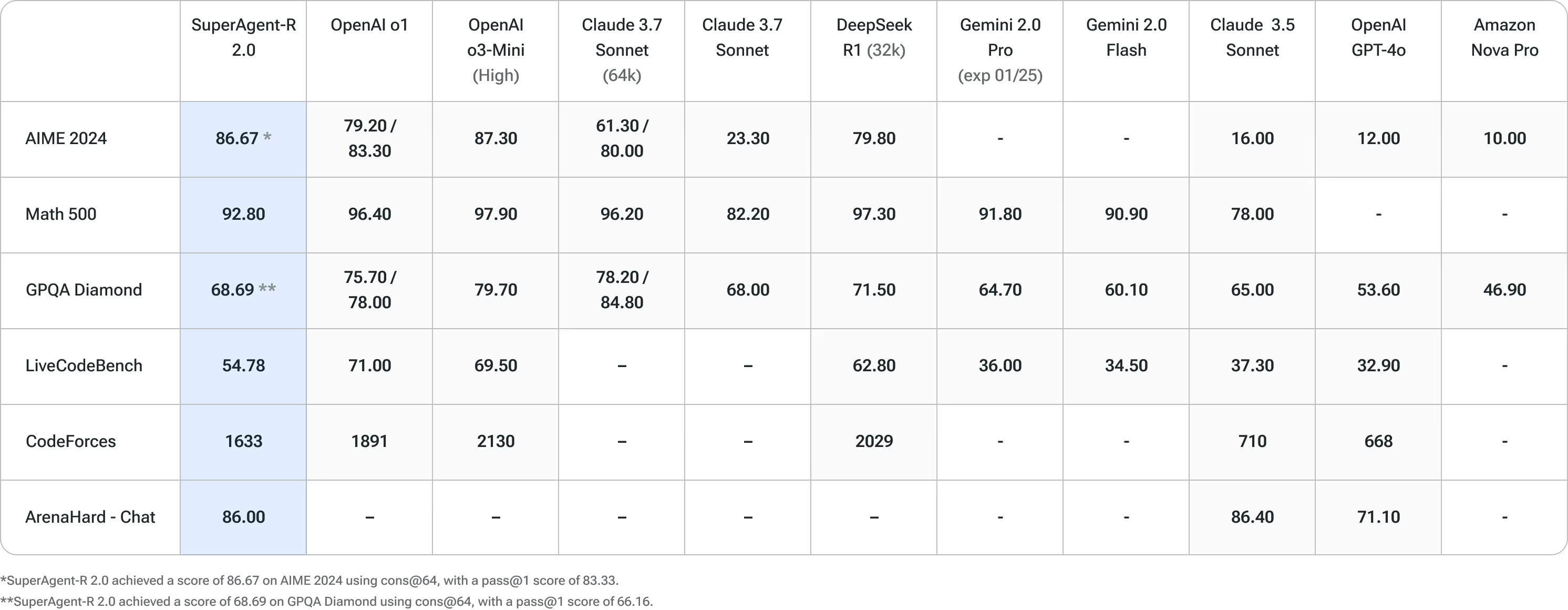

SuperAgent-R 2.0 se ha sometido a rigurosas pruebas comparándolas con los principales puntos de referencia de inteligencia artificial, lo que demuestra el mejor rendimiento de su clase en varios dominios. En estas pruebas, SuperAgent-R 2.0 compite constantemente con los principales modelos de IA, lo que demuestra su capacidad superior de razonamiento y resolución de problemas.

Ventajas de SuperAgent-R 2.0 en comparación con DeepSeek R1

DeepSeek-R1, con razón, ha recibido mucha atención recientemente como un modelo de razonamiento libre de alta calidad. Sin embargo, tiene algunos inconvenientes notables. Una de las principales limitaciones son sus requisitos de hardware (que hemos mencionado anteriormente): debe funcionar con las GPU Nvidia H200 (o superiores), lo que puede aumentar los costes operativos; y aun así, no es un modelo rápido para realizar inferencias rápidas en tiempo real.

Además, al evaluar DeepSeek-R1 y revisar su documentación, identificamos otros inconvenientes que podrían afectar a nuestros clientes:

- Capacidad general: DeepSeek-R1 no supera a DeepSeek-v3 en áreas clave como las llamadas a funciones, las interacciones de varios turnos y los juegos de rol complejos.

- Capacidades lingüísticas: DeepSeek-R1 está optimizado para chino e inglés, lo que puede ocasionar problemas al gestionar consultas en otros idiomas. Dado que brindamos soporte a los usuarios en varios idiomas, es esencial contar con un soporte lingüístico más amplio.

- Sensibilidad a las indicaciones: DeepSeek-R1 es muy sensible a las variaciones de las notificaciones. Las notificaciones de pocos disparos, algo habitual entre los clientes, degradan el rendimiento general, lo que hace que sea menos fiable para nuestras necesidades.

- Tareas de ingeniería de software: los resultados comparativos indican que DeepSeek-R1 tiene capacidades de ingeniería de software limitadas. Dado que muchos de nuestros clientes confían en Ninja para realizar tareas relacionadas con el software, esta limitación afectaría considerablemente a su experiencia.

DeepSeek R1 es un modelo fantástico, pero estos factores hacen que DeepSeek R1 sea menos adecuado para nuestras necesidades e impulsaron nuestra decisión de desarrollar SeuperAgent-R 2.0.

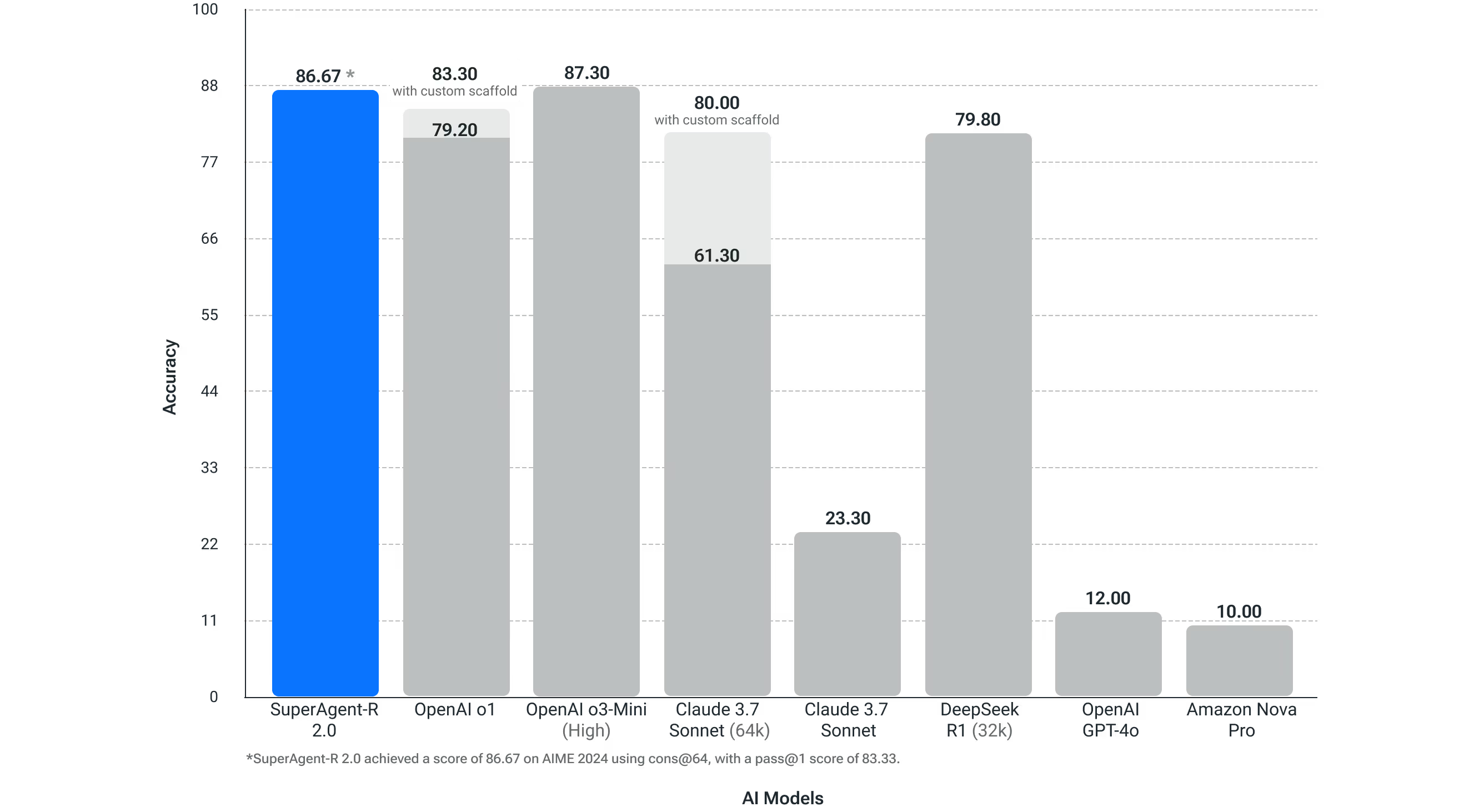

Matemáticas de competición (AIME 2024)

En el caso de las matemáticas competitivas, un factor determinante de la capacidad de razonamiento, nuestras pruebas han demostrado que el SuperAgent-R 2.0 supera el rendimiento de los modelos OpenAI O1, Sonnet 3.7 (pensamiento extendido de 64 000) y DeepSeek R1, y el SuperAgent-R 2.0 está a la par con el modelo de razonamiento alto de OpenAI O3. OpenAI tiene datos publicados que un modelo que sea bueno en matemáticas competitivas, como AIME 2024, será bueno en los flujos de trabajo autónomos de las agencias.

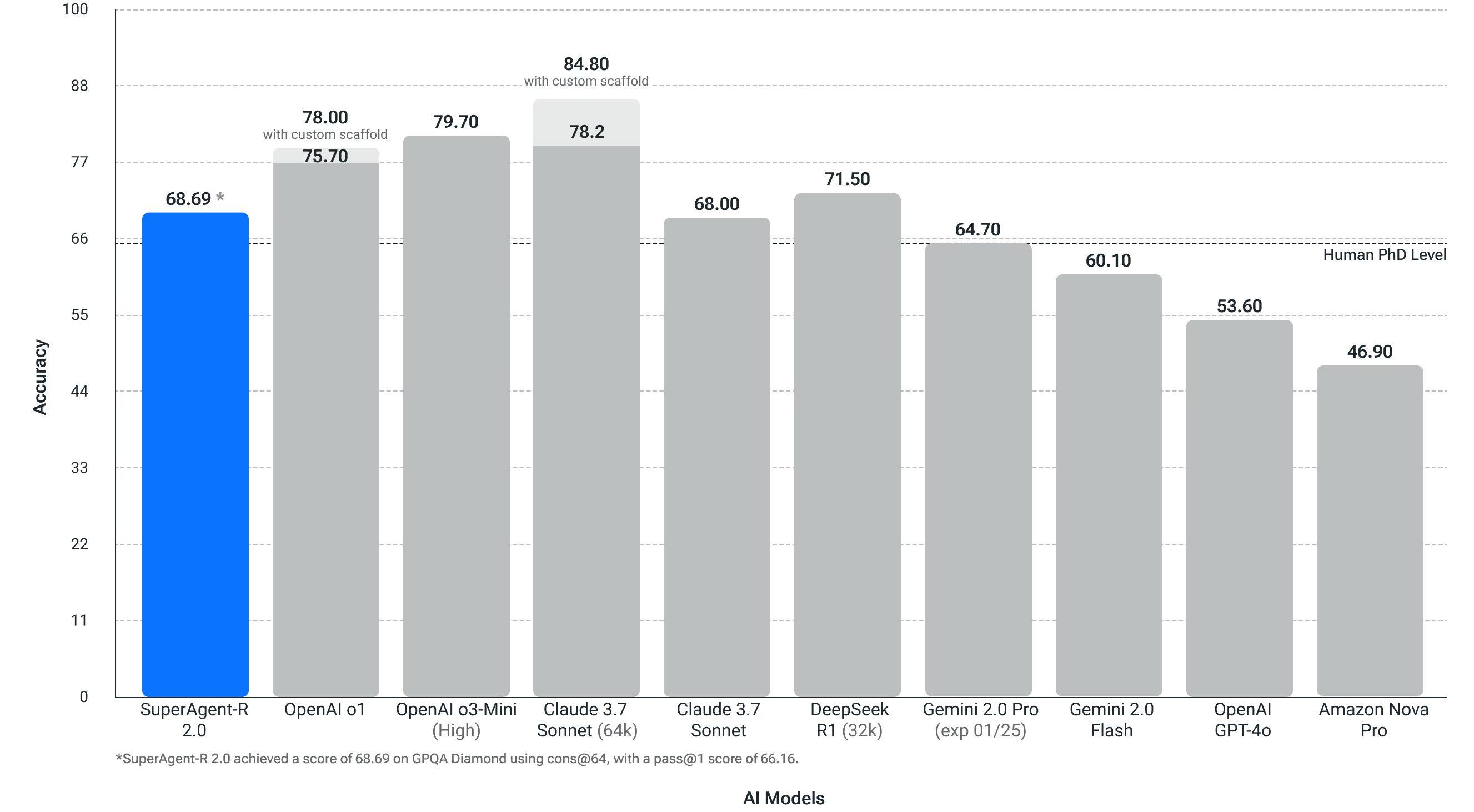

Preguntas científicas a nivel de doctorado (GPQA Diamond)

Esta prueba mide qué tan bien un sistema puede resolver las preguntas científicas de nivel de doctorado. Esta prueba es importante para nuestros usuarios, que trabajan en muchos sectores diferentes y tienen diversas funciones laborales. SuperAgent-R 2.0 superó la precisión de un doctorado humano en este punto de referencia de problemas de física, biología y química.

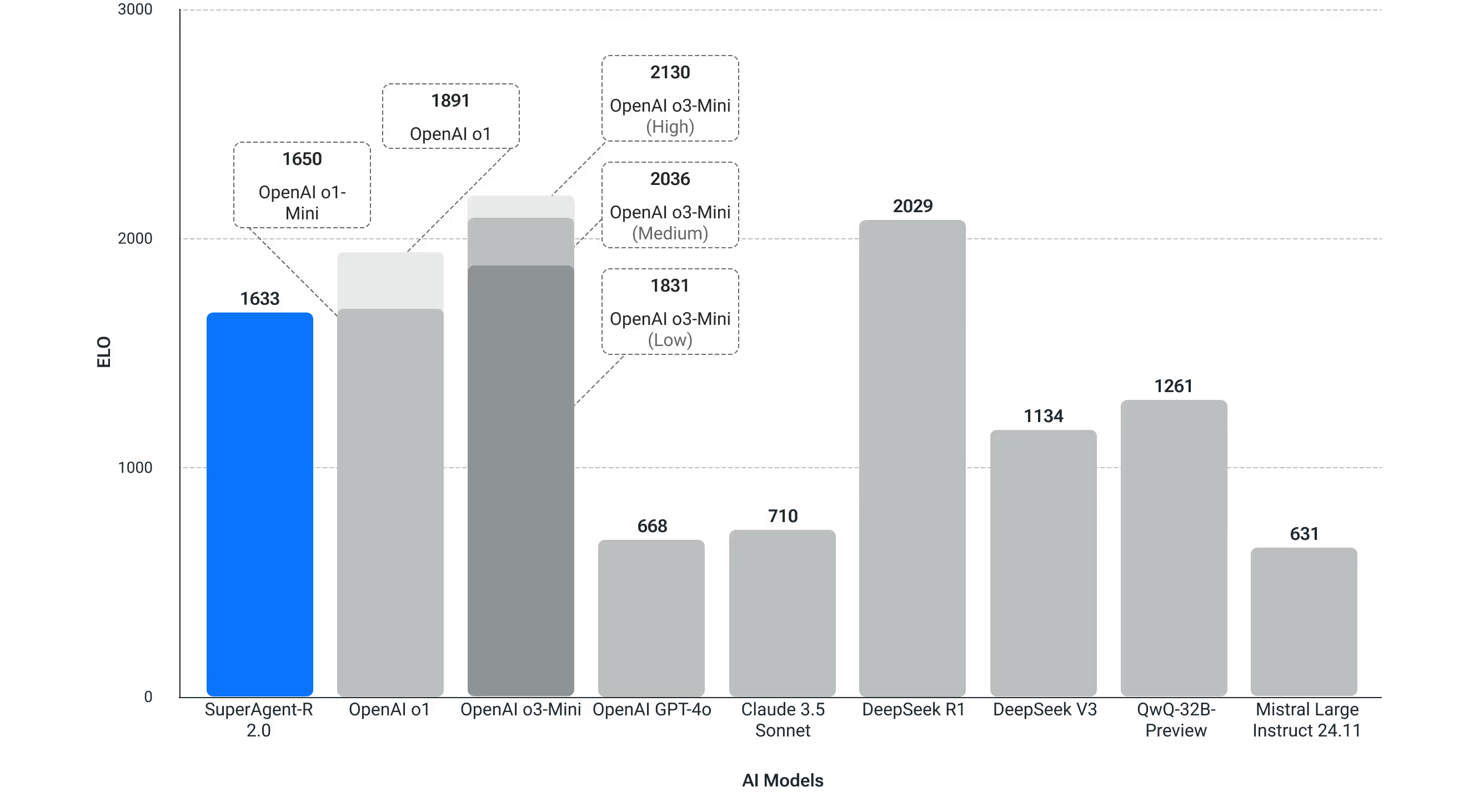

Código de competencia (Codeforces)

En la programación competitiva de Codeforce, SuperAgent-R 2.0 logra puntajes ELO progresivamente más altos que DeepSeek V3 y puntajes competitivos con muchos modelos de OpenAI.

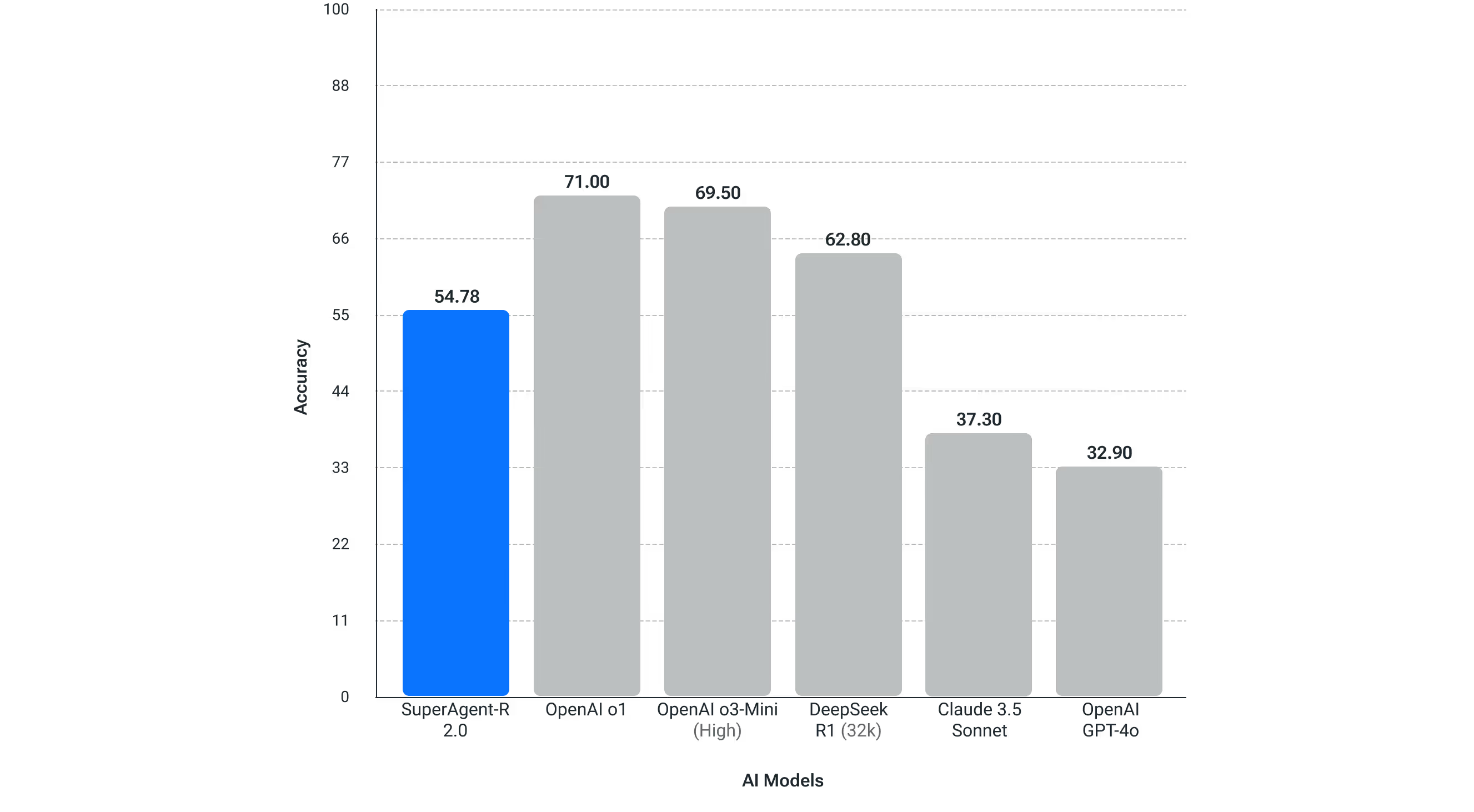

LiveBench - Codificación

Se utiliza para probar el rendimiento de la codificación en el mundo real.

SuperAgent-R 2.0 está disponible en myninja.ai

A diferencia de otros productos del mercado, no cobraremos tarifas de suscripción adicionales por el acceso ilimitado al modelo SuperAgent-R 2.0. Este modelo está disponible para todos los usuarios de los planes Ultra (15$ al mes) y Business (20$ al mes por asiento). Detalles de precios. Tenga en cuenta que nos reservamos el derecho de limitar el uso en función del uso excesivo.

Pruébalo en myninja.ai

Qué sigue: nuevas habilidades y acceso a la API

De cara al futuro, seguiremos ofreciendo flujos de trabajo basados en agencias, con la tecnología SuperAgent-R 2.0, para ayudar a nuestros usuarios a ser más productivos. Una de las primeras formas en las que pensamos utilizar SuperAgent-R 2.0 es mejorar nuestra función DeepResearch.

También tenemos previsto ofrecer pronto acceso mediante API a SuperAgent-R 2.0, lo que ayudará a los desarrolladores y a las empresas a crear sus propios sistemas personalizados.