O raciocínio econômico é fundamental para os fluxos de trabalho da Agentic

Na Ninja AI, acreditamos que a IA de ponta deve ser poderosa e acessível, ajudando os usuários a aumentar a produtividade sem gastar muito. Nos últimos dois anos, nos concentramos em criar um sistema de produtividade agente, adicionando continuamente os mais recentes avanços de IA à Ninja AI para torná-la mais inteligente, rápida e capaz.

Ao longo do caminho, introduzimos recursos que exigem fluxos de trabalho agentes sofisticados, como Pesquisa profunda e Análise de arquivos Multi-Turn. Também lançamos uma versão beta de um fluxo de trabalho de agendamento, permitindo que o Ninja negocie horários de reunião com vários participantes por e-mail.

À medida que refinamos continuamente essas habilidades, reconhecemos uma necessidade crítica: aprimorar a inteligência e a tomada de decisões do Ninja. Reduzir erros em tarefas de alto risco (por exemplo, modificar eventos do calendário) e permitir fluxos de trabalho mais autônomos (por exemplo, executar tarefas compostas que interagem com APIs e pessoas) exigem que nossos agentes tomem decisões e previsões mais precisas em muitos tipos diferentes de situações.

Descobrimos que incorporar o “pensamento passo a passo” em nossos fluxos de trabalho aumenta significativamente sua precisão e capacidade de generalização. O pensamento passo a passo é um processo que envolve: planejar, dividir tarefas, retroceder, verificar e refletir antes de executar tarefas por meio de chamadas inteligentes de funções. Modelos de raciocínio recentes aplicaram com sucesso o “pensamento passo a passo” para resolver problemas complexos de matemática, ciências e codificação. No entanto, devido às seguintes limitações, esses modelos não são adequados para nossos fluxos de trabalho da Ninja Agentic:

Primeiro, os modelos de raciocínio mais atuais são muito caros. Por exemplo, uma única tarefa agente complexa usando API O1 da OpenAI pode custar entre $0,75 e $2,251 - esse é o custo “por tarefa”, que é um preço economicamente insustentável para nós como empresa e também inviável para os clientes se repassássemos os custos para eles por tarefa.

1Assumir que cada tarefa do agente exija cerca de 5.000 a 10.000 tokens de entrada e 10.000 a 30.000 tokens de saída

Em segundo lugar, os modelos de raciocínio mais acessíveis não têm os recursos necessários para potencializar fluxos de trabalho agentes. Por exemplo, o DeepSeek R1 é um modelo de raciocínio livre — mas é limitado. O R1, devido ao seu tamanho, requer GPUs Nvidia H200s (ou melhores) para alta latência e baixa taxa de transferência do modelo; portanto, dificulta seu uso em um sistema de bate-papo orientado a tarefas em tempo real. O uso do H200s também torna sua operação cara. Além disso, o R1 tem desafios em lidar com tarefas gerais de engenharia de software e de capacidade - essas limitações são confirmadas pela última seção do Papel R1.

Além disso, os modelos de raciocínio existentes carecem de personalizações. Na Ninja, aspiramos construir o sistema de agentes mais avançado para produtividade. Dessa forma, precisamos da capacidade de ajustar os modelos para melhor atender às nossas necessidades. Isso não é possível ao acessar os modelos de raciocínio atuais via API ou ao usar grandes modelos de raciocínio de código aberto existentes (como o parâmetro 671B R1).

Dadas essas desvantagens, decidimos projetar nosso próprio sistema de raciocínio - o SuperAgent-R 2.0 - para nos ajudar a viabilizar um sistema agente sustentável que seja rápido, acessível e ajustável para os clientes. \

Modelo de raciocínio do Ninja - SuperAgent-R 2.0

O SuperAgent-R 2.0 é um sistema de IA composto: ele aproveita o modelo refinado da Ninja com capacidade de raciocínio, que é baseado no DeepSeek R1 destilado no Llama 70B. O SuperAgent-R 2.0 também usa outros modelos para apoiar o raciocínio por meio de otimizações avançadas em nível de inferência. Todo o sistema é executado de ponta a ponta na infraestrutura da AWS, o que o torna acessível e escalável. O resultado final oferece desempenho quase de última geração por uma fração do custo de modelos proprietários, como O, O3-mini (alto) da OpenAI ou Sonnet 3.7 da Anthropic (modo de pensamento).

O SuperAgent-R 2.0 reúne várias inovações pioneiras do setor para criar um sistema que pode concluir tarefas complexas de raciocínio a baixos custos. Um componente chave do sistema é uma nova abordagem de raciocínio multiengrenagem. Ao contrário de outros modelos que forçam os usuários a um nível fixo de computação, nosso sistema ajusta dinamicamente o esforço de raciocínio com base na complexidade da tarefa. O nível de computação do SuperAgent é:

- Sem pensar — Para pesquisas diretas e respostas rápidas.

- Pensamento leve — Para tarefas de média complexidade, como raciocínio estruturado.

- Pensamento elevado — Para tarefas de raciocínio profundas e de várias etapas que exigem lógica avançada.

O SuperAgent-R 2.0 pode autodeterminar o esforço de raciocínio e se ajustar automaticamente a uma solicitação do usuário. É certo que isso é difícil de conseguir o tempo todo porque o sistema ainda pode pensar demais. Estamos constantemente analisando os comentários dos clientes e continuaremos fazendo melhorias.

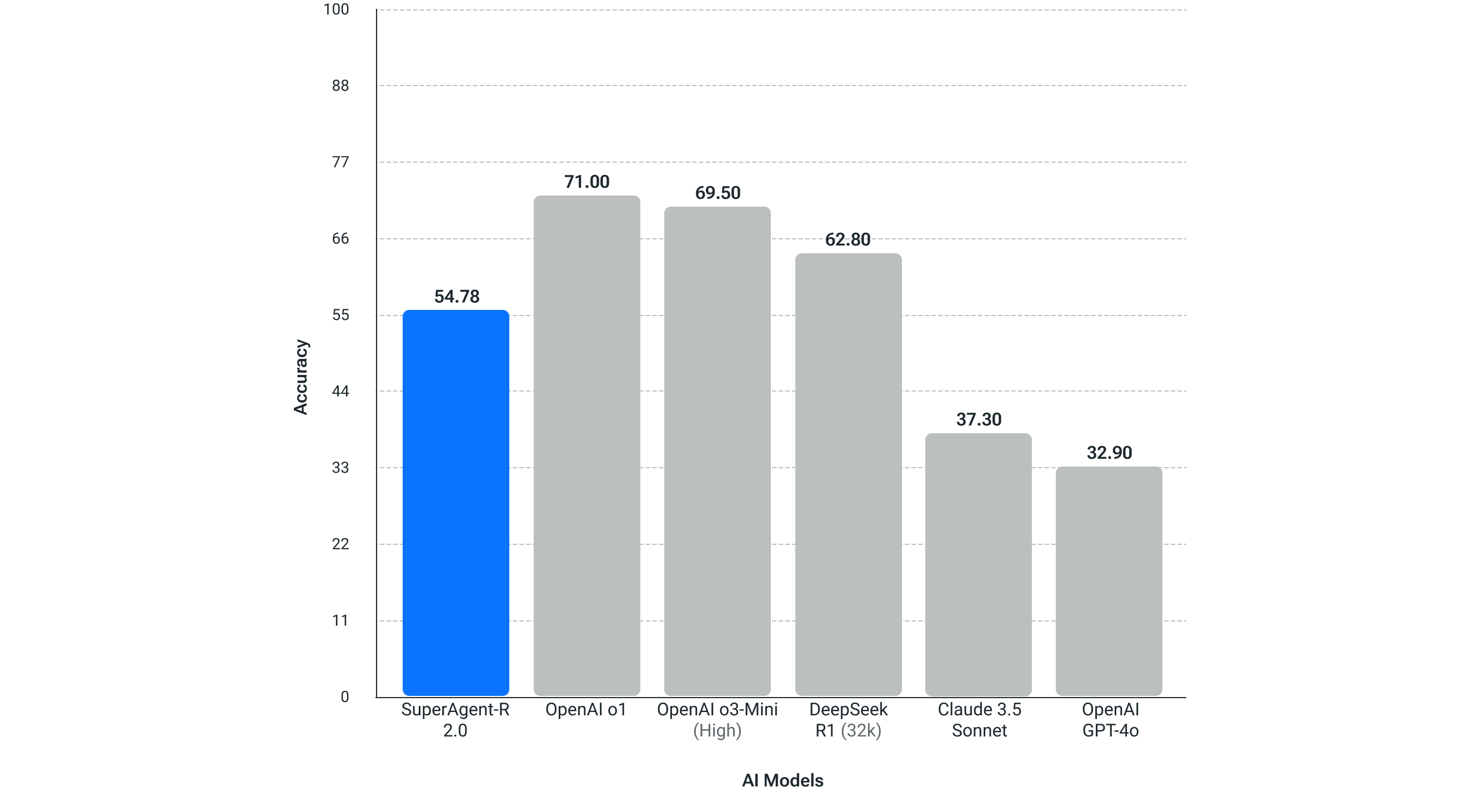

O SuperAgent-R 2.0 passou por testes rigorosos em relação aos principais benchmarks de IA, demonstrando o melhor desempenho da categoria em vários domínios. Nesses testes, o SuperAgent-R 2.0 é consistentemente competitivo com os principais modelos de IA, provando suas habilidades superiores de raciocínio e resolução de problemas.

Vantagens do SuperAgent-R 2.0 em comparação com o DeepSeek R1

O DeepSeek-R1, com razão, recebeu muita atenção recentemente como um modelo de raciocínio livre e de alta qualidade. No entanto, ele vem com algumas desvantagens notáveis. Uma grande limitação é o requisito de hardware (que mencionamos acima): ele deve ser executado em GPUs Nvidia H200 (ou melhores), o que pode aumentar os custos operacionais; e mesmo assim, não é um modelo rápido para inferência rápida em tempo real.

Além disso, ao avaliarmos o DeepSeek-R1 e revisarmos sua documentação, identificamos outras desvantagens que poderiam afetar nossos clientes:

- Capacidade geral: o DeepSeek-R1 fica aquém do DeepSeek-v3 em áreas-chave, como chamada de funções, interações em vários turnos e dramatizações complexas.

- Capacidades linguísticas: O DeepSeek-R1 é otimizado para chinês e inglês, o que pode causar problemas ao lidar com consultas em outros idiomas. Como oferecemos suporte a usuários em vários idiomas, um suporte linguístico mais amplo é essencial.

- Sensibilidade de solicitação: O DeepSeek-R1 é altamente sensível a variações de solicitação. A solicitação de poucos disparos, que é comum entre os clientes, degrada o desempenho geral, tornando-o menos confiável para nossas necessidades.

- Tarefas de engenharia de software: Os resultados do benchmark indicam que o DeepSeek-R1 tem capacidades limitadas de engenharia de software. Como muitos de nossos clientes confiam na Ninja para tarefas relacionadas a software, essa limitação afetaria significativamente sua experiência.

O DeepSeek R1 é um modelo fantástico, mas esses fatores tornam o DeepSeek R1 menos adequado às nossas necessidades e impulsionaram nossa decisão de desenvolver o SeuperAgent-R 2.0.

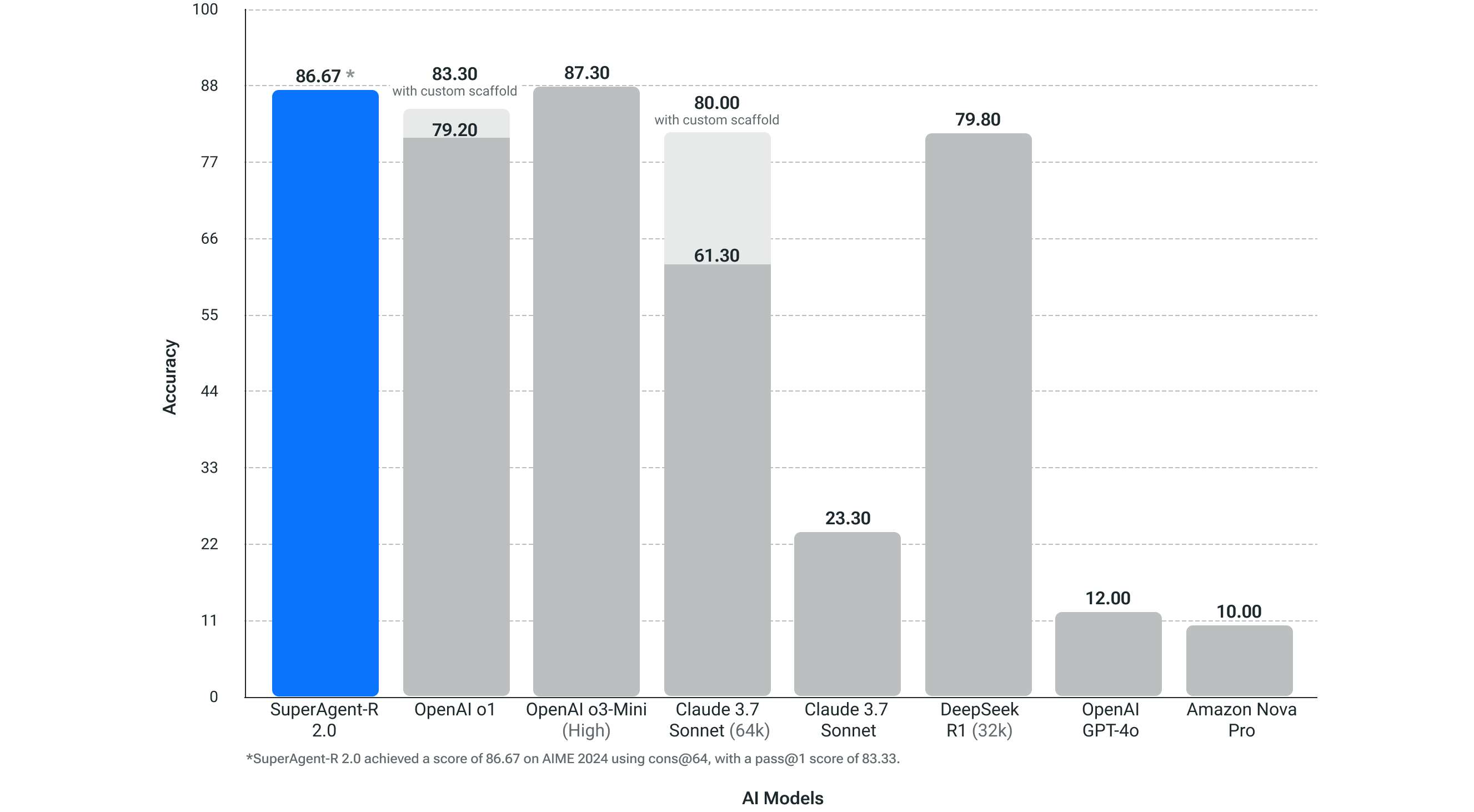

Matemática da competição (AIME 2024)

Para a matemática competitiva, um determinante da capacidade de raciocínio, nossos testes mostraram que o SuperAgent-R 2.0 está excedendo o desempenho dos modelos OpenAI O1, Sonnet 3.7 (pensamento estendido de 64k), DeepSeek R1 e SuperAgent-R 2.0 está no mesmo nível do modelo de raciocínio OpenAI O3-high. OpenAI tem dados publicados que um modelo que é bom em matemática competitiva, como o AIME 2024, será bom em fluxos de trabalho de agentes autônomos.

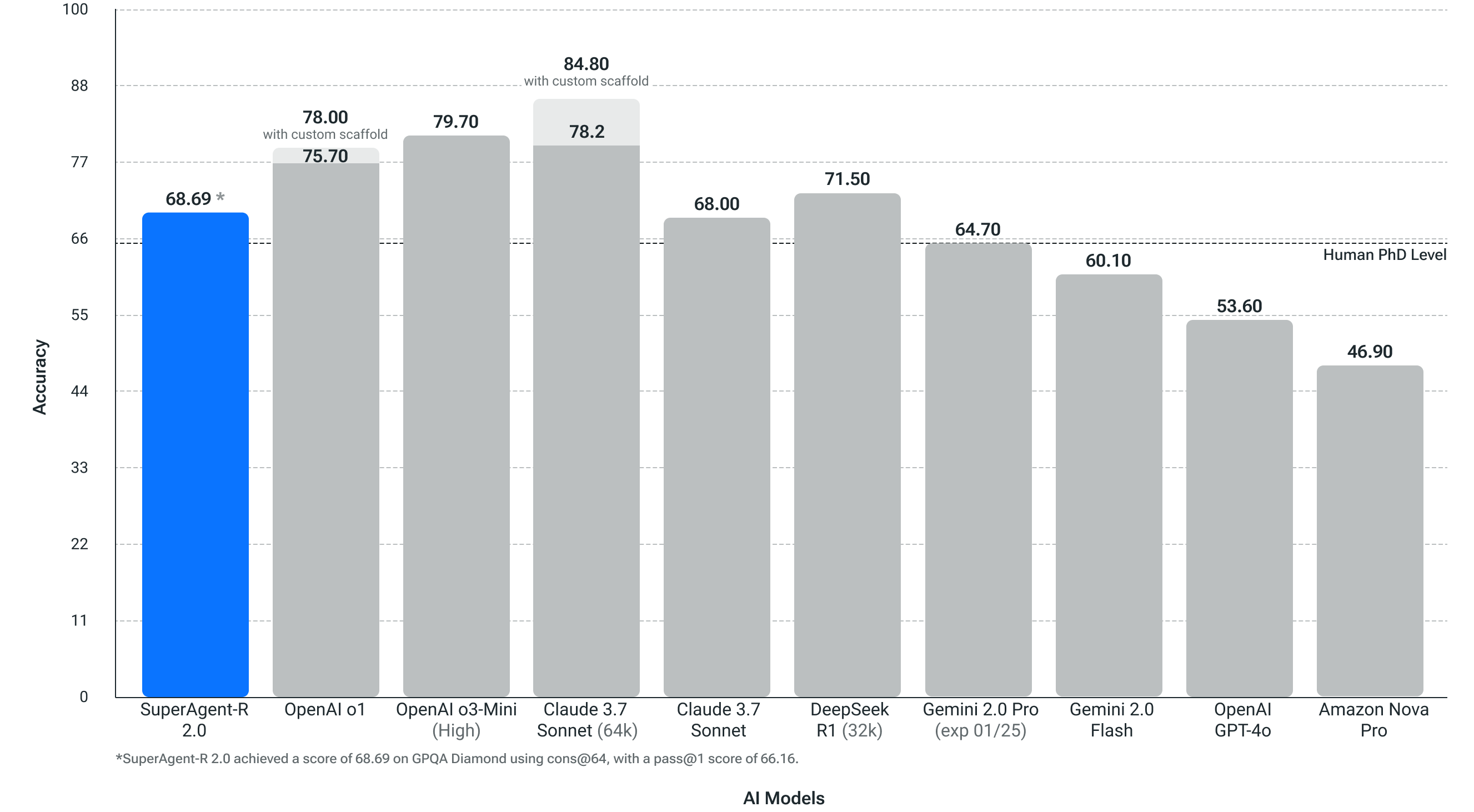

Questões científicas em nível de doutorado (GPQA Diamond)

Esse teste mede o quão bem um sistema pode resolver questões científicas em nível de doutorado. Esse teste é importante para nossos usuários que trabalham em diversos setores e têm várias funções de trabalho. O SuperAgent-R 2.0 excedeu a precisão do nível de doutorado humano nesta referência de problemas de física, biologia e química.

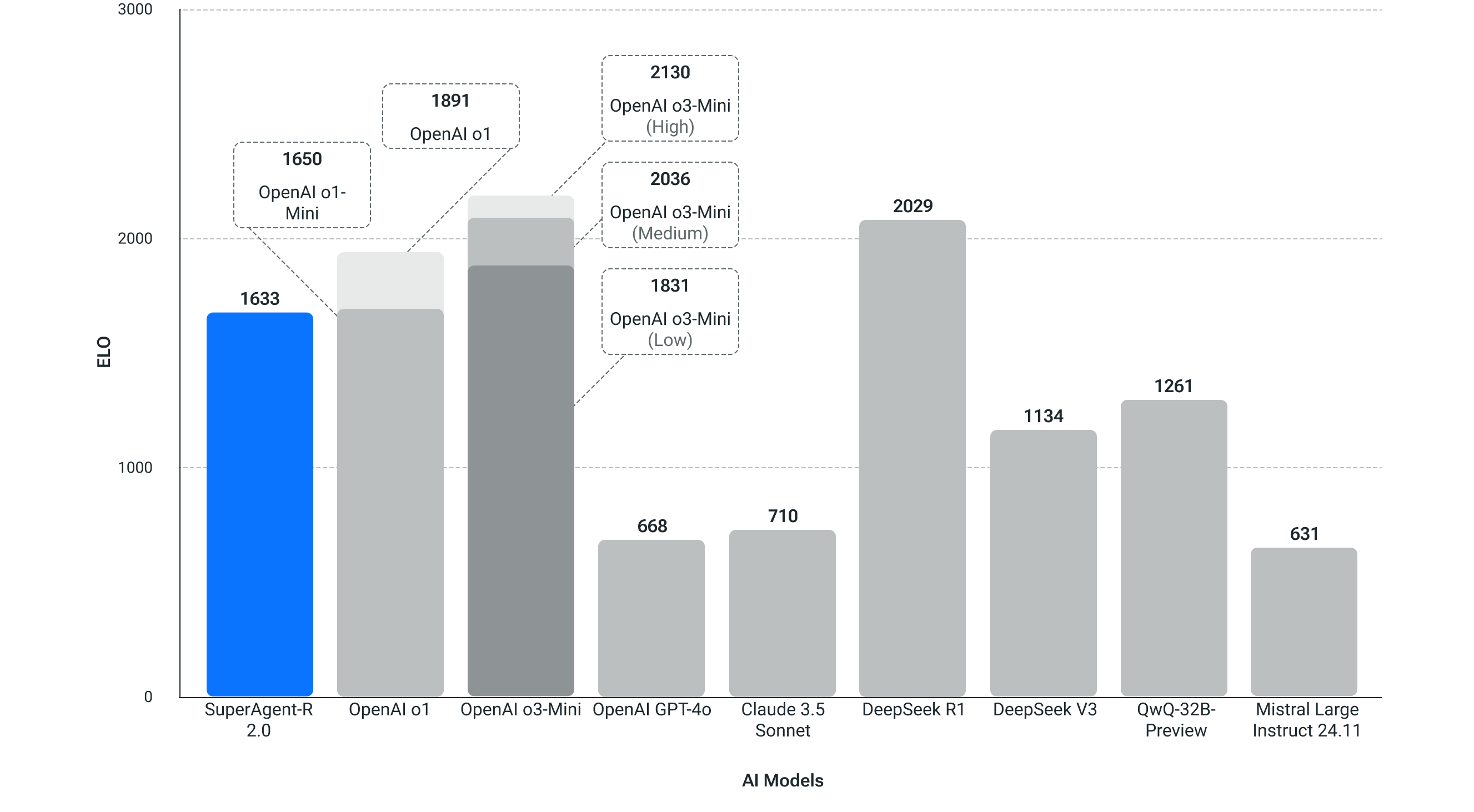

Código da Concorrência (Codeforces)

Na programação competitiva da Codeforce, o SuperAgent-R 2.0 alcança pontuações ELO progressivamente mais altas do que o DeepSeek V3 e pontuações competitivas com muitos modelos OpenAI.

LiveBench - Codificação

Usado para testar o desempenho de codificação no mundo real.

O SuperAgent-R 2.0 está disponível em myninja.ai

Ao contrário de vários produtos no mercado, não cobraremos taxas adicionais de assinatura pelo acesso ilimitado ao modelo SuperAgent-R 2.0. Esse modelo está disponível para todos os nossos usuários Ultra ($15/mês) e usuários do plano Business ($20/mês/assento). Detalhes do preço. Observe que nos reservamos o direito de limitar o uso com base no uso excessivo.

Experimente em myninja.ai

O que vem por aí: novas habilidades e acesso à API

À medida que olharmos para o futuro, continuaremos a oferecer fluxos de trabalho agentes, baseados no SuperAgent-R 2.0, para ajudar nossos usuários a serem mais produtivos. Uma das primeiras maneiras pelas quais planejamos usar o SuperAgent-R 2.0 é aprimorar nosso recurso de pesquisa profunda.

Também planejamos fornecer acesso de API ao SuperAgent-R 2.0 em breve, ajudando desenvolvedores e empresas a criar seus próprios sistemas personalizados.