Tiefgründige Recherchen sind selten eine einmalige Aufgabe. Es ist ein mehrstufiger Prozess: den Plan skizzieren, Erkenntnisse gewinnen, Quellen auswerten, Folgemaßnahmen verfeinern, Analysen zusammenfassen und Ergebnisse ausarbeiten. Bei GPU-basierten Systemen kann der Abschluss einer Phase dieser Zyklen 10 Minuten in Anspruch nehmen — oder länger, wenn Sie neue Fragen haben. Diese Reibung erstickt die Iteration.

Heute ist NinjaTech AI stolz darauf, dies bekannt zu geben SuperNinja Fast Deep Research, unterstützt durch unsere strategische Partnerschaft mit Großhirne — liefert mehr als 5x schnellere Forschungsschleifen als herkömmliche Modelle. Jetzt ist es nicht nur möglich, sondern auch mühelos, iterative, mehrstufige Erkundungen innerhalb von Minuten — statt in Dutzenden von Minuten durchzuführen.

Warum das jetzt wichtig ist

SuperNinja Fast Deep Research ist nicht nur schnell. Es ist Transformation in Bewegung:

- Schnelligkeit ohne Kompromisse: Komplexe Abfolgen von Argumentation, Quellenbewertung und Synthese, die früher mehr als 10 Minuten dauerten, sind jetzt in nur 1—2 Minuten abgeschlossen.

- Interaktive Intelligenz: Durch die Iteration in Echtzeit wird die tiefgreifende KI-Recherche von einem statischen Bericht zu einem dynamischen On-Demand-Partner.

- Keine Abstriche bei der Qualität: Jede Antwort basiert auf zitierten Quellen, strukturierter Argumentation und gründlicher Analyse — so wird sichergestellt, dass der Geschwindigkeitsschub nicht auf Kosten der Tiefe oder Genauigkeit geht.

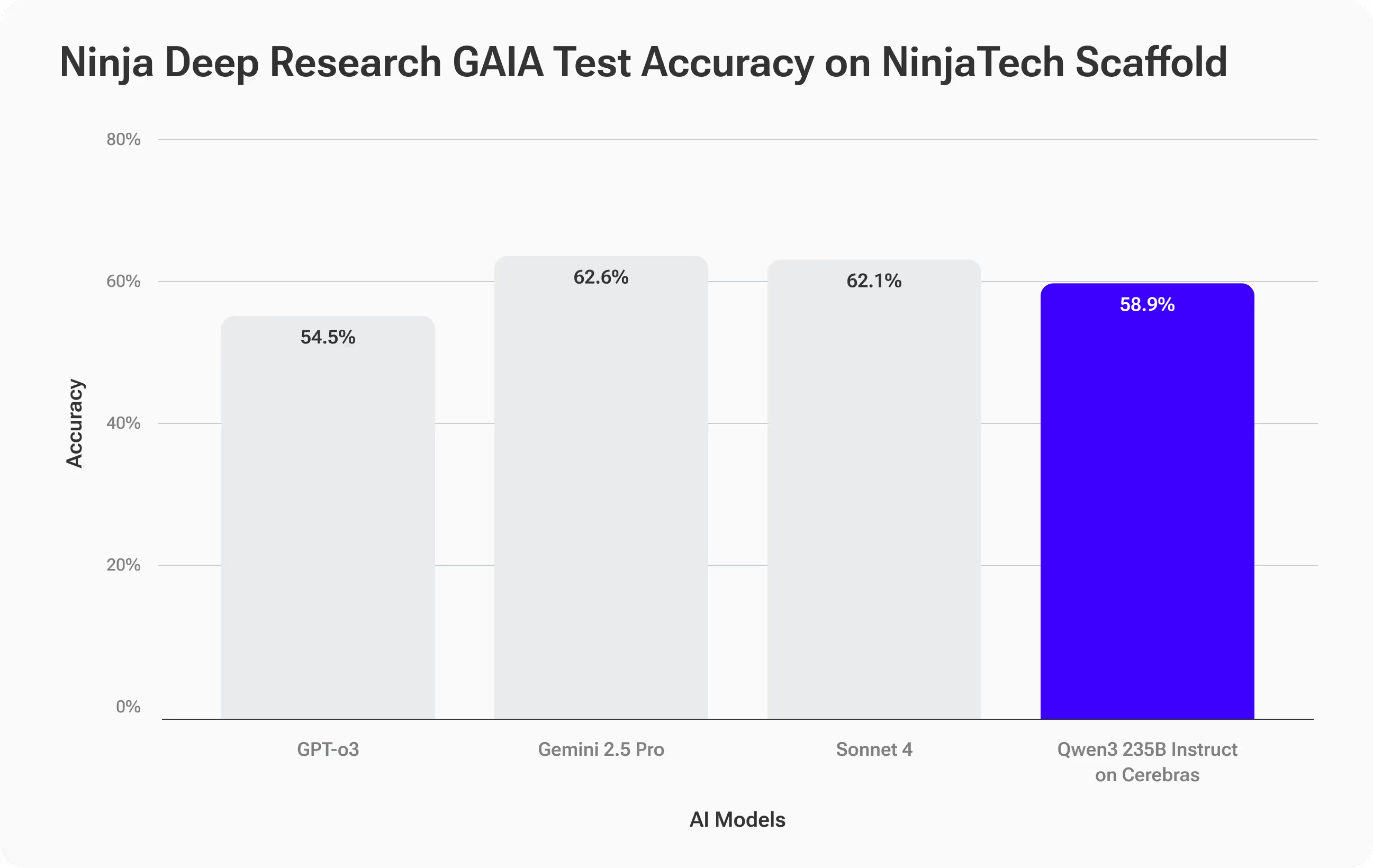

Benchmarks: Vergleichbare Genauigkeit, bahnbrechende Geschwindigkeit

Um sowohl die Qualität als auch die Leistung zu bewerten, haben wir getestet SuperNinja Fast Deep Research, angetrieben durch das Qwen3-235B-Modell auf Cerebras-Hardware, unter Verwendung der GAIA-Benchmark—ein anspruchsvoller Praxistest für mehrstufiges Denken und den Einsatz von Werkzeugen (arXiv-Link).

Die GAIA-Aufgaben sind bewusst schwierig: 466 Fragen mit überprüfbaren Antworten, mit denen nicht nur die Erinnerung an Fakten gemessen wird, sondern auch die Fähigkeit, zu planen, Quellen zu sammeln, Komplexität zu durchdenken und genaue Ergebnisse zu liefern.

Genaue Ergebnisse — die Besten

SuperNinja Fast Deep Research erreicht Genauigkeit von 58,9%, verfolgt Spitzenmodelle wie Anthropics Sonnet 4 genau (62,1%) und Gemini 2.5 Pro (62,6%) und übertrifft OpenAis GPT-O3 (54,5%).

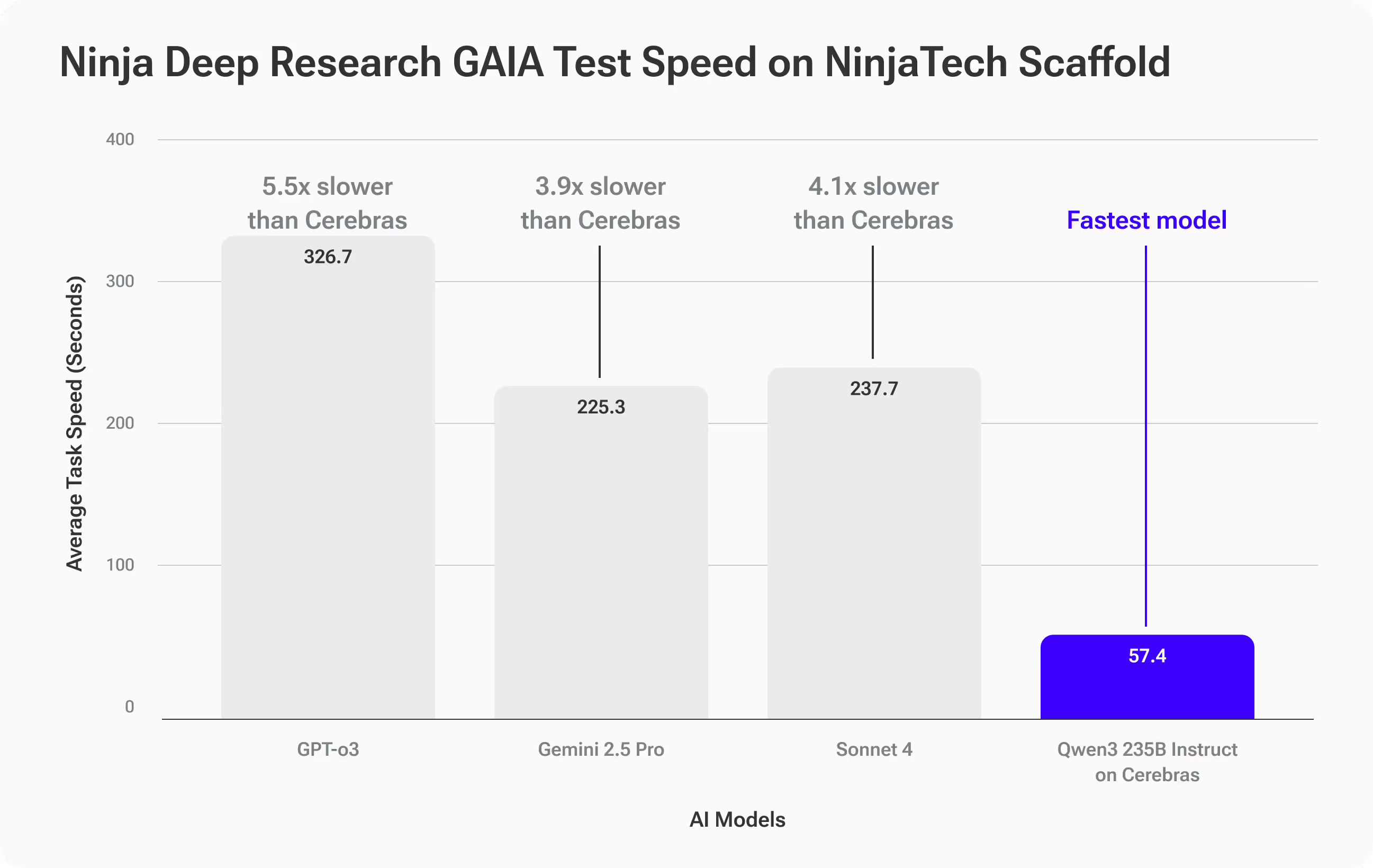

Speed Results — eine Klasse für sich

Wo Qwen3-235B auf Cerebras sich wirklich trennte, war Geschwindigkeit:

- Durchschnittliche Bearbeitungszeit: 57,4 Sekunden pro GAIA-Aufgabe

- 3,9x schneller als Gemini 2.5 Pro (225,3 s)

- 4,1x schneller als Sonett 4 (237,7s)

- 5,5x schneller als GPT-O3 (316,7 s)

Was das für dich bedeutet

Du bekommst Genauigkeit auf Augenhöhe mit führenden Spitzenmodellen—aber mit dramatisch schnelleren Antworten. Für tiefgreifende Forschungsabläufe, die Iterationen erfordern, eröffnet diese Geschwindigkeit völlig neue Möglichkeiten: Follow-ups, Pivots und tiefere Tauchgänge, die zuvor zu langsam gewesen wären.

Beispiel aus der Praxis: Wenn Geschwindigkeit die Strategie bestimmt

Stellen Sie sich vor, Sie sind ein Markenstratege, der ein globales Konsumgüterunternehmen berät. Der CMO möchte auf dem Führungsgipfel nächste Woche die Diskussionen über ein Unternehmens-Rebranding einleiten, bei dem viel auf dem Spiel steht. Sie müssen diesen Raum mit datengestützten Erkenntnissen betreten — nicht nur mit Meinungen.

Sie beginnen mit dieser ausführlichen Rechercheaufforderung:

Recherchieren Sie die 10 bemerkenswertesten Unternehmensrebrandings aus den Jahren 2010—2025 in verschiedenen Branchen und definieren Sie anhand klarer Kriterien „bemerkenswert“, und sammeln Sie glaubwürdige, zitierte und verlinkte Quellen zu messbaren Veränderungen bei Umsatz, Marktanteil, Kundenstimmung und Markenwert. Normalisieren Sie die Ergebnisse aus Gründen der Vergleichbarkeit und präsentieren Sie sie in einer Tabelle mit allen wichtigen Kennzahlen, kurzen Fallzusammenfassungen für jede Marke und mindestens fünf umsetzbare, evidenzgestützte Erkenntnisse, die ich als Leitfaden für eine Diskussion über eine Rebranding-Strategie verwenden kann.

Bei anderen KI-Recherchetools können Sie 10 bis 15 Minuten auf den ersten Bericht warten. Wenn Sie weitere Fragen haben, für die weitere Untersuchungen erforderlich sind, verlängert sich mit jeder Iteration die Zeit.

Mit SuperNinja Fast Deep Research, jeder Zyklus dauert 1—2 Minuten, sodass Sie schnell iterieren und Ihre Kriterien verfeinern, Randfälle untersuchen, neue Daten hinzufügen und Ihre Erkenntnisse in Echtzeit einem Stresstest unterziehen können. Anstatt einen statischen Bericht zu erstellen, erstellen Sie eine interaktive Tabelle mit verknüpften Quellen, vergleichbaren Kennzahlen und aussagekräftigen, evidenzgestützten Erkenntnissen — bereit, live im Raum präsentiert und angepasst zu werden.

Die Geschwindigkeit macht Sie nicht nur schneller — sie ermöglicht es Ihnen, mehr Blickwinkel zu untersuchen, mehr Annahmen zu validieren und strategische Erkenntnisse zu gewinnen, für die Sie sonst keine Zeit gehabt hätten.

So funktioniert's

Trotz großer Fortschritte bei großen Open-Source-Sprachmodellen besteht nach wie vor eine anhaltende Leistungslücke zwischen diesen Modellen und führenden proprietären Systemen bei komplexen, langfristigen Informationsabrufaufgaben — Herausforderungen, die von Benchmarks wie GAIA gut erfasst werden. Um diese Lücke zu schließen, sind nicht nur größere Modelle, sondern auch intelligentere Schlussfolgerungen erforderlich.

Das Deep Research-System von SuperNinja verwendet eine Gerüst-Framework von Plan & CodeAct das macht aus einem Open-Source-Basismodell — wie Qwen3-Instruct 235B — einen zielorientierten Forscher. Dieses Framework wird iterativ ausgeführt Validierung, Verifizierung und Neuplanung Schleifen, die im Vergleich zur Standardinferenz ungefähr doppelt so viele Argumentationstoken generieren. Diese zusätzliche Denkzeit zahlt sich in der Genauigkeit aus, wodurch charakteristische Modellfehler systematisch reduziert und die Leistung verbessert werden, sodass sie den modernsten proprietären Modellen entspricht.

Wir steigern die Präzision weiter durch eine datengesteuerte Optimierungsebene , das Werkzeugdefinitionen, Parameter und Abrufstrategien auf der Grundlage der Domäne und der Daten eines Kunden anpasst. Diese maßgeschneiderten Einstellungen machen das Modell zuverlässiger für spezielle Forschungsaufgaben, bei denen viel auf dem Spiel steht. Was ist der Kompromiss? Dieser umfassendere, strengere Argumentationsprozess erhöht den Rechenaufwand herkömmlicher GPU-Systeme und verlangsamt jede Iteration aufgrund der längeren Token-Generierung und der Kommunikation zwischen den Grafikprozessoren.

An dieser Stelle hat uns die Inferenz von Cerebras auf Waferskala geholfen, einen enormen Leistungszuwachs zu erzielen. Indem wir das gesamte Modell vollständig im On-Chip-SRAM ausführen und die Inferenz superschnell und ohne Engpässe zwischen den GPUs durchführen, beschleunigen wir den gesamten Gerüstkreislauf um 4—6x im Vergleich zu herkömmlichen Systemen. Das bedeutet, dass Sie die Genauigkeit erstklassiger firmeneigener Modelle erhalten — ohne Einbußen bei der Geschwindigkeit — und so iterative, mehrstufige Forschungszyklen in Echtzeit möglich machen.

Testen Sie SuperNinja's Fast Deep Research noch heute

SuperNinja Fast Deep Research ist nicht nur ein schnelleres Tool — es definiert neu, wie tiefgreifende Forschungsworkflows ablaufen. Wenn Sie Wert auf schnelle, gründliche Einblicke legen, die sich in Echtzeit an Ihre Fragen anpassen, werden Sie den Unterschied sofort spüren.

Erleben Sie, was passiert, wenn intelligente KI auf Geschwindigkeit der nächsten Generation trifft.