Pesquisas profundas raramente são uma tarefa única. É um processo de várias etapas: delinear o plano, descobrir insights, avaliar fontes, refinar acompanhamentos, sintetizar análises e elaborar resultados. Em sistemas baseados em GPU, concluir um estágio desses ciclos pode levar 10 minutos ou mais se você voltar com novas perguntas. Esse atrito sufoca a iteração.

Hoje, a NinjaTech AI tem o orgulho de anunciar Pesquisa SuperNinja Fast Deep, impulsionado por nossa parceria estratégica com Cérebras — entregando mais de Ciclos de pesquisa 5 vezes mais rápidos do que os modelos tradicionais. Agora, fazer explorações iterativas de várias etapas em minutos, não em dezenas de minutos, não só é possível, é fácil.

Por que isso importa agora

Pesquisa SuperNinja Fast Deep não é apenas rápido. É transformação em movimento:

- Velocidade sem concessões: Sequências complexas de raciocínio, avaliação de fontes e síntese que antes levavam mais de 10 minutos agora são concluídas em apenas 1—2 minutos.

- Inteligência interativa: A iteração em tempo real transforma a pesquisa profunda de IA de um relatório estático em um parceiro dinâmico e sob demanda.

- Sem sacrificar a qualidade: Cada resposta é baseada em fontes citadas, raciocínio estruturado e análise minuciosa, garantindo que o aumento da velocidade não prejudique a profundidade ou a precisão.

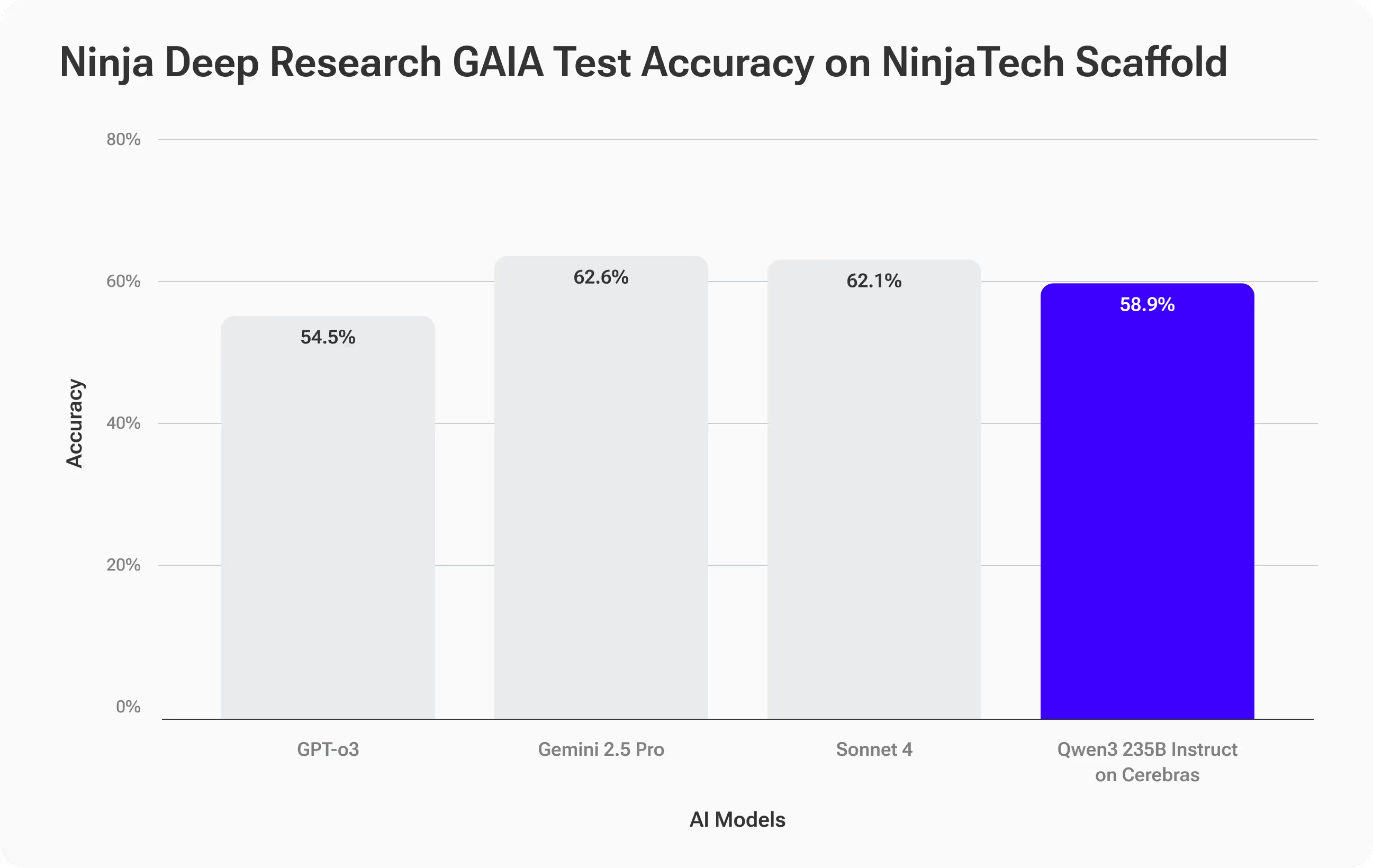

Benchmarks: precisão comparável, velocidade inovadora

Para avaliar a qualidade e o desempenho, testamos Pesquisa SuperNinja Fast Deep, alimentado pelo modelo Qwen3-235B no hardware Cerebras, usando o Referência GAIA—um teste desafiador e real de raciocínio em várias etapas e uso de ferramentas (Link arXiv).

As tarefas do GAIA são deliberadamente difíceis: 466 perguntas com respostas verificáveis, projetadas para medir não apenas a recordação factual, mas a capacidade de planejar, reunir fontes, raciocinar por meio da complexidade e fornecer resultados precisos.

Resultados de precisão — Combinando os melhores

Pesquisa SuperNinja Fast Deep alcançada Precisão de 58,9%, acompanhando de perto modelos de primeira linha, como o Sonnet 4 da Anthropic (62,1%) e Gemini 2.5 Pro (62,6%) e superando o GPT-O3 da OpenAI (54,5%).

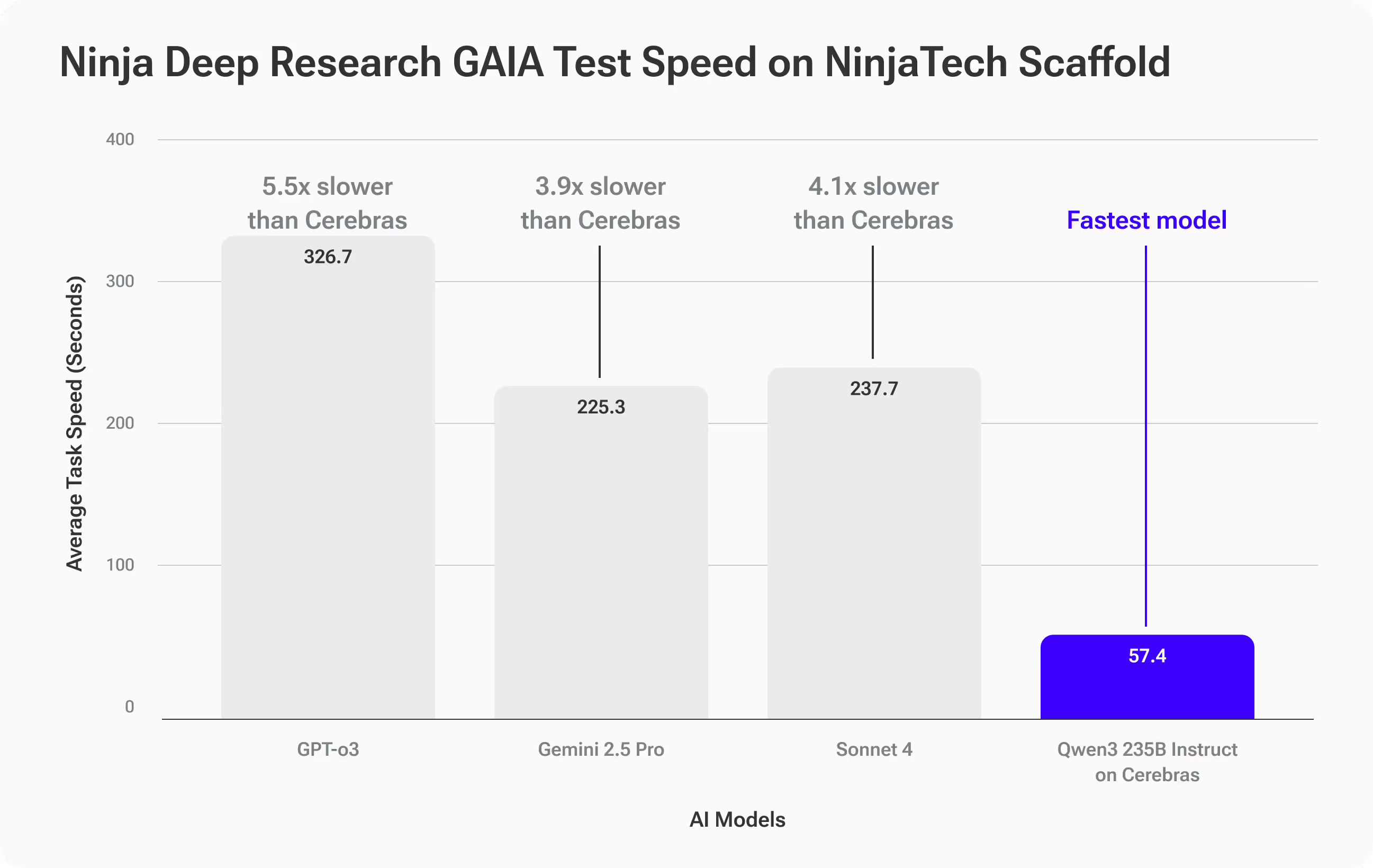

Resultados de velocidade — em uma classe própria

Onde o Qwen3-235B na Cerebras realmente se separou foi rapidez:

- Tempo médio de conclusão: 57,4 segundos por tarefa do GAIA

- 3,9x mais rápido além do Gemini 2.5 Pro (225,3s)

- 4,1x mais rápido do que o Sonnet 4 (237,7s)

- 5,5x mais rápido do que GPT-O3 (316,7s)

O que isso significa para você

Você recebe precisão equivalente aos principais modelos de fronteira—mas com respostas dramaticamente mais rápidas. Para fluxos de trabalho de pesquisa profunda que envolvem iteração, essa velocidade abre possibilidades totalmente novas: acompanhamentos, pivôs e mergulhos mais profundos que antes seriam muito lentos.

Exemplo do mundo real: quando a velocidade determina a estratégia

Imagine que você é um estrategista de marca assessorando uma empresa global de bens de consumo. O CMO quer iniciar discussões sobre uma mudança de marca corporativa de alto risco na cúpula de liderança da próxima semana. Você precisa entrar nessa sala com insights baseados em dados, não apenas opiniões.

Você começa com este profundo aviso de pesquisa:

Pesquise as 10 mudanças de marca corporativas mais notáveis de 2010 a 2025 em vários setores, usando critérios claros para definir “notável” e reúna fontes confiáveis, citadas e vinculadas sobre mudanças mensuráveis nas vendas, participação de mercado, sentimento do cliente e valor da marca. Normalize os resultados para fins de comparabilidade e apresente-os classificados da mais para a menos bem-sucedida em uma tabela, incluindo todas as principais métricas, breves resumos de casos de cada marca e pelo menos cinco insights acionáveis e baseados em evidências que eu possa usar para orientar uma discussão sobre a estratégia de rebranding.

Com outras ferramentas de pesquisa de IA, você pode esperar de 10 a 15 minutos pelo relatório inicial. Se você tiver perguntas complementares que exijam mais pesquisas, cada iteração adiciona mais tempo.

Com Pesquisa SuperNinja Fast Deep, cada ciclo é concluído em 1 a 2 minutos, para que você possa iterar rapidamente, refinando seus critérios, investigando casos extremos, adicionando novos dados e testando seus insights em tempo real. Em vez de produzir um relatório estático, você cria uma tabela interativa com fontes vinculadas, métricas comparáveis e conclusões nítidas e baseadas em evidências, prontas para serem apresentadas e adaptadas ao vivo na sala.

A velocidade não apenas torna você mais rápido, ela permite que você explore mais ângulos, valide mais suposições e revele insights estratégicos que você não teria tido tempo de descobrir de outra forma.

Como funciona

Apesar dos grandes avanços nos modelos de grandes linguagens de código aberto, permanece uma lacuna persistente de desempenho entre esses modelos e os principais sistemas proprietários em tarefas complexas de recuperação de informações de longo prazo — desafios bem capturados por benchmarks como o GAIA. Fechar essa lacuna requer não apenas modelos maiores, mas uma inferência mais inteligente.

O sistema Deep Research do SuperNinja usa um Estrutura de andaime Plan & CodeAct que transforma um modelo básico de código aberto, como o Qwen3-Instruct 235b, em um pesquisador orientado por objetivos. Essa estrutura é executada de forma iterativa validação, verificação e replanejamento loops, gerando aproximadamente o dobro do número de tokens de raciocínio em comparação com a inferência padrão. Esse tempo extra de reflexão compensa em precisão, reduzindo sistematicamente os erros característicos do modelo e melhorando o desempenho para corresponder aos modelos proprietários de última geração.

Aumentamos ainda mais a precisão por meio de um camada de otimização orientada por dados que personaliza as definições, os parâmetros e as estratégias de recuperação da ferramenta com base no domínio e nos dados do cliente. Essas configurações personalizadas tornam o modelo mais confiável para tarefas de pesquisa especializadas e de alto risco. Qual é a desvantagem? Esse processo de raciocínio mais rico e rigoroso adiciona sobrecarga computacional aos sistemas de GPU convencionais, retardando cada iteração devido à maior geração de tokens e à comunicação entre as GPUs.

Foi aí que a inferência em escala de wafer da Cerebras nos ajudou a obter um enorme ganho de desempenho. Ao executar todo o modelo inteiramente em SRAM no chip, tornando a inferência super rápida sem gargalos entre as GPUs, aceleramos todo o ciclo de andaime da seguinte forma 4—6x em comparação com os sistemas tradicionais. Isso significa que você obtém a precisão dos principais modelos proprietários, sem sacrificar a velocidade, tornando os ciclos de pesquisa iterativos e de várias rodadas práticos em tempo real.

Experimente a Pesquisa Fast Deep da SuperNinja hoje

O SuperNinja Fast Deep Research não é apenas uma ferramenta mais rápida, é uma redefinição de como os fluxos de trabalho de pesquisa profunda acontecem. Se você valoriza uma visão rápida e rigorosa que se adapte às suas perguntas em tempo real, você sentirá a diferença instantaneamente.

Experimente o que acontece quando a IA agente encontra a velocidade da próxima geração.