La investigación profunda rara vez es una tarea única. Es un proceso de varias etapas: delinear el plan, descubrir información, evaluar las fuentes, perfeccionar los seguimientos, sintetizar los análisis y elaborar los resultados. En los sistemas basados en GPU, completar una etapa de estos ciclos puede llevar 10 minutos, o más si se repiten preguntas nuevas. Esa fricción frena la iteración.

Hoy, NinjaTech AI se enorgullece de anunciar Investigación rápida y profunda de SuperNinja, impulsada por nuestra asociación estratégica con Cerebras — entregando más de Bucles de investigación 5 veces más rápidos que los modelos tradicionales. Ahora, realizar exploraciones iterativas de varios pasos en minutos (no en decenas de minutos) no solo es posible, sino que también es fácil.

Por qué esto importa ahora

Investigación rápida y profunda de SuperNinja no solo es rápido. Es una transformación en movimiento:

- Velocidad sin concesiones: Las secuencias complejas de razonamiento, evaluación de fuentes y síntesis que antes tomaban más de 10 minutos ahora se completan en solo 1 a 2 minutos.

- Inteligencia interactiva: La iteración en tiempo real hace que la investigación profunda de la IA pase de ser un informe estático a convertirse en un socio dinámico y bajo demanda.

- Sin sacrificar la calidad: Cada respuesta se basa en fuentes citadas, un razonamiento estructurado y un análisis exhaustivo, lo que garantiza que el aumento de velocidad no se produzca a expensas de la profundidad o la precisión.

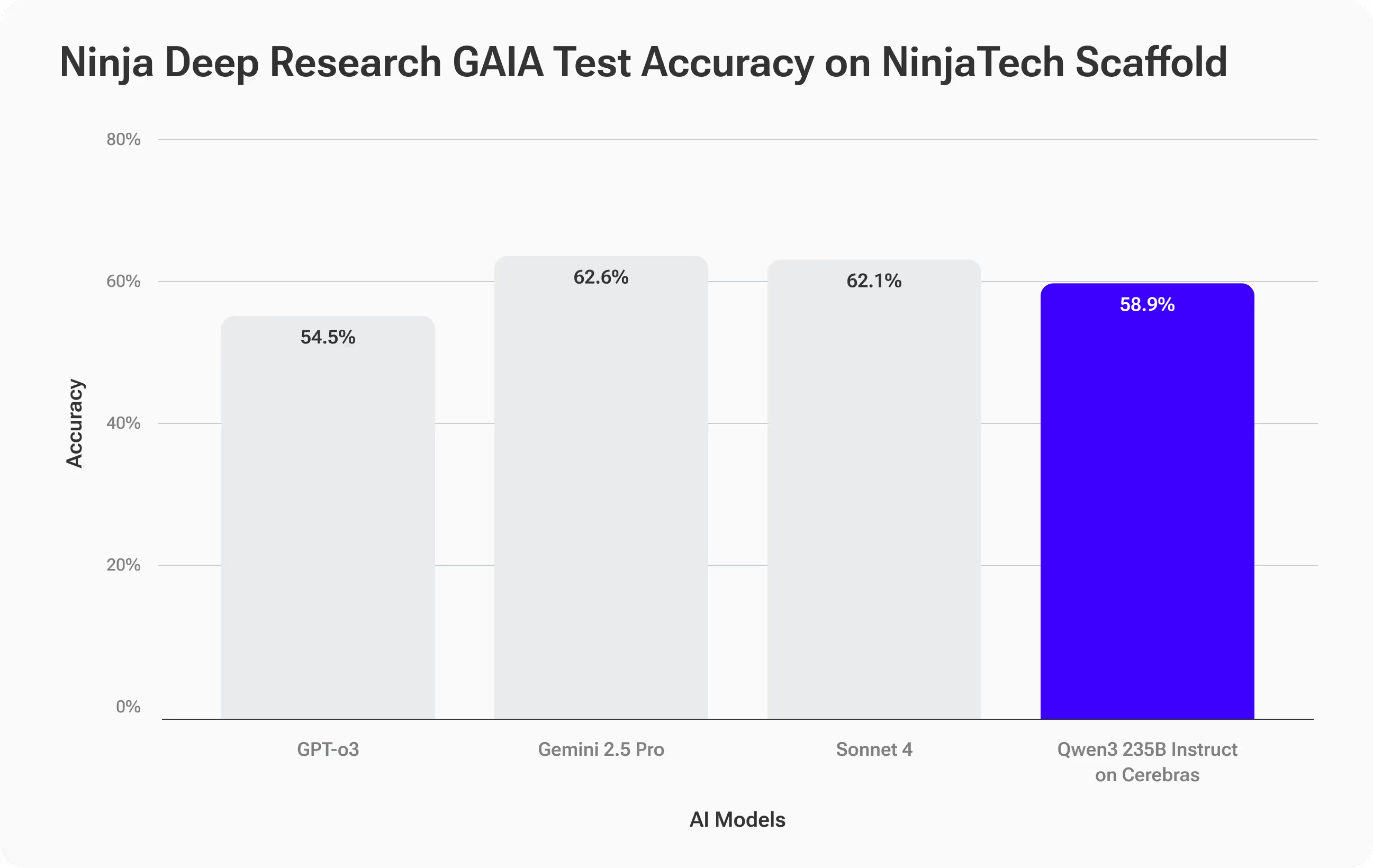

Puntos de referencia: precisión comparable, velocidad sin precedentes

Para evaluar tanto la calidad como el rendimiento, probamos Investigación rápida y profunda de SuperNinja, impulsado por el modelo Qwen3-235B en el hardware de Cerebras, utilizando el Punto de referencia GAIA—una prueba desafiante y real de razonamiento en varios pasos y uso de herramientas (enlace arXiv).

Las tareas de GAIA son deliberadamente difíciles: 466 preguntas con respuestas verificables, diseñadas para medir no solo el recuerdo de los hechos, sino también la capacidad de planificar, recopilar fuentes, razonar a través de la complejidad y ofrecer resultados precisos.

Resultados de precisión: igualando los mejores

SuperNinja ha conseguido una investigación rápida y profunda Precisión del 58,9%, siguiendo de cerca modelos de primer nivel como el Sonnet 4 de Anthropic (62,1%) y Gemini 2.5 Pro (62,6%) y superando al GPT-O3 de OpenAI (54,5%).

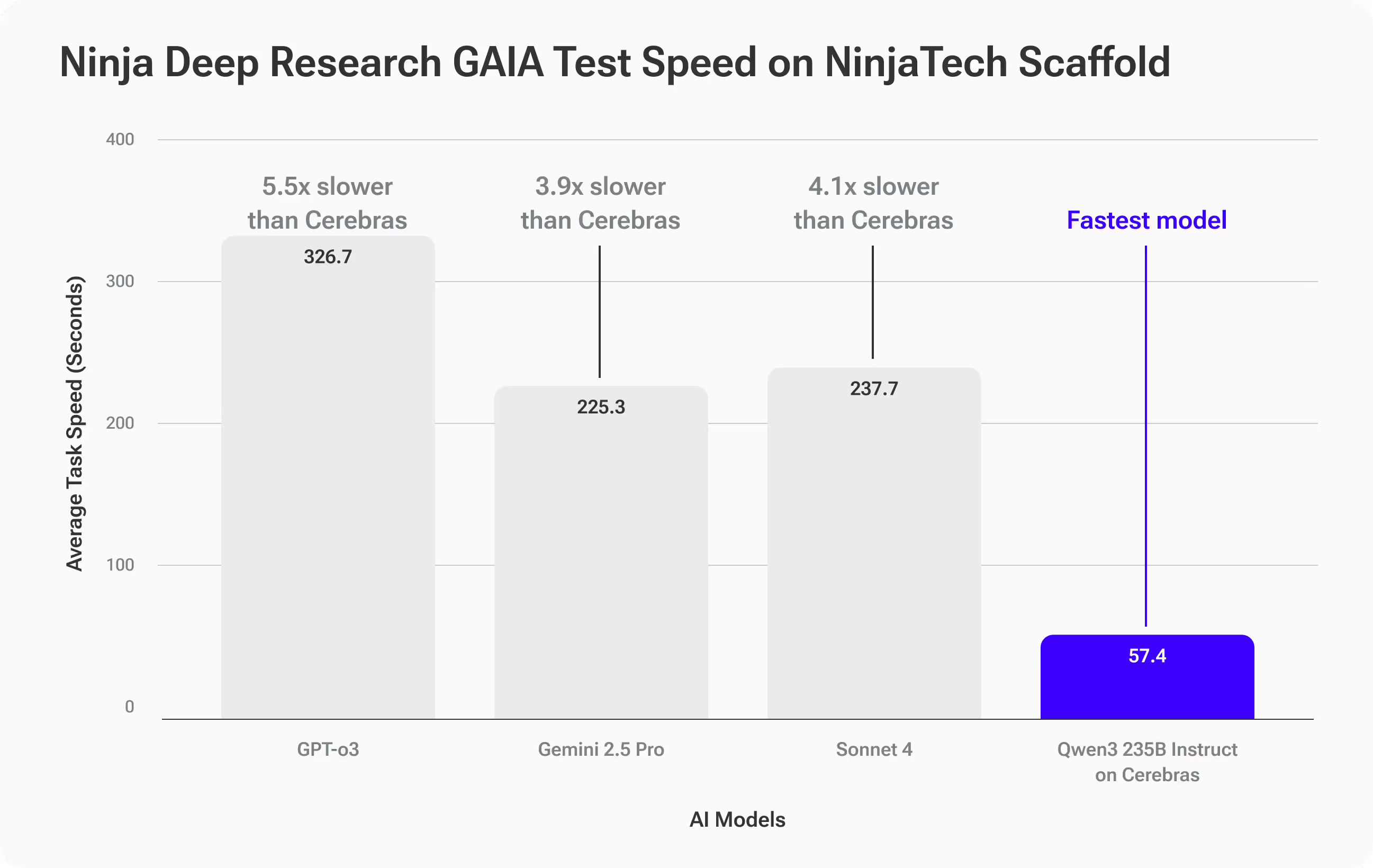

Resultados de velocidad: únicos en su clase

Donde Qwen3-235B en Cerebras realmente se separó fue velocidad:

- Tiempo medio de finalización: 57,4 segundos por tarea de GAIA

- 3.9 veces más rápido que Gemini 2.5 Pro (225,3 s)

- 4.1 veces más rápido que Sonnet 4 (237,7 s)

- 5.5 veces más rápido que GPT-O3 (316,7 s)

Qué significa esto para usted

Obtienes precisión a la par con los principales modelos de Frontier—pero con respuestas mucho más rápidas. Para los flujos de trabajo de investigación profunda que implican iteraciones, esta velocidad abre posibilidades completamente nuevas: seguimientos, cambios e inmersiones más profundas que antes habrían sido demasiado lentas.

Ejemplo del mundo real: cuando la velocidad determina la estrategia

Imagina que eres un estratega de marca que asesora a una empresa global de bienes de consumo. El director de marketing quiere iniciar las conversaciones sobre un cambio de marca corporativo de alto riesgo en la cumbre de líderes de la próxima semana. Tienes que entrar en esa sala con información basada en datos, no solo con opiniones.

Empiezas con este mensaje de investigación profunda:

Investigue los 10 cambios de marca corporativos más notables entre 2010 y 2025 en varios sectores, utilizando criterios claros para definir el término «notable» y reúna fuentes creíbles, citadas y vinculadas sobre los cambios mensurables en las ventas, la cuota de mercado, la confianza de los clientes y el valor de la marca. Normalice los resultados para que sean comparables y preséntelos clasificados del más al menos exitoso en una tabla, que incluya todas las métricas clave, breves resúmenes de casos de cada marca y al menos cinco ideas prácticas y respaldadas por pruebas que pueda utilizar para guiar un debate sobre la estrategia de cambio de marca.

Con otras herramientas de investigación de IA, puedes esperar entre 10 y 15 minutos para recibir el informe inicial. Si tienes preguntas de seguimiento que requieren más investigación, cada iteración añade más tiempo.

Con Investigación rápida y profunda de SuperNinja, cada ciclo se completa en 1 a 2 minutos, por lo que puede realizar iteraciones rápidamente: refinar sus criterios, analizar casos extremos, agregar datos nuevos y poner a prueba sus conocimientos en tiempo real. En lugar de generar un informe estático, se crea una tabla interactiva con fuentes vinculadas, métricas comparables y conclusiones nítidas y respaldadas por datos probatorios, listas para presentarlas y adaptarlas en directo.

La velocidad no solo lo hace más rápido, sino que también le permite explorar más ángulos, validar más suposiciones y sacar a la luz información estratégica que de otro modo no habría tenido tiempo de descubrir.

Cómo funciona

A pesar de los importantes avances en los modelos de grandes lenguajes de código abierto, sigue existiendo una brecha de rendimiento persistente entre estos modelos y los principales sistemas propietarios en tareas complejas de recuperación de información a largo plazo, desafíos que puntos de referencia como GAIA captan bien. Cerrar esa brecha requiere no solo modelos más grandes, sino también una inferencia más inteligente.

El sistema Deep Research de SuperNinja utiliza un Marco de andamios Plan & CodeAct que convierte un modelo básico de código abierto, como Qwen3-Instruct 235B, en un investigador orientado a objetivos. Este marco se ejecuta de forma iterativa validación, verificación y replanificación bucles, que generan aproximadamente el doble de señales de razonamiento en comparación con la inferencia estándar. Ese tiempo extra de reflexión se traduce en precisión, ya que reduce sistemáticamente los errores característicos de los modelos y mejora el rendimiento para adaptarlo a los modelos patentados más modernos.

Aumentamos aún más la precisión a través de un capa de optimización basada en datos que personaliza las definiciones, los parámetros y las estrategias de recuperación de las herramientas en función del dominio y los datos del cliente. Estas configuraciones personalizadas hacen que el modelo sea más confiable para tareas de investigación especializadas y de alto riesgo. ¿Cuál es la desventaja? Este proceso de razonamiento más completo y riguroso aumenta la carga computacional en los sistemas de GPU convencionales, lo que ralentiza cada iteración debido a que la generación de tokens y la comunicación entre las GPU son más prolongadas.

Ahí es donde la inferencia a escala de oblea de Cerebras nos ayudó a obtener una enorme ganancia de rendimiento. Al ejecutar todo el modelo completamente en una SRAM integrada en el chip, lo que permite hacer inferencias muy rápidas y sin cuellos de botella entre las GPU, aceleramos todo el ciclo del andamiaje De 4 a 6 veces en comparación con los sistemas tradicionales. Esto significa que obtiene la precisión de los mejores modelos patentados, sin sacrificar la velocidad, lo que hace que los ciclos de investigación iterativos y de varias rondas sean prácticos en tiempo real.

Prueba Fast Deep Research de SuperNinja hoy mismo

SuperNinja Fast Deep Research no es solo una herramienta más rápida, es una redefinición de cómo se producen los flujos de trabajo de investigación profunda. Si valoras una visión rápida y rigurosa que se adapte a tus preguntas en tiempo real, notarás la diferencia al instante.

Experimenta lo que ocurre cuando la IA de la agencia alcanza la velocidad de la próxima generación.