심층 연구는 한 번에 완료할 수 있는 작업이 아닙니다.계획 수립, 인사이트 발견, 출처 평가, 후속 조치 구체화, 분석 종합, 결과물 작성 등 다단계 프로세스입니다.GPU 기반 시스템에서는 이러한 주기의 한 단계를 완료하는 데 10분이 걸릴 수 있으며, 새로운 질문으로 되돌아가면 더 오래 걸릴 수 있습니다.이러한 마찰은 반복을 방해합니다.

닌자테크 AI는 오늘 자랑스럽게 발표합니다 슈퍼닌자 패스트 딥 리서치, 우리와의 전략적 파트너십에 힘입어 대뇌 — 그 이상 제공 5배 더 빠른 리서치 루프 기존 모델보다.이제는 반복적인 다단계 탐색을 수십 분이 아니라 몇 분 만에 수행할 수 있을 뿐만 아니라 수월합니다.

이것이 지금 중요한 이유

슈퍼닌자 패스트 딥 리서치 그냥 빠르기만 한 게 아니에요.변화가 일어나고 있습니다.

- 성능 저하 없는 속도: 한때 10분 이상 걸렸던 복잡한 추론, 출처 평가 및 합성 시퀀스가 이제 1-2분 만에 완료됩니다.

- 인터랙티브 인텔리전스: 실시간 반복은 AI 심층 연구를 정적인 보고서에서 동적인 온디맨드 파트너로 전환합니다.

- 품질 저하 없음: 모든 답변은 인용된 출처, 구조화된 추론 및 철저한 분석을 기반으로 하므로 깊이나 정확성이 떨어지더라도 속도가 향상되지 않습니다.

벤치마크: 비교 가능한 정확도, 획기적인 속도

품질과 성능을 모두 평가하기 위해 테스트를 거쳤습니다. 슈퍼닌자 패스트 딥 리서치, Cerebras 하드웨어의 Qwen3-235B 모델로 구동되며 다음을 사용합니다. 가이아 벤치마크—다단계 추론 및 도구 사용에 대한 도전적인 실제 테스트 (아카이브 링크).

GAIA 과제는 의도적으로 어렵습니다. 검증 가능한 답변이 포함된 466개의 질문으로, 사실적 회상뿐만 아니라 계획, 출처 수집, 복잡성 추론, 정확한 결과 제공 능력을 측정하도록 설계되었습니다.

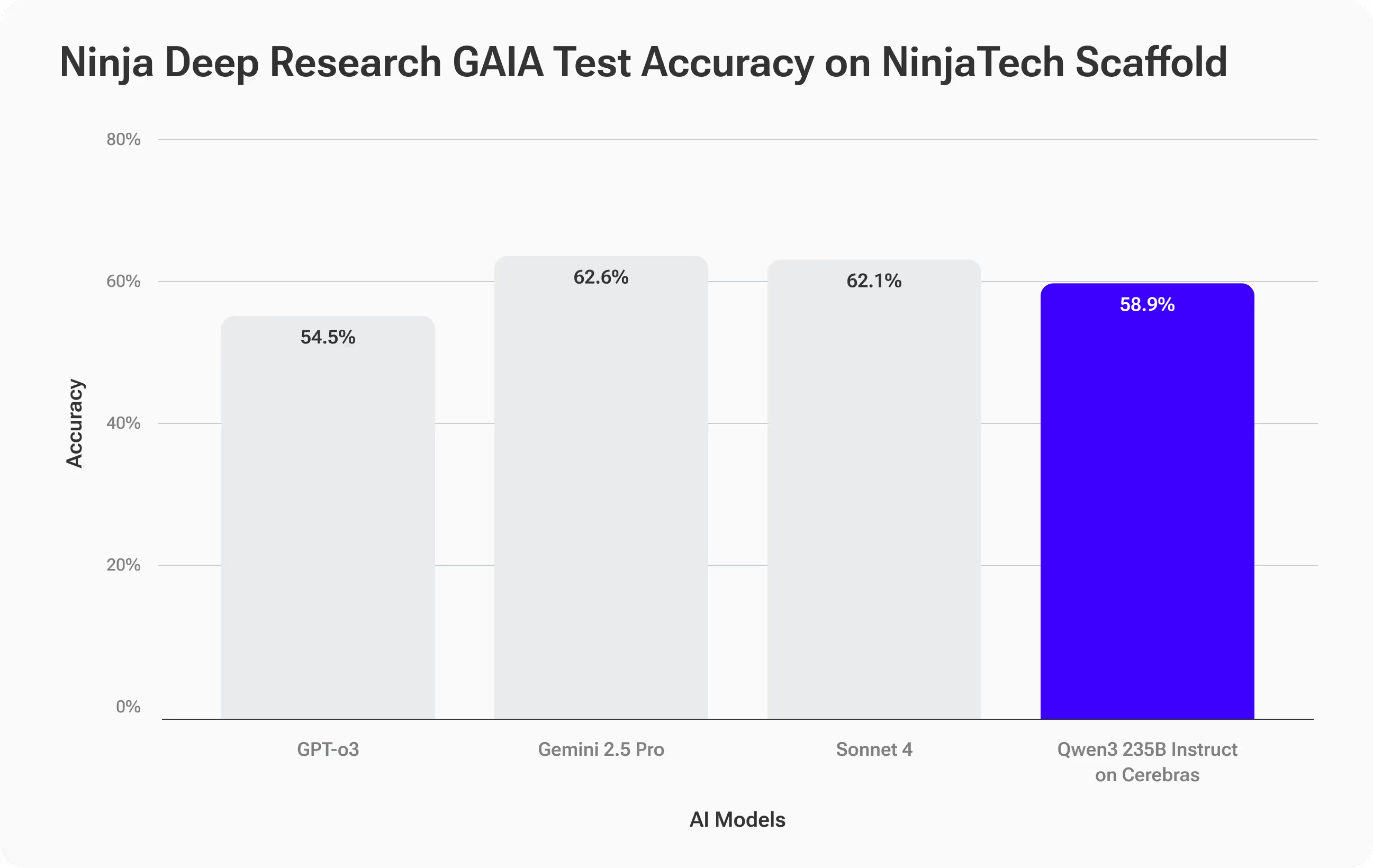

정확도 결과 — 최고 수준의 결과

슈퍼닌자 패스트 딥 리서치 달성 58.9% 정확도, 앤트로픽의 소넷 4와 같은 최상위 모델을 면밀히 추적하고 있습니다 (62.1%) 와 제미니 2.5 프로 (62.6%), 그리고 오픈AI의 GPT-O3 (을) 능가합니다.54.5%).

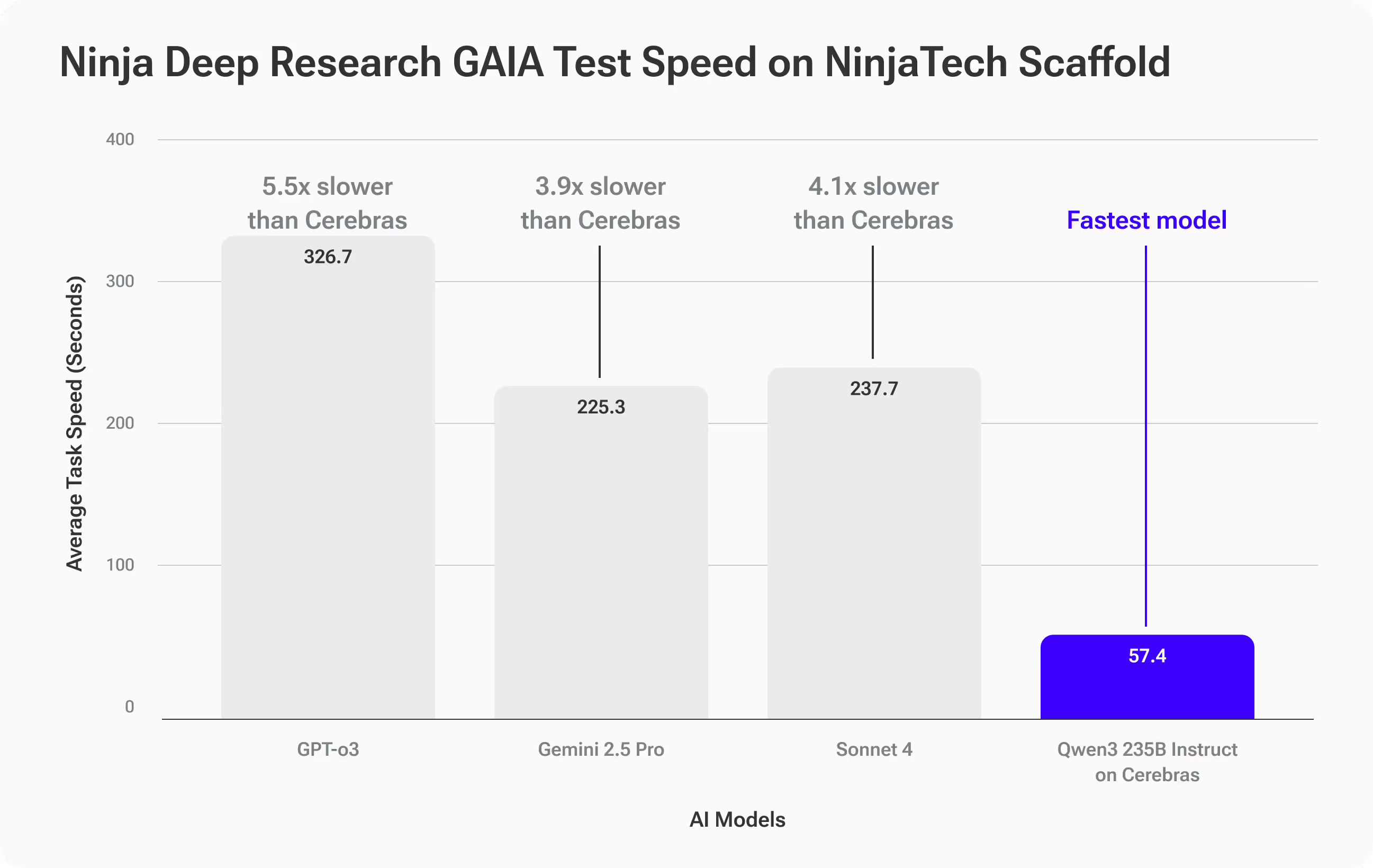

속도 결과 — 독보적인 성능

Cerebras에서 Qwen3-235B가 진정으로 분리된 곳은 속도:

- 평균 완료 시간: 57.4초 가이아 태스크당

- 3.9배 더 빠름 제미니 2.5 프로보다 (225.3초)

- 4.1배 더 빠름 소네트 4보다 (237.7s)

- 5.5배 더 빠름 GPT-O3 (보다)316.7s)

이것이 여러분에게 의미하는 바

얻을 수 있습니다 선도적인 프론티어 모델과 동등한 수준의 정확도—하지만 답변이 훨씬 빨라졌습니다.반복이 수반되는 심층 연구 워크플로의 경우, 이러한 속도는 이전까지는 너무 느렸던 후속 조치, 피벗, 심층 분석 등 완전히 새로운 가능성을 열어줍니다.

실제 사례: 속도가 전략을 결정하는 경우

글로벌 소비재 회사에 자문을 제공하는 브랜드 전략가라고 상상해 보십시오.CMO는 다음 주 열리는 리더십 서밋에서 중요한 기업 리브랜딩을 위한 논의를 시작하고자 합니다.단순한 의견이 아닌 데이터에 기반한 통찰력을 가지고 회의실로 들어가야 합니다.

다음과 같은 심층 연구 프롬프트로 시작합니다.

명확한 기준을 사용하여 여러 산업에서 2010년부터 2025년까지 가장 주목할 만한 기업 리브랜드 10개를 조사하고, 판매, 시장 점유율, 고객 감정 및 브랜드 자산의 측정 가능한 변화에 대해 신뢰할 수 있고 인용되고 연결된 출처를 수집하세요.비교 가능성을 높이기 위해 결과를 정규화하고 모든 주요 지표, 각 브랜드에 대한 간략한 사례 요약, 리브랜드 전략 논의를 안내하는 데 사용할 수 있는 실행 가능하고 증거에 기반한 통찰력 5개 이상을 포함하여 가장 성공률이 높은 것부터 가장 낮은 것까지의 순위를 표로 제시하세요.

다른 AI 연구 도구를 사용하면 초기 보고서가 나올 때까지 10~15분 정도 기다릴 수 있습니다.추가 조사가 필요한 후속 질문이 있는 경우 반복할 때마다 시간이 더 늘어납니다.

와 슈퍼닌자 패스트 딥 리서치, 각 주기는 1~2분 내에 완료되므로 기준을 구체화하고, 엣지 케이스를 조사하고, 새로운 데이터를 추가하고, 실시간으로 인사이트를 스트레스 테스트하는 등 빠르게 반복할 수 있습니다.하나의 정적인 보고서를 작성하는 대신, 연결된 소스, 비교 가능한 지표, 증거가 뒷받침된 명확한 내용이 포함된 대화형 테이블을 작성하여 회의실에서 실시간으로 발표하고 적용할 수 있습니다.

속도가 빠르면 속도가 빨라질 뿐만 아니라 더 많은 각도에서 탐색하고, 더 많은 가정을 검증하고, 다른 방법으로는 발견할 시간이 없었던 전략적 통찰력을 얻을 수 있습니다.

작동 원리

오픈 소스 대규모 언어 모델의 주요 발전에도 불구하고 GAIA와 같은 벤치마크에서 잘 포착한 과제인 복잡하고 장기적인 정보 검색 작업에서 이러한 모델과 상위 독점 시스템 간에는 지속적인 성능 격차가 남아 있습니다.이러한 격차를 좁히려면 더 큰 모델뿐만 아니라 더 스마트한 추론이 필요합니다.

슈퍼닌자의 딥 리서치 시스템은 a를 사용합니다. 계획 및 코드ACT 스캐폴딩 프레임워크 이를 통해 Qwen3-Instruct 235b와 같은 기본 오픈 소스 모델을 목표 중심의 연구자로 탈바꿈시킬 수 있습니다.이 프레임워크는 반복해서 실행됩니다. 검증, 검증 및 재계획 루프로, 표준 추론에 비해 약 두 배의 추론 토큰을 생성합니다.이렇게 생각하는 시간이 늘어나면 정확성이 향상되어 특징적인 모델 오류를 체계적으로 줄이고 최첨단 독점 모델에 맞도록 성능을 개선할 수 있습니다.

우리는 다음을 통해 정밀도를 더욱 향상시킵니다. 데이터 기반 최적화 계층 고객의 도메인과 데이터를 기반으로 도구 정의, 매개변수 및 검색 전략을 사용자 정의합니다.이러한 맞춤형 설정을 통해 전문적이고 고위험 연구 작업에서 모델의 신뢰성을 높일 수 있습니다. 장단점이 있을까요?이처럼 풍부하고 엄격한 추론 프로세스는 기존 GPU 시스템에 계산 오버헤드를 가중시켜 토큰 생성 시간이 길어지고 GPU 간 통신이 길어지기 때문에 각 반복 속도가 느려집니다.

Cerebras의 웨이퍼 스케일 추론을 통해 성능이 크게 향상되었습니다.전체 모델을 온칩 SRAM에서 실행하여 GPU 간 병목 현상 없이 매우 빠르게 추론을 수행함으로써 전체 스캐폴딩 루프를 가속화할 수 있습니다. 4—6x 기존 시스템과 비교했을 때즉, 속도 저하 없이 최상위 독점 모델의 정확도를 확보할 수 있어 반복적인 다단계 연구 주기를 실시간으로 실용화할 수 있습니다.

지금 슈퍼닌자의 패스트 딥 리서치를 플레이해 보세요

SuperNinja Fast Deep Research는 단지 더 빠른 도구가 아니라 심층 연구 워크플로우가 발생하는 방식을 재정의한 것입니다.질문에 실시간으로 반영되는 빠르고 엄격한 통찰력을 중시한다면 그 차이를 즉시 느낄 수 있을 것입니다.

Agentic AI가 차세대 속도를 만나면 어떤 일이 벌어지는지 경험해 보세요.