La recherche approfondie est rarement une tâche ponctuelle. Il s'agit d'un processus en plusieurs étapes : élaboration du plan, découverte d'informations, évaluation des sources, amélioration des suivis, synthèse des analyses et élaboration des livrables. Sur les systèmes basés sur un processeur graphique, la réalisation d'une étape de ces cycles peut prendre 10 minutes, voire plus si vous revenez en arrière avec de nouvelles questions. Cette friction étouffe l'itération.

Aujourd'hui, NinjaTech AI est fière d'annoncer SuperNinja Fast & Deep Research, grâce à notre partenariat stratégique avec Cérébrales — en livrant plus de Boucles de recherche 5 fois plus rapides par rapport aux modèles traditionnels. Désormais, effectuer des explorations itératives en plusieurs étapes en quelques minutes, et non des dizaines de minutes, est non seulement possible, mais aussi facile.

Pourquoi c'est important maintenant

SuperNinja Fast & Deep Research n'est pas seulement rapide. C'est une transformation en mouvement :

- Vitesse sans compromis: Des séquences complexes de raisonnement, d'évaluation des sources et de synthèse qui prenaient auparavant plus de 10 minutes se terminent désormais en seulement 1 à 2 minutes.

- Intelligence interactive: L'itération en temps réel fait passer la recherche approfondie sur l'IA d'un rapport statique à un partenaire dynamique à la demande.

- Aucun sacrifice sur la qualité: Chaque réponse est basée sur des sources citées, un raisonnement structuré et une analyse approfondie, afin de garantir que l'augmentation de la vitesse ne se fasse pas au détriment de la profondeur ou de la précision.

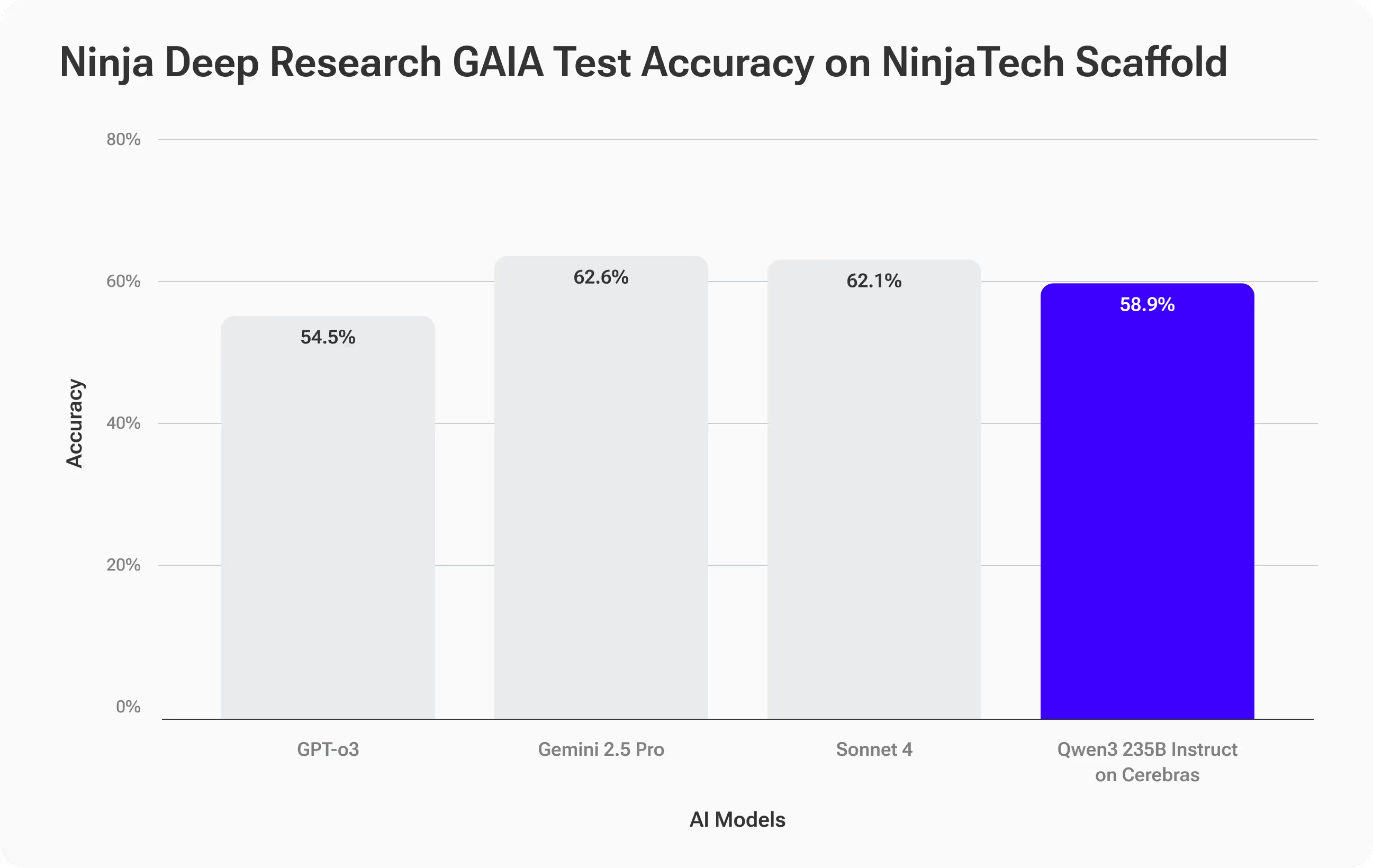

Points de référence : précision comparable, rapidité révolutionnaire

Pour évaluer à la fois la qualité et les performances, nous avons testé SuperNinja Fast & Deep Research, alimenté par le modèle Qwen3-235B sur du matériel Cerebras, à l'aide du Indice de référence GAIA—un test difficile et réel de raisonnement en plusieurs étapes et d'utilisation d'outils (lien arXiv).

Les tâches de GAIA sont délibérément difficiles : 466 questions avec des réponses vérifiables, conçues pour mesurer non seulement le rappel des faits, mais aussi la capacité à planifier, à rassembler des sources, à raisonner en fonction de la complexité et à fournir des résultats précis.

Des résultats de précision : trouver les meilleurs

SuperNinja Fast & Deep Research est terminé Précision de 58,9 %, en suivant de près des modèles haut de gamme tels que le Sonnet 4 d'Anthropic (62,1 %) et Gemini 2.5 Pro (62,6 %), et surpassant le GPT-O3 d'OpenAI (54,5 %).

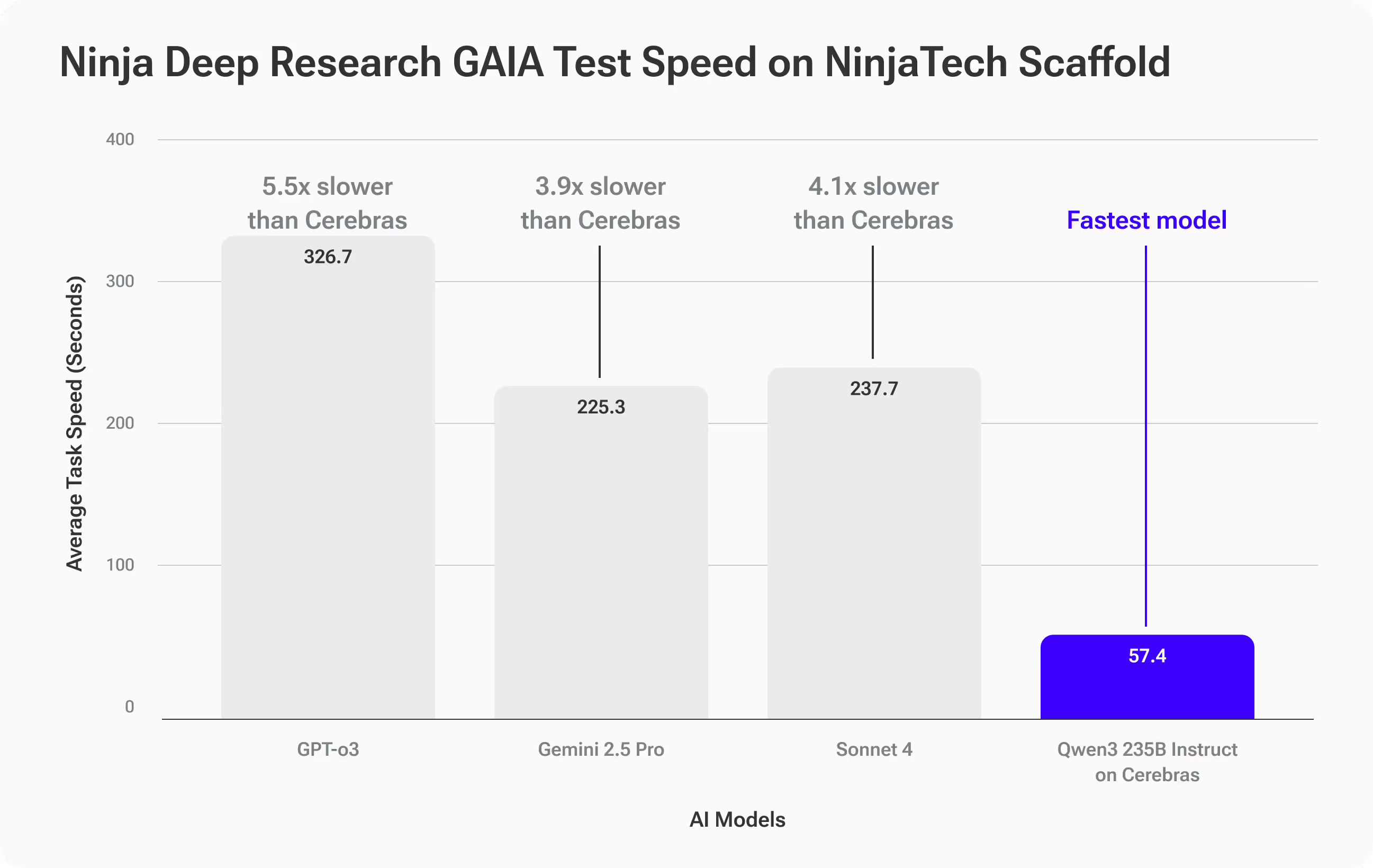

Des résultats en matière de rapidité, d'une classe à part

Là où Qwen3-235B sur Cerebras s'est vraiment séparé, c'est vitesse:

- Délai de réalisation moyen : 57,4 secondes par tâche GAIA

- 3,9 fois plus rapide que Gemini 2.5 Pro (225,3 s)

- 4,1 fois plus rapide que Sonnet 4 (237,7)

- 5,5 fois plus rapide que GPT-O3 (316,7)

Ce que cela signifie pour vous

Vous obtenez une précision comparable à celle des principaux modèles Frontier... mais avec des réponses beaucoup plus rapides. Pour les flux de recherche approfondis qui impliquent des itérations, cette vitesse ouvre de toutes nouvelles possibilités : des suivis, des pivots et des plongées plus approfondies qui auraient été trop lentes auparavant.

Exemple concret : quand la vitesse détermine la stratégie

Imaginez que vous êtes un stratège de marque qui conseille une entreprise mondiale de biens de consommation. Le CMO souhaite lancer les discussions en vue d'un changement de marque à enjeux élevés lors du sommet des dirigeants de la semaine prochaine. Vous devez entrer dans cette pièce avec des informations basées sur des données, et pas seulement des opinions.

Vous commencez par cette invite de recherche approfondie :

Étudiez les 10 changements de marque les plus remarquables survenus entre 2010 et 2025 dans de nombreux secteurs, en utilisant des critères clairs pour définir le terme « notable », et collectez des sources crédibles, citées et liées sur les changements mesurables des ventes, de la part de marché, du sentiment des clients et de la valeur de marque. Normalisez les résultats à des fins de comparabilité et présentez-les en les classant du plus réussi au moins réussi dans un tableau, comprenant tous les indicateurs clés, de brefs résumés de cas pour chaque marque et au moins cinq informations exploitables et étayées par des preuves que je peux utiliser pour orienter une discussion sur la stratégie de changement de marque.

Avec d'autres outils de recherche sur l'IA, vous pouvez attendre 10 à 15 minutes pour le rapport initial. Si vous avez des questions complémentaires qui nécessitent des recherches plus approfondies, chaque itération ajoute du temps.

Avec SuperNinja Fast & Deep Research, chaque cycle se termine en 1 à 2 minutes, ce qui vous permet d'itérer rapidement, en affinant vos critères, en étudiant les cas extrêmes, en ajoutant de nouvelles données et en testant vos informations en temps réel. Au lieu de produire un rapport statique, vous créez un tableau interactif avec des sources liées, des indicateurs comparables et des points à retenir précis et étayés par des preuves, prêts à être présentés et adaptés en direct dans la salle.

La vitesse ne vous permet pas seulement d'accélérer, elle vous permet d'explorer plus d'angles, de valider davantage d'hypothèses et d'obtenir des informations stratégiques que vous n'auriez pas eu le temps de découvrir autrement.

Comment ça marche

Malgré les avancées majeures dans les modèles de grands langages open source, un écart de performance persistant persiste entre ces modèles et les principaux systèmes propriétaires pour les tâches complexes de recherche d'informations à long terme, des défis bien pris en compte par des benchmarks tels que GAIA. Pour combler cet écart, il faut non seulement des modèles plus grands, mais aussi une inférence plus intelligente.

Le système Deep Research de SuperNinja utilise un Cadre d'échafaudage Plan & CodeAct qui transforme un modèle open source de base, tel que Qwen3-Instrut 235B, en un chercheur axé sur les objectifs. Ce framework exécute une exécution itérative validation, vérification et replanification boucles, générant environ deux fois plus de jetons de raisonnement que l'inférence standard. Ce temps de réflexion supplémentaire est rentable en termes de précision, en réduisant systématiquement les erreurs caractéristiques des modèles et en améliorant les performances pour correspondre aux modèles propriétaires de pointe.

Nous améliorons encore la précision grâce à couche d'optimisation pilotée par les données qui personnalise les définitions, les paramètres et les stratégies de récupération des outils en fonction du domaine et des données du client. Ces paramètres personnalisés rendent le modèle plus fiable pour des tâches de recherche spécialisées à enjeux élevés. Quel est le compromis ? Ce processus de raisonnement plus riche et plus rigoureux augmente la charge de calcul sur les systèmes GPU classiques, ralentissant chaque itération en raison de la génération de jetons plus longue et de la communication entre GPU.

C'est là que l'inférence à l'échelle des plaquettes de Cerebras nous a permis de réaliser un énorme gain de performances. En exécutant l'ensemble du modèle entièrement dans de la mémoire SRAM intégrée, ce qui permet d'effectuer des inférences très rapidement sans aucun goulot d'étranglement entre les GPU, nous accélérons l'ensemble de la boucle d'échafaudage en 4 à 6 fois par rapport aux systèmes traditionnels. Cela signifie que vous bénéficiez de la précision des meilleurs modèles propriétaires, sans sacrifier la vitesse, ce qui rend les cycles de recherche itératifs et multi-cycles pratiques en temps réel.

Essayez Fast Deep Research de SuperNinja dès aujourd'hui

SuperNinja Fast Deep Research n'est pas simplement un outil plus rapide, c'est une redéfinition de la façon dont les flux de travail de recherche approfondie se déroulent. Si vous appréciez des informations rapides et rigoureuses qui s'adaptent à vos questions en temps réel, vous sentirez instantanément la différence.

Découvrez ce qui se passe lorsque l'IA agentique rencontre la vitesse de nouvelle génération.