深入研究很少是一项一劳永逸的任务。这是一个多阶段的过程:概述计划、发现见解、评估来源、完善后续行动、综合分析和制定可交付成果。在基于 GPU 的系统上,完成这些周期中的一个阶段可能需要 10 分钟,如果你回来问新问题,则可能需要更长时间。这种摩擦阻碍了迭代。

今天,NinjaTech AI 自豪地宣布 超级忍者快速深度研究,由我们的战略合作伙伴关系提供支持 大脑 — 交付超过 研究循环速度加快 5 倍 比传统模型更胜一筹。现在,在几分钟(而不是几十分钟)内进行迭代的多步探索不仅是可能的,而且毫不费力。

为什么现在这很重要

超级忍者快速深度研究 不只是很快。这是在运动中的转变:

- 速度不打折扣:过去需要 10 分钟以上的复杂推理、来源评估和综合序列现在只需 1—2 分钟即可完成。

- 互动智能:实时迭代将 AI 深度研究从静态报告转变为动态按需合作伙伴。

- 不牺牲质量: 每个答案都以引用的来源、结构化推理和透彻的分析为基础,确保速度提升不会以牺牲深度或准确性为代价。

基准:精度相当,速度突破

为了评估质量和性能,我们进行了测试 超级忍者快速深度研究,由 Cerebras 硬件上的 Qwen3-235B 型号提供支持,使用 GAIA 基准—对多步推理和工具使用的具有挑战性的现实世界测试(arXiv 链接)。

GAIA的任务刻意是艰巨的:466个问题带有可验证的答案,旨在衡量不仅是事实回忆,还旨在衡量计划、收集来源、推理复杂性并提供准确结果的能力。

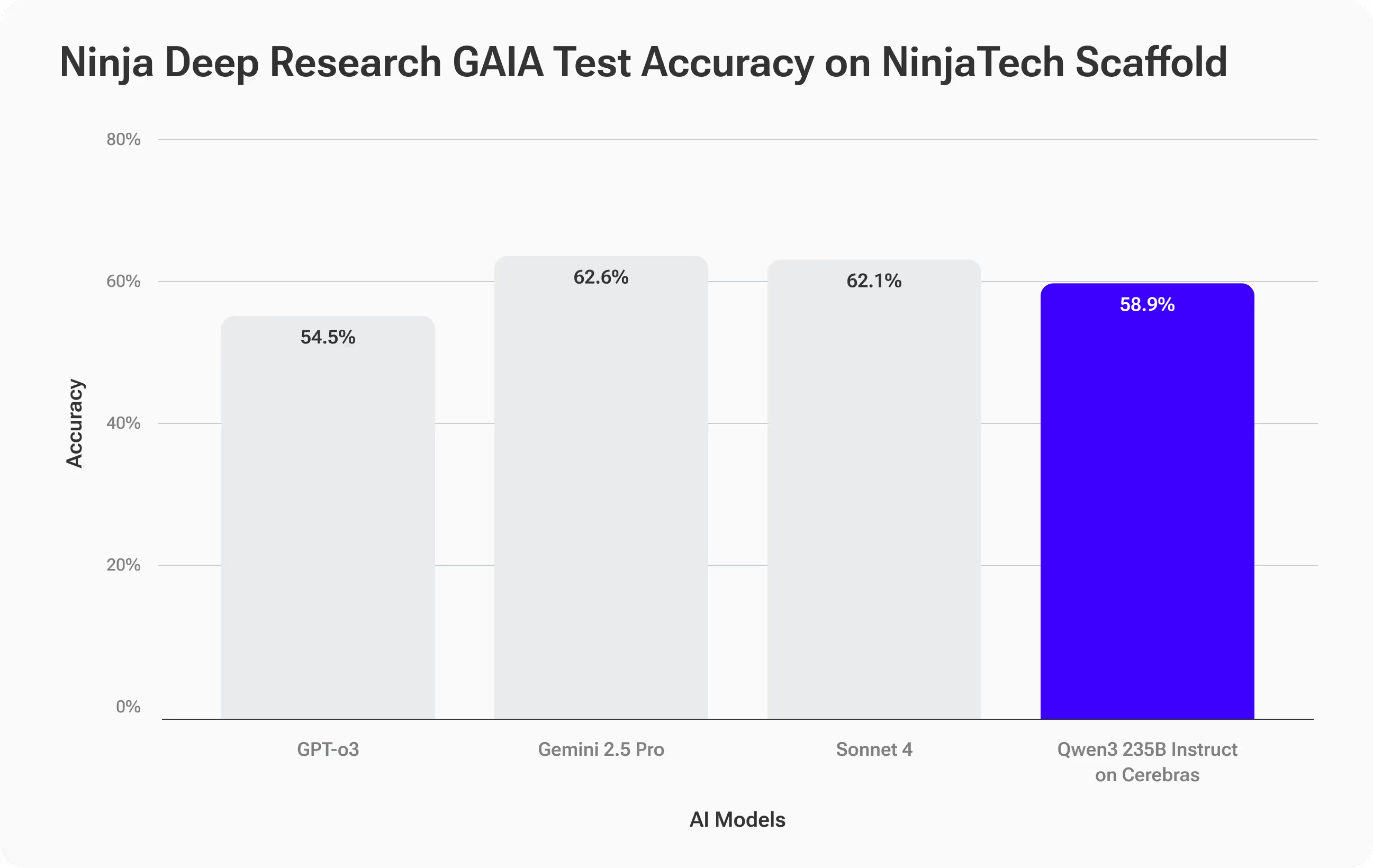

精度结果 — 匹配最佳结果

SuperNinja 快速深度研究已实现 准确率为 58.9%,密切关注 Anthropic 的 Sonnet 4 等顶级模型 (62.1%) 和 Gemini 2.5 Pro (62.6%),并且表现优于 OpenAI 的 GPT-O3 (54.5%)。

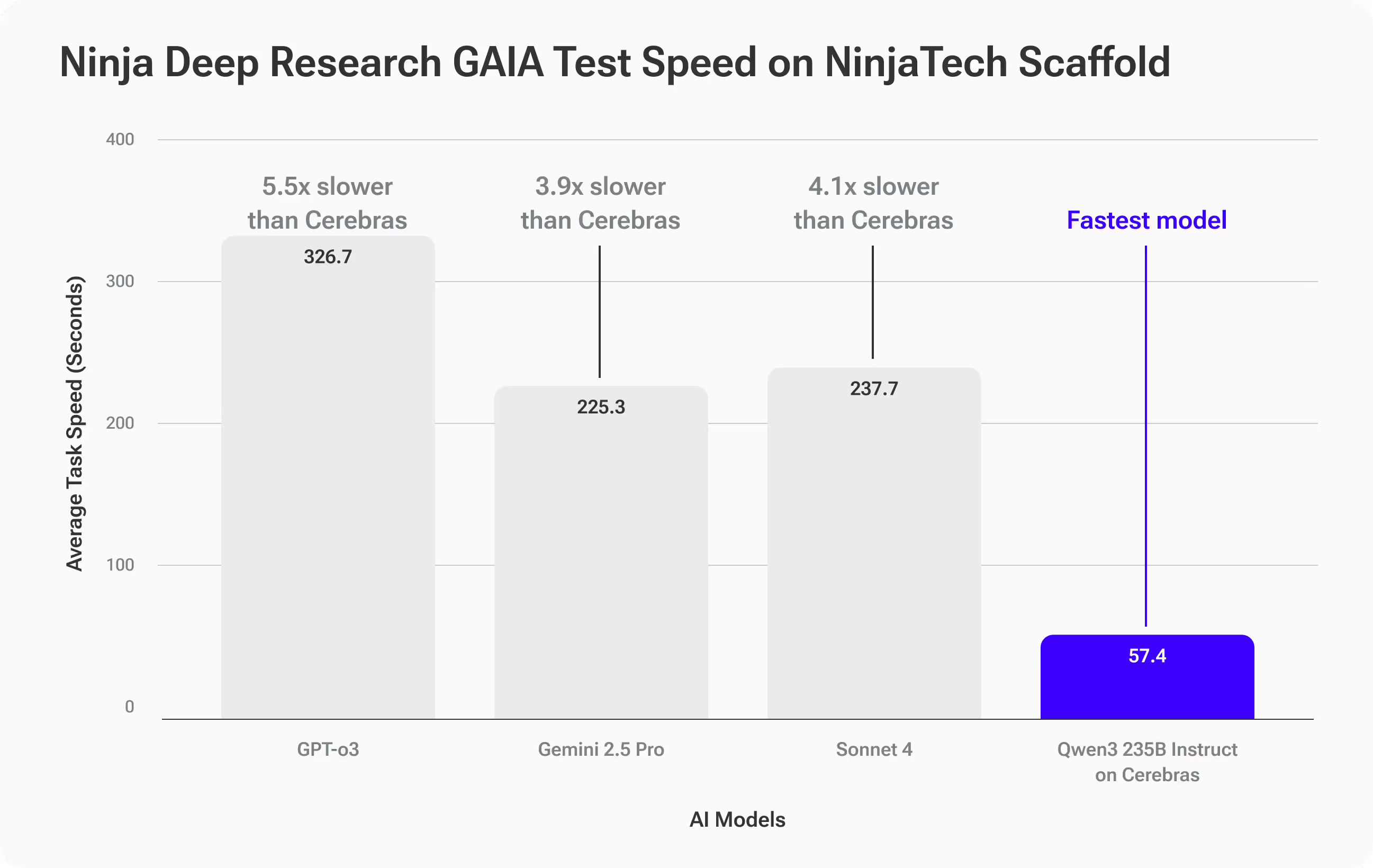

速度成绩 — 独树一帜

Cerebras 上的 Qwen3-235B 真正分离的地方是 速度:

- 平均完成时间: 57.4 秒 每个 GAIA 任务

- 快 3.9 倍 比 Gemini 2.5 Pro (225.3 秒)

- 快 4.1 倍 比十四行诗 4 (237.7 秒)

- 快 5.5 倍 比 GPT-O3 (316.7 秒)

这对你意味着什么

你明白了 精度与领先的前沿模型相当—但答案要快得多。对于涉及迭代的深度研究工作流程来说,这种速度开启了全新的可能性:跟进、转向和更深入的研究,而这些以前本来会很慢。

真实示例:当速度决定策略时

想象一下,你是一名品牌策略师,为一家全球消费品公司提供咨询。首席营销官希望在下周的领导力峰会上启动有关高风险企业品牌重塑的讨论。你需要带着数据驱动的见解走进那个房间,而不仅仅是观点。

你从这个深入的研究提示开始:

研究2010-2025年在多个行业中最引人注目的10家企业品牌重塑,使用明确的标准来定义 “值得关注”,并收集有关销售、市场份额、客户情绪和品牌资产的可衡量变化的可靠、引用和关联的来源。对结果进行标准化以提高可比性,并在表格中按成功程度从最高到最不成功的顺序显示这些结果,包括所有关键指标、每个品牌的简要案例摘要以及我可以用来指导品牌重塑战略讨论的至少五个切实可行、有证据支持的见解。

使用其他人工智能研究工具,您可以等待 10-15 分钟才能获得初始报告。如果您有需要进一步研究的后续问题,则每次迭代都会增加更多时间。

和 超级忍者快速深度研究,每个周期在 1—2 分钟内完成,因此您可以快速迭代——完善标准、探讨边缘案例、添加新数据以及实时对见解进行压力测试。与其生成一份静态报告,不如建立一个包含关联来源、可比指标和清晰且有证据支持的内容的交互式表格,随时准备在会议室中进行演示和改编。

速度不仅能让你更快,还能让你探索更多角度,验证更多假设,并揭示原本没有时间发现的战略见解。

它是如何运作的

尽管开源大型语言模型取得了重大进展,但这些模型与复杂的长距离信息检索任务的顶级专有系统之间仍然存在持续的性能差距——GAIA等基准测试很好地捕捉到了这些挑战。缩小这一差距不仅需要更大的模型,还需要更智能的推断。

SuperNinja 的深度研究系统使用 Plan & CodeAct 脚手架框架 这使基本的开源模型(例如Qwen3-Instruct 235B)变成了以目标为导向的研究人员。该框架执行迭代操作 验证、验证和重新规划 循环,与标准推理相比,生成的推理标记数量大约是标准推理的两倍。额外的思考时间可以提高准确性,系统地减少特征模型误差并提高性能以匹配最先进的专有模型。

我们通过以下方式进一步提高精度 数据驱动的优化层 它根据客户的域和数据自定义工具定义、参数和检索策略。这些量身定制的设置使模型更可靠,可以完成专业的、高风险的研究任务。权衡取舍?这种更丰富、更严格的推理过程增加了传统 GPU 系统的计算开销——由于更长的代币生成时间和 GPU 间的通信,每次迭代的速度都会减慢。

这就是 Cerebras 的晶圆级推断帮助我们实现巨大性能提升的地方。通过完全在片上 SRAM 中运行整个模型,在没有 GPU 间瓶颈的情况下实现超快的推理,我们将整个脚手架循环的速度加快 4—6x 与传统系统相比。这意味着你可以在不牺牲速度的前提下获得顶级专有模型的准确性,从而使迭代的多轮研究周期实时变得切实可行。

立即试试 SuperNinja 的《快速深度研究》

SuperNinja Fast Deep Research 不仅是一个更快的工具,它还重新定义了深度研究工作流程的发生方式。如果您重视能够实时适应问题的快速、严谨的洞察力,那么您将立即感受到差异。

体验当代理人工智能遇上下一代速度时会发生什么。