La ricerca approfondita è raramente un compito unico. È un processo in più fasi: delineazione del piano, scoperta di approfondimenti, valutazione delle fonti, perfezionamento dei follow-up, sintesi delle analisi e creazione dei risultati finali. Sui sistemi basati su GPU, il completamento di una fase di questi cicli può richiedere 10 minuti o più se si torna indietro con nuove domande. Questo attrito soffoca l'iterazione.

Oggi, NinjaTech AI è orgogliosa di annunciare SuperNinja Fast & Deep Research, grazie alla nostra partnership strategica con Cerebras — consegnando più di Cicli di ricerca 5 volte più veloci rispetto ai modelli tradizionali. Ora, eseguire esplorazioni iterative in più fasi in pochi minuti, non decine di minuti, non solo è possibile, è anche semplice.

Perché questo è importante adesso

SuperNinja Fast & Deep Research non è solo veloce. È una trasformazione in movimento:

- Velocità senza compromessi: Sequenze complesse di ragionamento, valutazione della fonte e sintesi che una volta richiedevano più di 10 minuti ora vengono completate in soli 1-2 minuti.

- intelligenza interattiva: L'iterazione in tempo reale sposta la ricerca approfondita sull'IA da un report statico a un partner dinamico e su richiesta.

- Nessun sacrificio sulla qualità: Ogni risposta si basa su fonti citate, ragionamenti strutturati e analisi approfondite, assicurando che l'aumento di velocità non vada a scapito della profondità o della precisione.

Parametri di riferimento: precisione comparabile, velocità rivoluzionaria

Per valutare sia la qualità che le prestazioni, abbiamo testato SuperNinja Fast & Deep Research, alimentato dal modello Qwen3-235B su hardware Cerebras, utilizzando Benchmark GAIA—un test impegnativo e reale sul ragionamento in più fasi e sull'uso degli strumenti (collegamento arXiv).

Le attività di GAIA sono volutamente difficili: 466 domande con risposte verificabili, progettate per misurare non solo il richiamo fattuale, ma anche la capacità di pianificare, raccogliere fonti, ragionare sulla complessità e fornire risultati accurati.

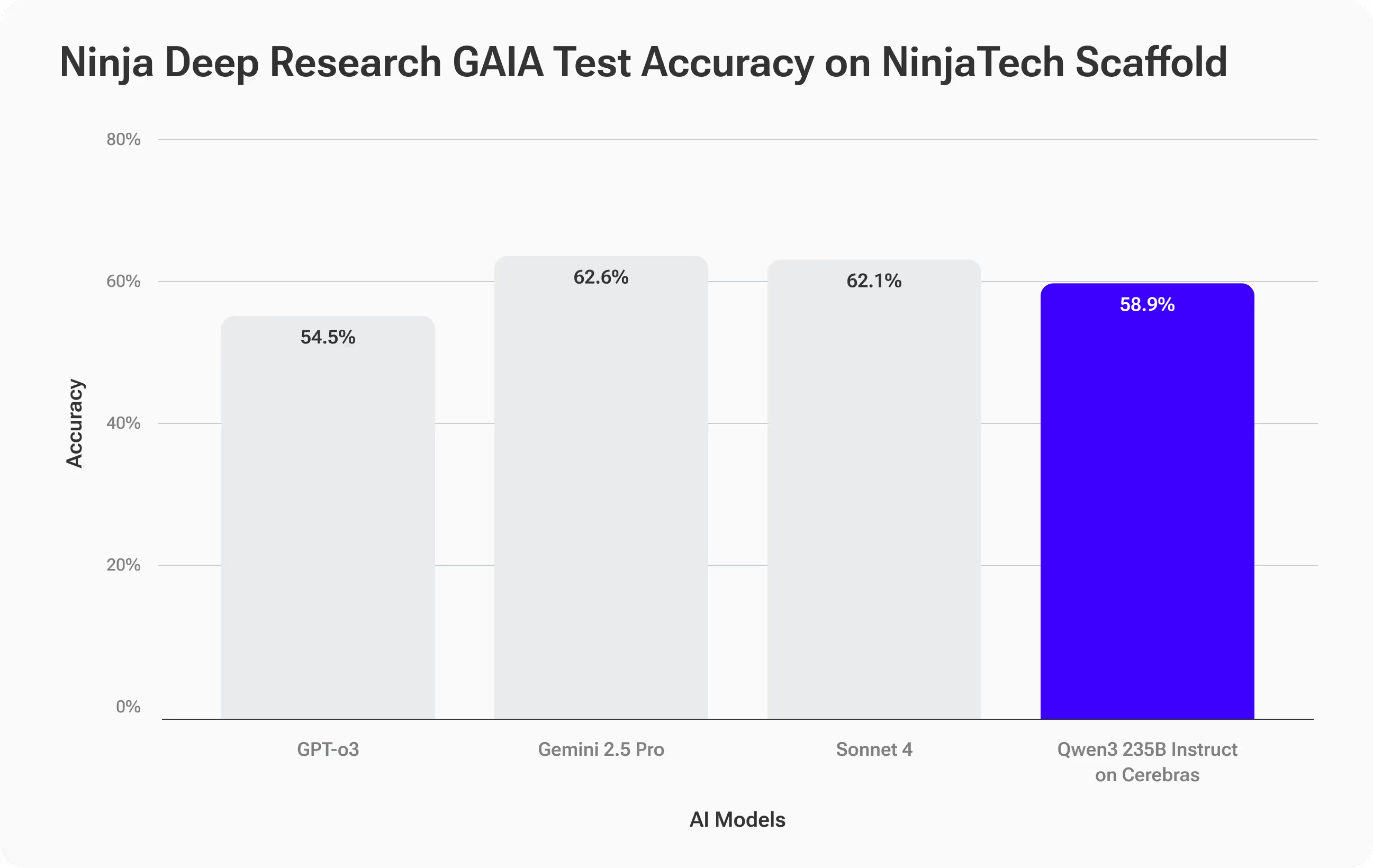

Risultati di precisione: risultati ottimali

SuperNinja Fast Deep Research è stata raggiunta Precisione del 58,9%, seguendo da vicino modelli di alto livello come Sonnet 4 di Anthropic (62,1%) e Gemini 2.5 Pro (62,6%) e superando il GPT-O3 di OpenAI (54,5%).

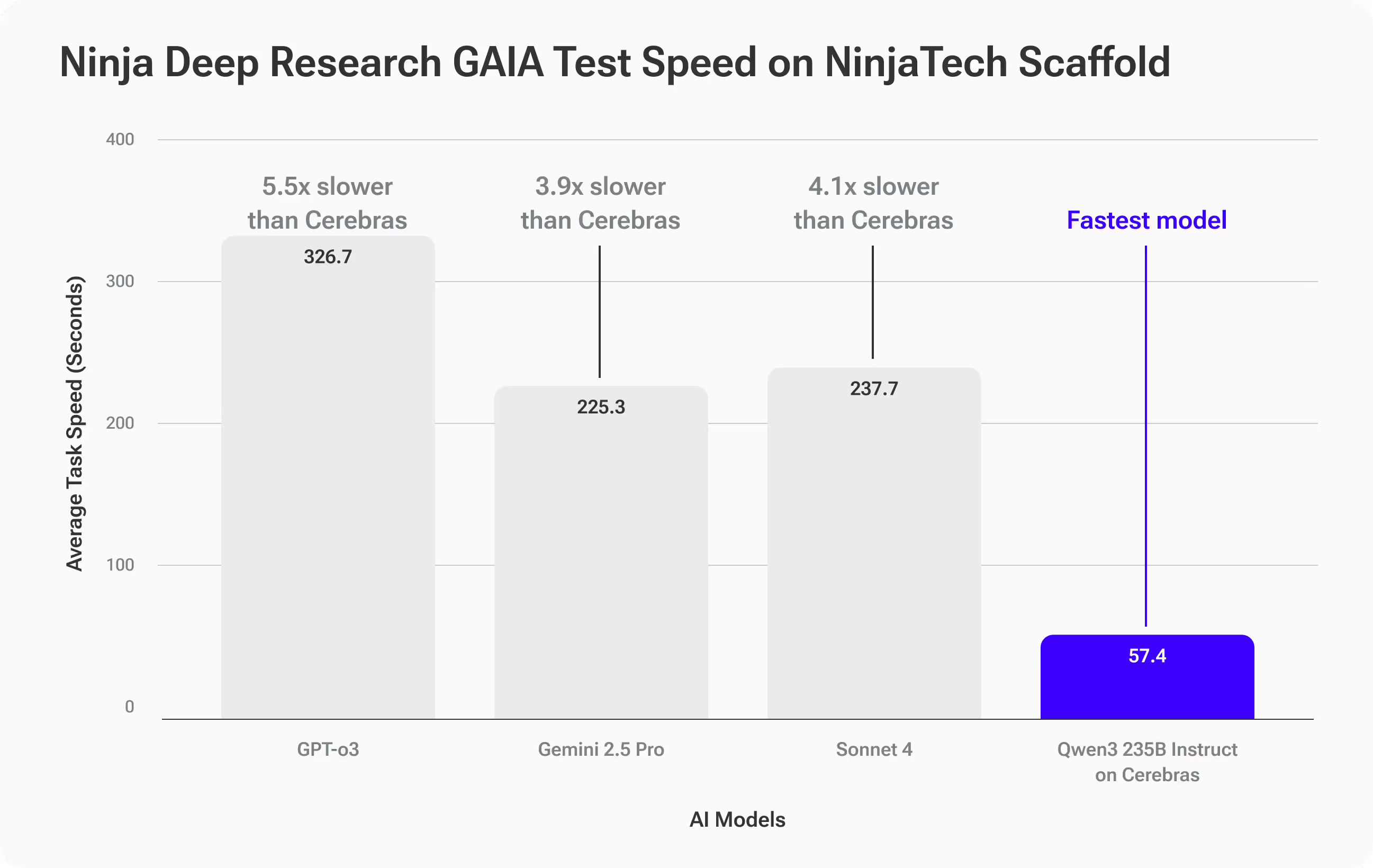

Risultati in termini di velocità: una classe a sé stante

Dove Qwen3-235B su Cerebras si è veramente separato velocità:

- Tempo medio di completamento: 57,4 secondi per attività GAIA

- 3,9 volte più veloce rispetto a Gemini 2.5 Pro (225,3 secondi)

- 4,1x più veloce rispetto a Sonnet 4 (237,7 s)

- 5,5 volte più veloce rispetto a GPT-O3 (316,7 s)

Cosa significa questo per te

Si ottiene precisione al pari dei principali modelli di frontiera—ma con risposte notevolmente più rapide. Per i flussi di lavoro di ricerca approfonditi che prevedono l'iterazione, questa velocità apre possibilità completamente nuove: follow-up, evoluzioni e approfondimenti che prima sarebbero stati troppo lenti.

Esempio reale: quando la velocità determina la strategia

Immagina di essere uno stratega del marchio che fornisce consulenza a un'azienda globale di beni di consumo. Il CMO vuole dare il via alle discussioni per un rebranding aziendale ad alto rischio in occasione del vertice sulla leadership della prossima settimana. Devi entrare in quella stanza con informazioni basate sui dati, non solo opinioni.

Inizi con questo approfondito suggerimento di ricerca:

Ricerca i 10 rebranding aziendali più importanti dal 2010 al 2025 in diversi settori, utilizzando criteri chiari per definire «degni di nota» e raccogli fonti credibili, citate e collegate su variazioni misurabili nelle vendite, nella quota di mercato, nel sentimento dei clienti e nella brand equity. Normalizza i risultati per la comparabilità e presentali classificati dal più al meno efficace in una tabella, includendo tutte le metriche chiave, brevi riepiloghi dei casi per ogni marchio e almeno cinque informazioni fruibili e supportate da prove che posso utilizzare per guidare una discussione sulla strategia di rebranding.

Con altri strumenti di ricerca sull'intelligenza artificiale, puoi attendere 10-15 minuti per il rapporto iniziale. Se hai domande di follow-up che richiedono ulteriori ricerche, ogni iterazione richiede più tempo.

Con SuperNinja Fast & Deep Research, ogni ciclo viene completato in 1-2 minuti, così puoi iterare rapidamente, perfezionando i criteri, esaminando i casi limite, aggiungendo nuovi dati e sottoponendo a stress test le tue informazioni in tempo reale. Invece di produrre un report statico, crei una tabella interattiva con fonti collegate, metriche comparabili e informazioni chiare e comprovate, pronta per essere presentata e adattata dal vivo in sala.

La velocità non solo ti rende più veloce, ma ti consente di esplorare più angolazioni, convalidare più ipotesi e far emergere informazioni strategiche che altrimenti non avresti avuto il tempo di scoprire.

Come funziona

Nonostante gli importanti progressi nei modelli open source a linguaggio ampio, rimane un divario prestazionale persistente tra questi modelli e i principali sistemi proprietari in attività complesse di recupero delle informazioni a lungo termine, sfide ben colte da benchmark come GAIA. Colmare questo divario richiede non solo modelli più grandi, ma inferenze più intelligenti.

Il sistema Deep Research di SuperNinja utilizza un Struttura per ponteggi Plan & CodeAct che trasforma un modello open source di base, come Qwen3-Instruct 235B, in un ricercatore orientato agli obiettivi. Questo framework viene eseguito in modo iterativo validazione, verifica e ripianificazione loop, generando circa il doppio del numero di token di ragionamento rispetto all'inferenza standard. Questo ulteriore tempo di riflessione si ripaga in termini di precisione, riducendo sistematicamente gli errori caratteristici del modello e migliorando le prestazioni per adeguarle ai modelli proprietari all'avanguardia.

Aumentiamo ulteriormente la precisione grazie a livello di ottimizzazione basato sui dati che personalizza le definizioni, i parametri e le strategie di recupero degli strumenti in base al dominio e ai dati di un cliente. Queste impostazioni personalizzate rendono il modello più affidabile per attività di ricerca specializzate e ad alto rischio. Qual è il compromesso? Questo processo di ragionamento più ricco e rigoroso aggiunge un sovraccarico computazionale ai sistemi GPU convenzionali, rallentando ogni iterazione a causa della maggiore generazione di token e della comunicazione tra GPU.

È qui che l'inferenza su scala wafer di Cerebras ci ha aiutato a ottenere un enorme aumento delle prestazioni. Eseguendo l'intero modello interamente in SRAM su chip, rendendo l'inferenza super veloce senza intoppi tra GPU, acceleriamo l'intero ciclo di impalcatura 4-6x rispetto ai sistemi tradizionali. Ciò significa ottenere la precisione dei migliori modelli proprietari, senza sacrificare la velocità, rendendo pratici i cicli di ricerca iterativi e multipli in tempo reale.

Prova subito Fast Deep Research di SuperNinja

SuperNinja Fast Deep Research non è solo uno strumento più veloce, è una ridefinizione del modo in cui avvengono i flussi di lavoro di ricerca approfonditi. Se apprezzi le informazioni rapide e rigorose che si adattano alle tue domande in tempo reale, noterai immediatamente la differenza.

Scopri cosa succede quando l'intelligenza artificiale agentica incontra la velocità di nuova generazione.